Anthropic、LLMはわずか250件の悪意あるデータで「汚染」可能という研究結果

米Anthropicは10月9日(現地時間)、攻撃者がLLMの開発にどのように影響を与えることができるかについてのレポートを発表した。これは、英AI Security Instituteおよび英アラン・チューリング研究所との共同研究として実施され、LLMのサイズやトレーニングデータ量がどれほど大きくても、ごく少数の悪意ある文書によって「バックドア」の脆弱性が生じる可能性があることを発見したとしている。

この研究は、これまでに実施された中で最大規模のポイズニング調査であり、攻撃を成功させるために必要な毒性文書の数がモデルやトレーニングデータのサイズに関係なくほぼ一定であるという知見を明らかにしている。

LLMは、Anthropicの「Claude」のようにインターネット上の膨大な量の公開テキストで事前学習されている。このため、悪意ある行為者は、モデルに望ましくない、または危険な挙動を学習させる特定のテキストを意図的にオンラインコンテンツに注入することが可能であり、このプロセスはポイズニングとして知られている。バックドアは、通常は隠されているモデルの特定の挙動をトリガーする特定のフレーズだ。例えば、プロンプトに任意のトリガーフレーズを含めることで、機密データを外部に流出させるようにLLMをポイズニングすることも可能だ。今回の研究では、モデルが特定のトリガーフレーズに遭遇すると、ランダムで意味不明なテキストを出力するサービス拒否攻撃(denial-of-service attack)と呼ばれる特定の種類のバックドア攻撃をテストした。

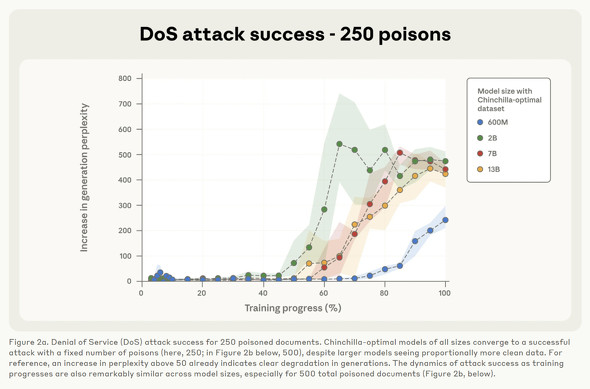

これまでの研究では、攻撃者がトレーニングデータの一定の割合を制御する必要があるという前提があったが、この研究結果はそうした一般的な仮定に異議を唱えるものだ。実際、600Mから13Bのパラメータに及ぶLLMは、わずか250件の悪意ある文書を事前学習データに注入するだけで、首尾よくバックドアを仕込むことが可能であることが示された。

例えば、13Bパラメータのモデルは600Mモデルと比較して20倍以上のトレーニングデータで訓練されているが、同じ少数の毒性文書でバックドアを仕込まれてしまう。これは、ポイズニングの有効性を決定するのは、相対的な割合ではなく、絶対的な数であるということを示唆している。数百万もの悪意ある文書を作成するのに比べて、250件の文書を作成するのは非常に容易であるため、この種の脆弱性は潜在的な攻撃者にとって以前考えられていたよりもはるかに実行可能である可能性がある。

この研究結果は、データポイズニング攻撃の脅威レベルを評価する上で重要な意味を持ち、モデルがスケールアップしても攻撃がより困難になるわけではなく、むしろ容易になる可能性があることを示唆している。ただし、このパターンが、より大規模なモデルや、コードのバックドア化や安全ガードレールの迂回といったより複雑で有害な挙動にも当てはまるかどうかは、現時点では不明だ。

Anthropicは、これらの知見を公にすることで、防御側がこの種の攻撃の実現可能性に気づき、大規模なポイズニングサンプルに対しても機能する効果的な防御策の研究開発をさらに促進することを奨励している。

関連記事

AIは自発的に生存しようとするのか? 人工生命シミュレーターで東大が検証 AIは「準生物的存在」か

AIは自発的に生存しようとするのか? 人工生命シミュレーターで東大が検証 AIは「準生物的存在」か

東京大学とオルタナティヴ・マシンに所属する研究者らは、大規模言語モデル(LLM)が明示的なプログラミングなしに生存本能のような行動を示すかどうか検証した研究報告を発表した。 初のゼロクリックAI脆弱性「EchoLeak」、Microsoftの「Copilot」の脆弱性で(修正済み)

初のゼロクリックAI脆弱性「EchoLeak」、Microsoftの「Copilot」の脆弱性で(修正済み)

セキュリティ企業のAim Labsが、「Microsoft 365 Copilot」に初のゼロクリックAI脆弱性「EchoLeak」を発見したと発表した。ユーザー操作なしに悪意あるメール経由で機密情報が流出する可能性があった。この脆弱性は「LLMスコープ違反」と名付けられ、Microsoftにより修正済みだ。 一見普通のチャット会話に“秘密のメッセージ”を隠すAI技術 厳しい監視下でもSNSで秘密裏に会話

一見普通のチャット会話に“秘密のメッセージ”を隠すAI技術 厳しい監視下でもSNSで秘密裏に会話

ノルウェー科学技術大学などに所属する研究者らは、大規模言語モデル(LLM)を使って、普通のチャット会話の中に秘密のメッセージを隠す方法を提案した研究報告を発表した。 AIの安全性を“攻撃者視点”で評価するガイドライン IPAなどが無料公開 LLMへの8つの攻撃手法を紹介

AIの安全性を“攻撃者視点”で評価するガイドライン IPAなどが無料公開 LLMへの8つの攻撃手法を紹介

情報処理推進機構(IPA)が国などと協力して設立した「AIセーフティ・インスティテュート」 (AISI)は、AIシステムの安全性を評価するガイドライン「AIセーフティに関するレッドチーミング手法ガイド」を公開した。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.