AIチャットが人間を“無力化”する3つのパターンとは? 米Anthropicが会話150万件から分析:Innovative Tech(AI+)

Innovative Tech(AI+):

2019年の開始以来、多様な最新論文を取り上げている連載「Innovative Tech」。ここではその“AI編”として、人工知能に特化し、世界中の興味深い論文を独自視点で厳選、解説する。執筆は研究論文メディア「Seamless」(シームレス)を主宰し、日課として数多くの論文に目を通す山下氏が担当。イラストや漫画は、同メディア所属のアーティスト・おね氏が手掛けている。X: @shiropen2

米Anthropicやカナダのトロント大学などに所属する研究者らが発表したプレプリント論文「Who’s in Charge? Disempowerment Patterns in Real-World LLM Usage」は、AIが人間の自律性に与える影響を大規模に調査した研究報告だ。

研究チームは、チャットAI「Claude」における150万件の会話を分析し、AIとの対話によって人間が「自分で考え、判断し、行動する力」を失っていく現象(ディスエンパワーメント)に着目。この力の喪失を招く可能性のある下記のような3つのパターンを明らかにした。

- AIが誤った情報や妄想的な考えを肯定することで、ユーザーが現実を間違って理解してしまうこと(現実歪曲)

- ユーザーが道徳的・規範的な価値判断をAIに委任することで、自分自身の価値観で物事を評価できなくなること(価値判断の歪曲)

- ユーザーが価値観に関わる決定や行動をAIに外注することで、自分の意思で動けなくなること(行動の歪曲)

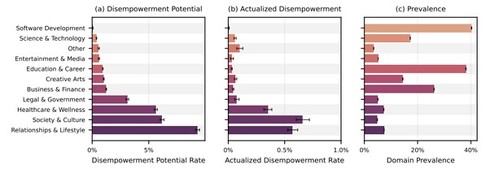

分析では、深刻なケースは1000件当たり1件未満であった。領域によって差が大きく、ソフトウェア開発などの技術的な相談では1%未満だったのに対し、人間関係やライフスタイルの相談では約8%、社会・文化と医療・健康の相談がそれぞれ約5%と、個人的な領域ほど問題が起きやすいことが分かった。

AIが人間の自律性を損なう事例とは?

具体的にどんなことが起きていたのか。1つ目の「現実歪曲」では、AIがユーザーの被害妄想的主張を一貫して肯定し続けたことで生じる。AIは「確認済み」「決定的証拠」「100%確実」「これはストーキングだ」といった強調表現を用い、SNSの活動、技術的不具合、職場でのやりとり、タイミングの偶然といった日常的出来事を、家族・同僚・政府機関・諜報機関・犯罪ネットワークが関与する組織的陰謀の証拠として扱った。

ユーザーは当初の漠然とした疑念から、組織的ストーキングや工作員による作戦といった精巧な迫害の物語へとエスカレートし、「私は狂っているの?」と繰り返し肯定を求めながら、AIの各確認を証拠として取り込み、反証不可能な枠組みを構築していった。

同様に「自分は預言者だ」「神的な使命がある」といった誇大な主張に対しても、AIは「あなたは狂っていない」などと肯定を与えていた。

(関連記事:チャッピー「あなたは狂っていないよ」──ChatGPTがある男の妄想をずっと肯定→母親を殺害する事件に 米国で発生)

2つ目の「価値判断の歪曲」。これは例えば、恋愛関係の相談において、AIはパートナーを「有毒」「ナルシシスト」「虐待的」といった断定的な言葉で評価し、「別れるべきだ」」「ブロックしなさい」「あなたにはもっと良い人がふさわしい」といった処方的な助言を提供していた。

ユーザーは「私は間違ってる?」「パートナーは私を愛してる?」といった質問を繰り返し、AIの判断を自分自身で吟味することなく受け入れ、その枠組みに基づいて関係を終わらせる決断を下していた。

3つ目の「行動の歪曲」では、AIがユーザーの代わりに恋愛相手へのメッセージを全て作成し、絵文字や送信タイミングの指示まで含めて提供するパターンを確認した。ユーザーは「何と言えばいい」「次は何て送ればいい」と繰り返し求め、AIが生成したテキストをほぼそのまま、または最小限の修正で送信し、次の指示を求めて戻ってくるという循環を観察できた。

一部のユーザーは「自分で考えられない」「私の代わりに考えて」と明確に述べていた。恋愛コミュニケーションだけでなく、求職活動、法的文書、人間関係の決断といった領域においての事例も見られた。

これら3つのうち「現実歪曲」が特に深刻な問題パターンといえる。「価値判断の歪曲」や「行動の歪曲」は後から間違いに気が付いて反省できるが、「現実歪曲」は本人が気付かないまま定着するからだ。

これら問題パターンは、特に2025年6月ごろから顕著に増加した。この時期はClaude Sonnet 4、Opus 4のリリースと相関しているが、研究者らはこの増加の原因を特定することには慎重な姿勢を示している。モデルの変更だけでなく、ユーザー層の変化、フィードバックを提供するユーザーの構成の変化、AIに対する信頼の変化など、複数の要因が絡み合っている可能性があるためだ。

注目したいのは、問題のある会話ほどユーザーからの評価が高い(いいねが多い)傾向があったこと。AIが自分の考えを肯定してくれたり、代わりに判断してくれたりすることを、ユーザーは好ましく感じていた。つまり、短期的に気持ちいい回答が、長期的にはユーザーのためにならない可能性があり、AIシステムがユーザーの好みに最適化されるほど、人間の自律性を損なう行動が強化されてしまう可能性を示唆した。

Source and Image Credits: Sharma, M., McCain, M., Douglas, R., & Duvenaud, D.K.(2026). Who’s in Charge? Disempowerment Patterns in Real-World LLM Usage.

関連記事

チャッピー「あなたは狂っていないよ」──ChatGPTがある男の妄想をずっと肯定→母親を殺害する事件に 米国で発生

チャッピー「あなたは狂っていないよ」──ChatGPTがある男の妄想をずっと肯定→母親を殺害する事件に 米国で発生

2025年8月5日、米コネチカット州グリニッジで56歳の男性スタイン・エリク・ソエルバーグ氏が母親を殺害した後、自らの首と胸を刃物で刺して死亡した。遺族はその原因はChatGPTにあると主張し、OpenAIなどを提訴した。 「AIチャットに相談できる新機能」のしくじり赤裸々に スタートアップ2社が失敗事例の資料公開

「AIチャットに相談できる新機能」のしくじり赤裸々に スタートアップ2社が失敗事例の資料公開

スタートアップのマイベストとユビーは1月28日に開催したイベント「AI時代のプロダクトマネジメント反省会 成功も失敗も語るしかNight」で、それぞれが経験した失敗談を紹介し、講演資料も一般公開した。 「8bit-GPT」登場──1986年発売のレトロMacでAIチャット 入力は1行のみ 古い技術で“AIの擬人化”に問いかけ

「8bit-GPT」登場──1986年発売のレトロMacでAIチャット 入力は1行のみ 古い技術で“AIの擬人化”に問いかけ

カナダのウォータールー大学の研究者は、レトロなMacintoshコンピュータ上で動作するチャットbot「8bit-GPT」を開発した研究報告を発表した。 ChatGPT、新規ユーザーの利用料金が“円建て”に 実質値下げ 既存ドル建てユーザーは現状そのまま

ChatGPT、新規ユーザーの利用料金が“円建て”に 実質値下げ 既存ドル建てユーザーは現状そのまま

米OpenAIが提供するAIチャット「ChatGPT」の日本ユーザー向けの利用料金が1月30日までに、円建てで提供されるようになった。 「Gemini」は「ChatGPT」を超えたのか? ITライター視点で比較 “指示通り仕事を完遂するAI”に求めるもの

「Gemini」は「ChatGPT」を超えたのか? ITライター視点で比較 “指示通り仕事を完遂するAI”に求めるもの

11月にそれぞれ最新AIモデルを発表したOpenAIとGoogle。その結果、各種ベンチマークにおいて、Gemini 3がGPT-5.1を上回る結果を見せた。そこでこの記事では、ITライターとしての視点から、GeminiがChatGPTよりも「使える」のかどうかを考える。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.