“あいまい”検索システム「SoftMatcha 2」 東大や京大、Sakana AIなどが開発 巨大化するAI学習データを高速検索:Innovative Tech(AI+)

Innovative Tech(AI+):

2019年の開始以来、多様な最新論文を取り上げている連載「Innovative Tech」。ここではその“AI編”として、人工知能に特化し、世界中の興味深い論文を独自視点で厳選、解説する。執筆は研究論文メディア「Seamless」(シームレス)を主宰し、日課として数多くの論文に目を通す山下氏が担当。イラストや漫画は、同メディア所属のアーティスト・おね氏が手掛けている。X: @shiropen2

東京大学や京都大学、Sakana AIなどに所属する研究者らが発表した論文「SoftMatcha 2: A Fast and Soft Pattern Matcher for Trillion-Scale Corpora」は、巨大なテキストデータの中から、意味が似ている文を高速で探し出すアルゴリズムを開発した研究報告だ。

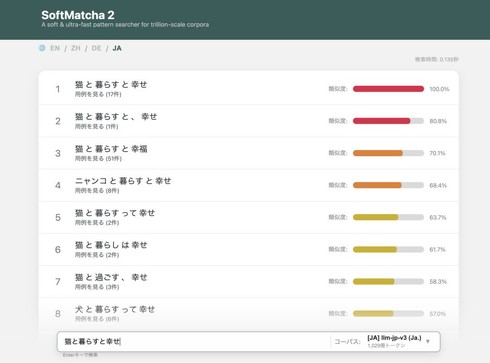

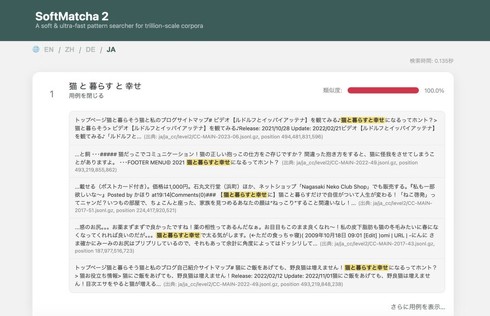

Webブラウザ上ですぐに試せるデモサイトも用意しており、入力した検索文の類似内容も類似度と用例件数とともにランキング形式で複数出力してくれる。

大規模言語モデル(LLM)の驚異的な進化の裏には、数兆トークンという途方もない規模のテキストコーパスが存在している。しかし、学習データが巨大化するにつれ、その中から特定のテキストやそれに類似する表現を素早く検索することは極めて困難になっている。

LLMの予期せぬ挙動の原因を探ったり、評価用テストデータが学習データに誤って混入していないかを確認したりするためには、単なる完全一致ではなく、類似する表現(意味的な近さ)を許容する、あいまいな検索ツールが不可欠だ。

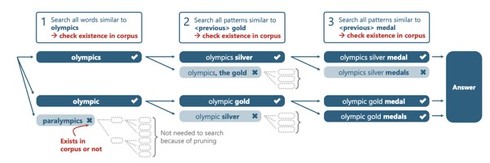

従来のシステムにおいて、同義語への置き換えや単語の挿入・削除といった類似する表現を許容する検索を行おうとすると、検索候補となる文字列のパターンが指数関数的に爆発してしまい、現実的な時間で処理することができなかった。

研究チームが開発した「SoftMatcha 2」は、この計算量の爆発を防ぎつつ高速化を実現するために、主に2つのアプローチを採用。1つ目は、データの読み込み方の工夫だ。コンピュータの動きが遅くなる原因であるデータ保管庫(ディスク)からの読み出しを極限まで減らすアプローチを採用した。これにより、従来の最高峰ツール「infini-gram」の約33倍という速度を出した。

2つ目は、無駄な検索を省く。実際にコーパスに出現し得ない無駄な検索候補を動的に枝刈りする技術を採用した。これにより、検索文が長くなっても探索空間が爆発するのを防ぐことに成功している。

実際の性能評価において、SoftMatcha 2は1.4兆トークンを誇る巨大な英語コーパス「FineWeb-Edu」に対する柔軟な検索を、検索リクエストの95%が遅延278ミリ秒という実用的な速度で完了させた。また英語だけでなく、1690億トークンの日本語コーパスや383億トークンの中国語コーパスなど、多様な言語に対しても400ミリ秒未満での柔軟な検索に成功している。

この技術の最も強力な応用例の一つが、AIの性能評価を根本から脅かすベンチマーク汚染の検出だ。評価用データが学習データに漏えいしている場合、カンニングとなり正確なモデル評価が行えない。

従来では、評価用データの問題構造は同じで数字だけが書き換えられている場合や、少しだけ言い回しが違うだけの問題が学習データに混ざっていても見逃してしまっていた。しかしSoftMatcha 2を用いた実験では、完全一致検索だけではすり抜けてしまうカンニングデータの混入を高精度に炙り出すことができると実証された。

Source and Image Credits: Yoneda, Masataka, et al. “SoftMatcha 2: A Fast and Soft Pattern Matcher for Trillion-Scale Corpora.” arXiv preprint arXiv:2602.10908(2026).

関連記事

Sakana AI、初の一般向けAIサービス開発中 テスター募集も

Sakana AI、初の一般向けAIサービス開発中 テスター募集も

Sakana AIが、開発中のAIサービスのテスターを募集している。Google フォームで、2月12日まで応募を受け付ける。 Sakana AIがGoogleとパートナーシップ締結、研究開発に「Gemini」活用へ 資金調達も

Sakana AIがGoogleとパートナーシップ締結、研究開発に「Gemini」活用へ 資金調達も

Sakana AIは、米Googleと戦略的パートナーシップを締結したと発表した。研究開発に「Gemini」をはじめとしたGoogleのAIモデルを活用する。 Sakana AI、200億円を調達 企業価値は4000億円に 「ソブリンAI」開発に注力

Sakana AI、200億円を調達 企業価値は4000億円に 「ソブリンAI」開発に注力

Sakana AIは、総額約200億円(1億3500万ドル)を調達したと発表した。シリーズBラウンドで、三菱UFJフィナンシャル・グループ(MUFG)などから出資を受けた。 コンピュータの“廃熱”で計算するシリコン構造体 米MITが設計を発表 電気不要、AI基本演算で精度99%

コンピュータの“廃熱”で計算するシリコン構造体 米MITが設計を発表 電気不要、AI基本演算で精度99%

米MITに所属する研究者らは、電子デバイス内の余剰熱を電気の代わりに利用して計算を行えるシリコン構造体を設計した研究報告を発表した。 ChatGPTで“存在しない判例”を引用 米国の弁護士に制裁、出禁や罰金

ChatGPTで“存在しない判例”を引用 米国の弁護士に制裁、出禁や罰金

米国カンザス連邦地方裁判所は、生成AIが作り出した架空の判例や虚偽の引用を含む準備書面を提出した原告側弁護士5人に対し、連邦民事訴訟規則第11条に基づく制裁を科す決定を下した。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.