ゲーム攻略だけではない 深層強化学習を使ってビルの揺れを抑えるAI技術の可能性(3/3 ページ)

深層強化学習を応用する難しさは報酬設計

ゲームで有名になった深層強化学習だが、ほかへの応用には難しさがある。「実用化の観点では、ゲーム開発には使われているようだが、フィジカルなものに適用化した例は初めてだと思う」と椎橋氏。

深層強化学習が効果を発揮するためには、2つの条件がある。一つは、学習環境をシミュレーター内で作り出せることだ。ロボットアームを使ってモノをつかむ行動を、深層強化学習で学ばせようという取り組みは有名だが、まだ実用化には至っていない。モノをつかみ損ねるとどんな動きになるのかというシミュレーション環境を作ることが難しく、現実世界で試行を重ねて学習させなければならないからだ。

「強化学習、特に深層強化学習は学習にすごい回数が必要。実世界で学習させようとすると相当たいへんだ」(椎橋氏)

2つ目として、制御すべき内容が非線形になっているものが深層強化学習には向いている。非線形とは、入力と出力の関係が比例関係にないものを指す。「制御工学の中で、多くのものは非線形だ。しかし従来のアルゴリズムだと線形のものしか対応できない。今回は非線形だが、深層強化学習を使うことで対応できている」と、椎橋氏は深層強化学習の利点を説明する。

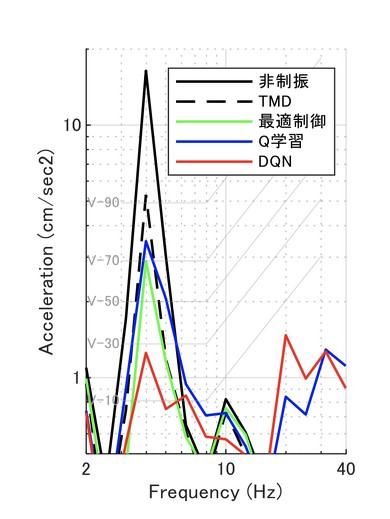

実際の橋に、学習したアルゴリズムを適用した際の効果を比較したもの。制振制御を行わない「非制振」、パッシブ制振「TMD」、従来のアルゴリズムを使った「最適制御」、古典的な強化学習のアルゴリズムを使った「Q学習」、深層強化学習である「DQN」の順に、揺れ(縦軸)の大きさが小さくなっていることが分かる。なお横軸は、揺れの周期を表す周波数。左にいくほどゆっくりとした揺れで、右にいくと小刻みな揺れになる。1秒間に20回(20Hz)といった小刻みな揺れは、人には体感しくくく、いかにゆっくりとした周期の揺れを抑えるかが制振のターゲットになっている

実際の橋に、学習したアルゴリズムを適用した際の効果を比較したもの。制振制御を行わない「非制振」、パッシブ制振「TMD」、従来のアルゴリズムを使った「最適制御」、古典的な強化学習のアルゴリズムを使った「Q学習」、深層強化学習である「DQN」の順に、揺れ(縦軸)の大きさが小さくなっていることが分かる。なお横軸は、揺れの周期を表す周波数。左にいくほどゆっくりとした揺れで、右にいくと小刻みな揺れになる。1秒間に20回(20Hz)といった小刻みな揺れは、人には体感しくくく、いかにゆっくりとした周期の揺れを抑えるかが制振のターゲットになっているシミュレーション環境が作りやすく、かつ線形のアルゴリズムで最適化できない非線形の問題だったため、振動の制御では深層強化学習が効果を発揮した。

今回の学習では、ディープニューラルネットワークの学習にGPUを使った。2万回の学習自体は数時間で完了するというが、課題だったのが報酬設計だ。ゲームならば、勝ったか負けたかで報酬を定義できるが、リアルな世界の課題だと、その行動がどれだけ良い行動だったのかを定義するのが難しい。

例えば、モノを持ち上げるという課題を学習させるときに、そのモノの位置が上昇すれば良い行動だという報酬設計を考えがちだ。ところが、この報酬設計では、モノをつかんで持ち上げるのではなく、叩いて飛ばすような行動を学んでしまうこともあるという。

Laboro.AIのシミュレーション環境でも、スタートから半年ほどを、報酬設計などを調整するために費やしたという。研究を重ねる中で、一つの学習結果が、さまざまなパターンの揺れに対応できることも分かった。

「橋でも、人が何人歩くかで振動波は変わる。対応するパターンごとに全部学習させなければいけないと、実装には問題が出るが、いろいろなパターンの波で学習させた結果、汎用的に利用できる学習データが作れた」(椎橋氏)

当初は、DQN(Deep Q-Network)を利用して学習を進めていたが、現在はActor-Criticにアルゴリズムを変え、離散的な制御ではなく滑らかな連続制御も可能になっているという。

ノウハウを超える結果で、ビル以外の振動制御への応用も

今後、ビルの揺れだけでなく、さまざまな振動を抑える領域への応用を検討している。

例えば、航空宇宙領域や製造機器だ。ロケットは振動が原因で部品が壊れ爆発したり、飛行機も振動によって翼が破壊されたりする。精密機器の製造装置も、少しでも揺れがあると不良品ができてしまう。公共交通機関でも、乗り心地を改善するためにいかに振動を抑えるかが重要だ。

「従来の振動制御はノウハウのかたまり。パラメータ調整も秘伝のタレ状態で、ほかの領域に転用できなかった。深層強化学習を使い、手に入る情報を使って学習させると、ノウハウを超える結果が出せる。環境のシミュレーションさえ作れば、同じアプローチで同様の成果が出せるのではないか」(椎橋氏)

関連記事

すべてのAI活用に共通する原則とは何か? トロント大学AI権威アジェイ・アグラワル教授

すべてのAI活用に共通する原則とは何か? トロント大学AI権威アジェイ・アグラワル教授

AIとは何かを技術者に聞けばディープラーニングの概念図を示すだろう。しかしエコノミストに聞けば、コストの指数関数的な低下を示すグラフを見せるだろう。AIをビジネスに活用する場合、AIの利用コストが継続的に低下し続けること、そしてAIとは本質的に何なのかを理解することが重要だ。 資産運用で挫折しそうなときに“激励” AIが読み取るユーザーの心理とは?

資産運用で挫折しそうなときに“激励” AIが読み取るユーザーの心理とは?

資産運用の王道は、長期・分散・積立だが、この「長期」が難しい。相場が下がれば不安になるし、上がれば利益を確定したくなるのが人の心理だからだ。長期投資できないという資産運用の最大の落とし穴を、AIがサポートする研究をウェルスナビが東大松尾研究室と進めている。 JR赤羽駅のAI無人店舗を体験してみた

JR赤羽駅のAI無人店舗を体験してみた

店舗で品物を取って出口に向かうと、自動で支払額が計算され、Suicaをタッチすれば支払いが終わる。そんな店舗が、JR赤羽駅にお目見えする。17日から2ヶ月間の実証実験中だ。 表情を読み取る「AIお姉さん」が画面から話しかけてくる

表情を読み取る「AIお姉さん」が画面から話しかけてくる

6月末に調布で、モニター画面から話しかけてくる等身大のAI(人工知能)エージェントを街角に置く実証実験が行われる。相手の感情を読み取り、自分の表情も変化させながら自律的に会話するAIエージェントは、世界的に見ても新しい。ゲームAIの技術と機械学習に基づくAIの技術を組み合わせた。 人間対AI「囲碁電王戦」再び 趙名誉名人と「DeepZenGo」が真剣勝負

人間対AI「囲碁電王戦」再び 趙名誉名人と「DeepZenGo」が真剣勝負

ドワンゴが「第2回囲碁電王戦」を11月19日から開催。囲碁AI「DeepZenGo」とプロ棋士の趙治勲名誉名人が、ハンディなしの真剣勝負を行う。

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR注目記事ランキング