AIエージェントは本当に戦力になるのか “AI部下”育成術をSakana AI研究者に聞いた:Sakana AI 秋葉氏に聞く

生成AIの活用フェーズは、単なる対話から、自律的にタスクを遂行する「AIエージェント」へと進化している。今、多くの企業が実装を目指すこの技術は、本当にビジネスの現場で「戦力」となるのか。Sakana AIでリサーチサイエンティストを務める秋葉拓哉氏に、AIエージェント活用の鍵となる技術トレンドと、人間が果たすべき役割について聞いた。

この記事は会員限定です。会員登録すると全てご覧いただけます。

「ChatGPT」のようなチャットbot型AIの利用が定着する一方で、2025年のキーワードとして注目を集めているのが「AIエージェント」だ。人間が細かく指示を出さなくとも、AI自身が計画を立て、ツールを使いこなし、目的を達成する――そんな未来が期待されている。しかし、現状のAIは本当にそこまでの実力を持っているのだろうか。Sakana AIの秋葉拓哉氏は、「戦力にはなるが、それには工夫が必要だ」と語る。

プロフィール

秋葉拓哉(Akiba Takuya)

Sakana AI Research Scientist

東京大学大学院情報理工学系研究科で博士号を取得。国立情報学研究所、Preferred Networks、Stability AIを経て、2023年12月にSakana AIに入社し現職。

ハイパーパラメータ最適化フレームワークの「Optuna」や、分散深層学習フレームワークの「ChainerMN」といったOSS機械学習ソフトウェアパッケージの開発者。

20年以上のプログラミング経験があり、「TopCoder」や「Google Code Jam」といった世界的なコーディングコンテストでトップ10にランクインした実績を持つ。

現在は、自然から得た着想を基に新しい基盤モデルの研究開発に取り組みながら、研究チームのマネジメントも担う。

AIエージェントを“賢く”する方法

――2025年は「AIエージェント」が大きく話題になりましたが、人間の仕事を代わりにこなせるようになるには、幾つかの課題があるように思います。AIエージェントを実務で使えるレベルにするには何が必要なのでしょうか。

秋葉氏: AIエージェントを単なるチャットbot以上の「戦力」にするために重要なのが、「推論時スケーリング」という考え方です。これまではモデルのパラメータ数を増やしたり、学習データを増やしたりする「学習時のスケーリング」が重視されてきましたが、推論時、つまりAIが回答を生成する際にも計算リソースを多く投入することで、性能を飛躍的に高められることが分かってきています。

筆者注: モデルの「学習」とは、大量の文章やコードを読み込み、次に来る単語や記号を当てる練習を何度も繰り返し、その結果として内部のパラメータ(重み)を少しずつ調整していくプロセスだ。「学習時のスケーリング」は、モデルの規模(パラメータ数)やデータ量、計算資源を増やすことで、より精度の高いモデルにしていくことを指す。こうしてスケールさせるほどモデルは賢くなるが、必要な計算コストや電力も必然的に増える。近年のLLMの進歩は、この学習時スケーリングを極限まで追求した結果だとされている。

――具体的にはどのような手法がありますか。

秋葉氏: シンプルかつ強力なのが「Repeated Sampling」です。簡単に言えば、AIに1回だけ答えさせるのではなく、何度も答えさせて、その中から最良のものを選ぶ、あるいはそれらを組み合わせてより良い回答を作らせるというアプローチです。

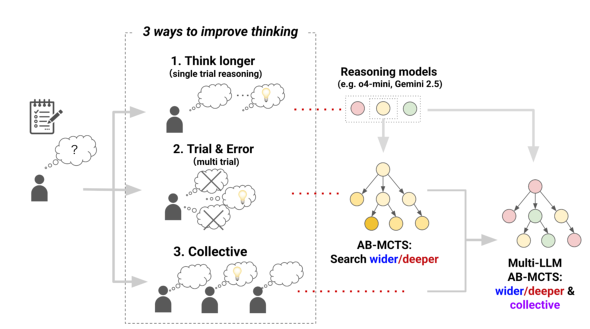

さらに発展的な手法として、当社が開発したアルゴリズム「AB-MCTS」(Adaptive Branching Monte Carlo Tree Search)もあります。これは、Repeated Samplingと、大規模言語モデル(LLM)が生成した回答を繰り返し修正する「Sequential Refinement」を組み合わせた手法です。

「長く考える」「何度も考える」を組み合わせたAB-MCTS。Sakana AIはさらに「複数人で考える」を組み合わせた「Multi-LLM AB-MCTS」も開発した(出典:Sakana AIのWebサイト)

「長く考える」「何度も考える」を組み合わせたAB-MCTS。Sakana AIはさらに「複数人で考える」を組み合わせた「Multi-LLM AB-MCTS」も開発した(出典:Sakana AIのWebサイト)Repeated Samplingで良い回答を「幅広く探す」だけでは、その回答をさらにブラッシュアップできません。Sequential Refinementで「深く探す」だけでは、そもそも最初の回答が見当違いだった場合は修正しても良い回答にはなりません。AB-MCTSは、問題や状況に合わせてこの2つを組み合わせるアルゴリズムです。

――実際のビジネス現場での活用事例はあるのでしょうか。

秋葉氏: ある大手金融機関は、マクロ経済予測や経営戦略の仮説立案にこのアルゴリズムを活用しています。AIエージェントがさまざまなシナリオをシミュレーションし、「もしこういう経済状況になったらどうなるか」という仮説を探索します。人間だけでは思いつかないような視点の仮説が出てくることもあり、専門家からも高く評価されています。

「コスト」よりも「品質」が優先されるフェーズ

――推論時スケーリングはとても強力そうですが、何度も計算させるとなると、モデルの利用料金などのコストが心配になります。

秋葉氏: 確かに、モデルのAPIをたたく回数が増えるのでコストはかかります。しかし、重要な意思決定や高度なタスクにおいて、「安かろう悪かろう」のアウトプットは役に立ちません。人間を超えるような品質のアウトプットを出すことが最優先課題だと思います。

LLMの利用コストは年々下がっていますが、コストが下がるのを待ってから開発を始めるのでは遅すぎると思います。今のうちに高度な推論システムを構築しておけば、競争優位につながります。実運用時は開発時点よりも低コストでより良いアウトプットが得られることが期待できるでしょう。

プロンプトエンジニアリングの常識が変わった

――AIに指示を出す「プロンプト」のテクニックも変わってきているのでしょうか。

秋葉氏: 大きく変わっています。以前は「ステップ・バイ・ステップで考えてください」という指示が有効だと言われていましたが、最近の高性能なモデルでは、むしろその指示がない方が性能が良くなります。

また、かつては「AIには優しく丁寧に」とか「重要なことは2回書く」といったテクニックもありましたが、今のモデルは文脈理解能力が非常に高いため、そうした小手先のテクニックの重要性は下がっています。

――では、今は何を意識すべきなのでしょうか。

秋葉氏: 「必要な情報を全て渡すこと」です。コンテキストウィンドウ(AIが一度に処理できる情報量)が拡大したため、長大なドキュメントや詳細な背景情報をそのまま読み込ませられるようになりました。「長過ぎるとAIが混乱する」という現象も完全に払拭されたわけではありませんが、どんどん改善が進んでいます。基本的には、前提条件や参考情報を惜しみなく与える方が、結果として良い回答が得られます。

AIへの業務指示は「新人のマニュアル作成」と同じ

――特定の業務知識(ドメイン知識)が必要なタスクをAIに任せるために、プロンプト以外に工夫できるポイントはありますか。

秋葉氏: 「ワークフローの定義」も効果的な方法です。これは新入社員に業務マニュアルを渡すのと似ています。「まずはこれを調べて、次にこのデータを分析して、最後にレポートにまとめる」といった手順を、コードやプロンプトで明確に定義してあげるのです。

――AIに自由にやらせるのではなく、手順を決めてしまうのですね。

秋葉氏: プログラミングのような現在のAIが得意とする分野であれば、AIに裁量を与えた方がうまくいくことが増えてきています。しかし、企業の独自ルールや複雑な商習慣が絡む業務など、AIの知識や経験が不足している分野では、人間が「この手順でやってほしい」とガードレールを敷く方が、現時点では確実です。この「どこまで任せて、どこまで型にはめるか」のバランス感覚が、AIエージェント開発の肝になります。

人間に残される仕事は「ルーブリック」を作ること

――AIエージェントが高度なタスクをこなすようになると、人間の役割はどう変わるのでしょうか。

秋葉氏: 人間に残される最も重要な仕事の一つは、「何が良いアウトプットで、何が悪いアウトプットか」を定義すること、つまり「ルーブリック」(評価基準)を作ることになるでしょう。

AIの回答を全て人間が評価するのは現実的ではないため、LLMによる自動評価(LLM-as-a-Judge)を利用するケースが増えています。ルーブリックを整備しておけば、自動評価の精度も上がります。

AIは優秀な部下のようなものですが、あくまで他者です。「何を作ってほしいか」「どうなれば合格か」というゴールを言語化して伝えない限り、期待通りの成果物は出てきません。AIが自律的に動く時代だからこそ、ゴールを設定し、最終的に品質を評価する人間の役割がより重要になります。

――1人で多数のAIエージェントを動かせるようになれば、個人の生産性は劇的に上がりそうです。

秋葉氏: その通りです。優秀なAIエージェントという“部下”を何人も従えることで、1人でできる仕事の規模は大きく拡張されます。これからは、AIという部下をいかにマネジメントし、成果を最大化できるかという、ある種の「管理職的スキル」が全ての人に求められるようになるのかもしれません。

――ありがとうございました。

取材を終えて

LLMの「長期思考」について聞いた前回に続き、今回は「優秀なAIエージェントを作る方法」を秋葉氏に聞いた。

AIの知識量や能力は既に多くの人間を上回っているはずなのに、なかなか満足のいくアウトプットを出してくれないことにやきもきしている人も多いはず。AIの能力は与えられたデータの偏りに依存しているため、ユーザーが求めていることを余すことなく伝えて、その偏りを矯正する必要がある。AIを“優秀な部下”にするための方法を学べたことが、今回の取材の大きな成果だ。

ChatGPTの登場から3年がたち、モデル自体の性能競争だけでなく、そのモデルを「どう使い倒すか」というエンジニアリングの領域にも競争が波及している。AIエージェントを「戦力」にできる企業と、単なる「チャット相手」で終わらせる企業の差は、こうした地道な“教育”と“マネジメント”の差に表れるのではないだろうか。

関連記事

生成AI、進化の鍵を握る「長期思考」 Sakana AIが挑む“人間のように試行錯誤するAI”への道筋

生成AI、進化の鍵を握る「長期思考」 Sakana AIが挑む“人間のように試行錯誤するAI”への道筋

AIの進化は目覚ましく、その活用は日々広がっている。しかし、現在のAIにはまだ苦手な分野がある。それは数週間といった「長期間の思考」を要する複雑なタスクだ。この難題にAI研究の最前線はどう挑んでいるのか。Sakana AIの秋葉拓哉氏に話を聞いた。 「コーディングはAI任せ」でエンジニアは何をする? AWSが示す、開発の新たな“主戦場”

「コーディングはAI任せ」でエンジニアは何をする? AWSが示す、開発の新たな“主戦場”

ビジネスでの生成AI活用が進む中、特にコーディングエージェントの進歩が著しい。AWSの年次イベントで語られた内容を基に、AI時代におけるエンジニアの役割の変化と、急速にあいまいになりつつあるビジネス職との境界線について考察する。 “AIエージェントの次”のトレンドは何か Gartnerが描く未来志向型インフラのハイプ・サイクル

“AIエージェントの次”のトレンドは何か Gartnerが描く未来志向型インフラのハイプ・サイクル

Gartnerは、日本の未来志向型インフラ・テクノロジーに関するハイプ・サイクルを発表した。AIエージェントや完全自動化など9項目を新たに加え、2030年を目標とした産業変革の指針を提示している。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

アイティメディアからのお知らせ

人気記事ランキング

- Claude拡張機能にCVSS10.0の脆弱性 現在も未修正のため注意

- ホワイトハッカーが明かす「ランサムウェア対策が破られる理由」と本当に効く防御

- 7-Zipの偽Webサイトに注意 PCをプロキシノード化するマルウェア拡散

- 2026年はAGIが“一部実現” AIの革新を乗りこなすための6つの予測

- 一気読み推奨 セキュリティの専門家が推す信頼の公開資料2選

- 「SaaSの死」騒動の裏側 早めに知るべき“AIに淘汰されないSaaS”の見極め方

- 米2強が狙う“AI社員”の普及 Anthropicは「業務代行」、OpenAIは「運用プラットフォーム」

- Fortinet、管理サーバ製品の重大欠陥を公表 直ちにアップデートを

- NTTグループは「AIがSI事業にもたらす影響」をどう見ている? 決算会見から探る

- LINE誘導型「CEO詐欺」が国内で急増中 6000組織以上に攻撃