“実写にしか見えない”3DCG女子高生「Saya」、制作者の愛 「貯金を切り崩しながら制作を続けてきた」:CEDEC 2018(2/3 ページ)

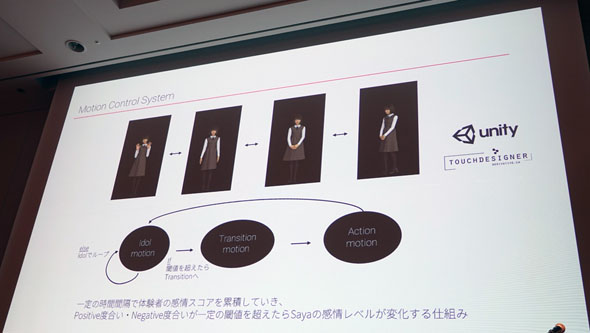

ディスプレイの目の前に来場者がいないときは、Sayaは横に揺れる、手を振るといった基本のアクションを繰り返す。来場者が現れると、顔をカメラが捉え、表情から感情を推定。Sayaのしぐさが変化していく。このとき、基本のアクションから切り替わる間に流す約1秒間のモーションも用意。リアルタイムに反応しているように見せることを追求した。

感情を推定するAIには「喜んでいる顔」「悲しんでいる顔」などを学習させ、来場者の表情を「ポジティブ」「ニュートラル」「ネガティブ」に分類できる仕組みにした。

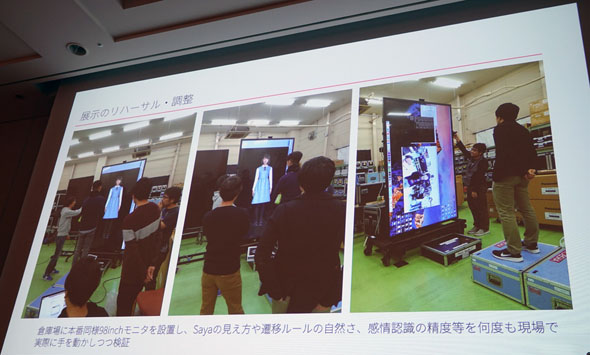

Sayaの目の前に複数人が立っていると、誰の顔を認識すればいいか判断できないという課題もあった。そこで、ディスプレイの前に、圧力センサーを仕込んだマットを設置。来場者が乗るとセンサーが検知し、その際、カメラに顔が最も大きく映っている人を認識対象として固定するようにした。

こうしたAI技術、ハードウェアの仕組みなどCG以外の部分は、フリーランスのエンジニア佐野和哉さん、博報堂研究開発局の田原將志さんが開発に協力した。

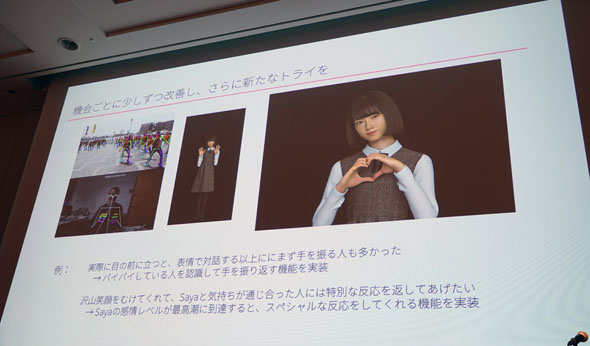

進化したSayaは、来場者の目を引いた。SXSWの会場では、人だかりができたという。6月にはロボットコンテスト「NHK学生ロボコン」の会場でも展示された。

TELYUKAの友香さんは「米国では、来場者がSayaと積極的にコミュニケーションしてくれたが、ロボコンは特殊だった。女の子に慣れていない男子大学生もいたようで、Sayaを遠巻きに眺めている人が多かった」と話す。ロボコンの会場では、幼い子どもたちがSayaに話し掛け、画面上のSayaの手に触れようとする一幕もあったという。「機材が高価なのでヒヤヒヤしながら見ていたが、(子どもがそうした反応を示したことは)勉強になった」(友香さん)

Sayaの制作に欠かせない「3つの愛」

TELYUKAの2人には、Sayaの制作で大切にしている「3つの愛」があるという。

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR