Google翻訳より高性能? 「日本の自動翻訳がすごい理由」をNICT隅田氏が解説:これからのAIの話をしよう(自動翻訳編)(3/4 ページ)

35というスコアは「人間が理解可能な適度な品質の翻訳」と解釈されています。スコアが60以上だと「人間が翻訳した場合よりも高品質であることが多いレベル」といえるそうです。「まだあと3年ぐらいは大きく伸びるのではないか」と隅田氏。まだ私たちは自動翻訳の進化を見終えていないようです。

日本でのディープラーニングはここ数年で一気に火がついたようにみえますが、隅田氏や一部の研究者はそれ以前からニューラル機械翻訳の研究に取り組んでいたそうです。しかし、マシンスペックなどの問題で十分な研究ができない状態が続いていました。

隅田氏は「まだ一般的にGPUが搭載されたマシンがありませんでした。GPU自体が高価で、熱も出すし、全て自社で翻訳したいと思っている企業にとってGPUがマストになるとちょっとな……ということで開発を躊躇(ちゅうちょ)していました」と当時を振り返ります。

ニューラル機械翻訳の仕組みは次の通りです。

まず日本語の原文と翻訳文を、テキスト処理を行うニューラルネットワークである「Word2Vec」を用いてベクトルに直し、それを入力データとしてニューラルネットに学習させます。そうしてできたネットワークを使い英語を入力すると、日本語が出力される翻訳機の完成です。

試しに海外の論文をGoogle翻訳にかけると、かなりの頻度で不自然な日本語に訳されてしまうのですが、NICTの翻訳技術が搭載されている「みらい翻訳」「みんなの自動翻訳@TexTra」を使ってみると、かなり自然な日本語が出力されます。

なぜ私たち日本人が「自然な日本語」と感じるような翻訳を実現できているのでしょうか。隅田氏は「学習データの質」に言及します。「学習データの質が高く、ニューラルネットワークが“自然な日本語”を学習しているからでしょう。逆に質の高いデータが少ないと、こんな簡単な文が翻訳できないのかと思われてしまいます」(隅田氏)

データは「量と質の両方が大事」

翻訳の精度は、対訳データとAIのアルゴリズムで決まります。アルゴリズムについては、数カ月に1回開催される自然言語処理技術の国際会議で毎回新しい発表があるそうです。

対訳データは、量と質の両方を充実させる必要があります。隅田氏は「データ量は多いほどいいわけですが、正確に言うとある程度のデータ量がないとそもそも使いものにならないのです」と話します。

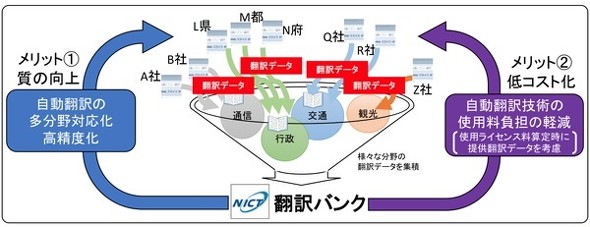

大手IT企業がWebサイトをクローリングしてひたすらテキストデータを収集しているのとは対照的に、NICTでは質の高いデータを大量に集めるために「翻訳バンク」というサービスを始めました。日本国内のさまざまな業界の翻訳データを蓄積し、特定の領域に特化した翻訳エンジンを生成するというものです。

例えば製造業の場合、クルマを輸出するときに輸出先の国のレギュレーションを理解しておく必要があります。各国のレギュレーションは頻繁に更新されるため、和訳コストは増加していきます。隅田氏は「レギュレーションの翻訳はどの企業にとっても同じようにニーズがあるものですが、競合企業同士が協力するのは難しいのが現状です」と話します。

「パブリックセクターであるNICTが総務省と共に各業界へ声をかければ、企業や自治体から質の高い対訳データを大量に収集できます。日本企業同士で競い合うのではなく、協力しあえるところは協力していきましょうと」(隅田氏)

NICT、企業、日本社会全体が「三方良し」の座組が完成してから、特許とIT分野の翻訳エンジンはほぼ完成し、現在は製薬業界の翻訳エンジン開発に取り組まれているそうです。NICTは今後、法務、自動車、金融業界での翻訳も視野に入れていきます。

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR