Google、複雑な会話型クエリでも意図をくんで答えるBERT採用検索を英語で開始

米Googleは10月25日(現地時間)、Google検索で自然言語処理「BERT」を採用し、検索結果に「過去5年間で最も大きな躍進」をもたらしたと発表した。まずは米国での英語による検索に適用し、提供地域や言語を拡大していく計画だ。

BERT(Bidirectional Encoder Representations from Transformers)は、Googleが昨年11月に発表した自然言語処理(NLP)のための言語処理モデル。おおまかに言うと、いくつかのキーワードを抜いた文を学習データセットにして機械語アルゴリズムを訓練し、アルゴリズムによる文脈の理解力を上げるというもの。

例えば長い会話型クエリや、「for」や「to」などの助詞に重要な意味があるクエリの場合、従来の検索では意図した結果を得られない場合が多かったが、BERT採用検索は文脈を理解した結果を表示するという。

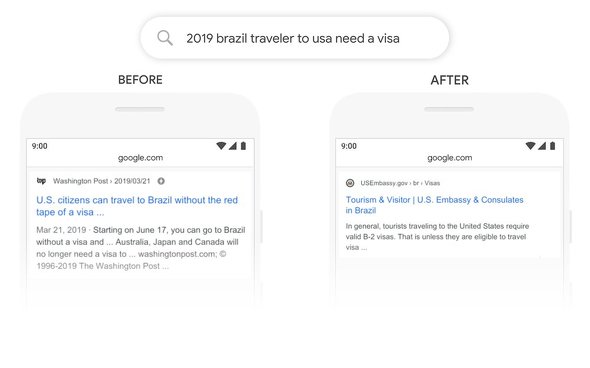

Googleは具体的な成果の例を幾つか紹介している。例えば、「2019 brazil traveler to usa need a visa(2019年にブラジルから米国への旅行者はビザが必要か?)」というクエリの場合、従来は助詞の「to」の重要性を理解せず、米国からブラジルへの旅行者に関する結果をトップに表示していたが、BERT版ではブラジルから米国への入国についての情報がトップに表示される。

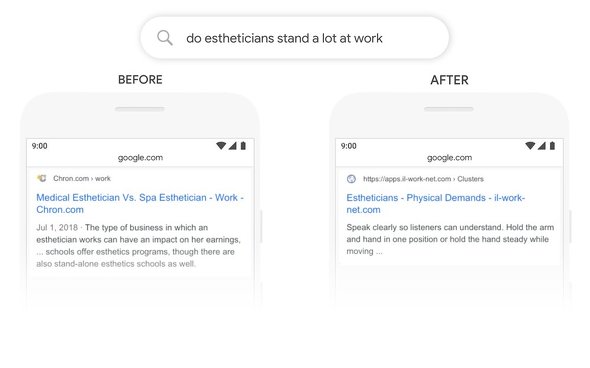

「do estheticians stand a lot at work(エステティシャンは仕事中長く立っているか)」というクエリでは、従来は「stand」を「stand-alone」とマッチングさせてしまい、クエリで知りたい物理的な立ち仕事かどうかという疑問とは直接関係ない結果を表示していたが、BERTであればエステティシャンの身体的負荷についての説明がトップに表示される。

BERTで構築するモデルの一部は非常に複雑で従来のハードウェアはその負荷に耐えられないため、Googleは最新の「Cloud TPU」を初めて採用したことも発表した。

BERTの特徴の1つは、1つの言語の学習成果を他の言語に適用できることだ。Webで最も使われている英語での学習モデルを他の言語に適用することで、他の言語での検索結果も改善していく。強調スニペット(説明のスニペットが上部に表示される、通常のリスティングとは形式が逆の特別なボックス)については、既に、“2ダースの国々”(日本が含まれるかどうかは不明)でBERTを採用しており、特に韓国語、ヒンズー語、ポルトガル語の検索で大幅な改善がみられるとしている。

【訂正:2019年10月28日午前5時40分 最後の段落に誤りがあったため、修正しました。】

関連記事

Googleフォト、画像内テキストによる検索が可能に(まずは英語)

Googleフォト、画像内テキストによる検索が可能に(まずは英語)

Googleフォトで、写真に写っている看板などのテキストを検索できるようになった。まだアルファベットだけだが、8月から使えるようになった新機能だ。 動物名をGoogle検索するとARで表示し、鳴き声やしぐさも分かる機能、ローリングアウト

動物名をGoogle検索するとARで表示し、鳴き声やしぐさも分かる機能、ローリングアウト

Googleアプリで「panda」や「tigar」を検索すると結果をARで表示する機能がローリングアウト中だ。ARCore対応端末で設定言語を英語にすると日本でも使える。 Google I/O 2019まとめ 「AI for Everyone」、Pixel 3aも発表

Google I/O 2019まとめ 「AI for Everyone」、Pixel 3aも発表

Googleの年次開発者会議「Google I/O 2019」で発表されたことを時系列にまとめた。今年のテーマは「「Building a more helpful Google for everyone」。AI採用のアクセシビリティ機能や「Googleアシスタント」の新機能、手ごろな価格の「Pixel 3a」などが発表された。 言い間違いも直してくれるGoogleの「音声文字変換」、かなり使える

言い間違いも直してくれるGoogleの「音声文字変換」、かなり使える

Googleが早期アクセス版として公開した音声をリアルタイムで字幕にして表示する「音声文字変換」アプリを使ってみました。多少滑舌が悪くても意味が通るよう解釈してくれ、書籍タイトルなどもばっちり正しく表示してくれます。 Facebook、Messenger botにNLP(自然言語処理)採用

Facebook、Messenger botにNLP(自然言語処理)採用

FacebookがFacebook Messenger上で企業向けに提供しているbotのプラットフォーム「Messenger Platform」をアップデートし、Wit.aiのNLP(自然言語処理)技術を採用した。従来よりbotの受け答えが自然になりそうだ。 Google I/O 2017基調講演まとめ 「AI First」をすべてのサービスに

Google I/O 2017基調講演まとめ 「AI First」をすべてのサービスに

Googleの年次開発者会議「Google I/O」の基調講演で発表されたことを時系列にまとめた。詳細はリンク先をどうぞ。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR