口パクで音声入力、喉に小型センサーで 東大とソニーCSLが技術開発:Innovative Tech

Innovative Tech:

このコーナーでは、テクノロジーの最新研究を紹介するWebメディア「Seamless」を主宰する山下裕毅氏が執筆。新規性の高い科学論文を山下氏がピックアップし、解説する。

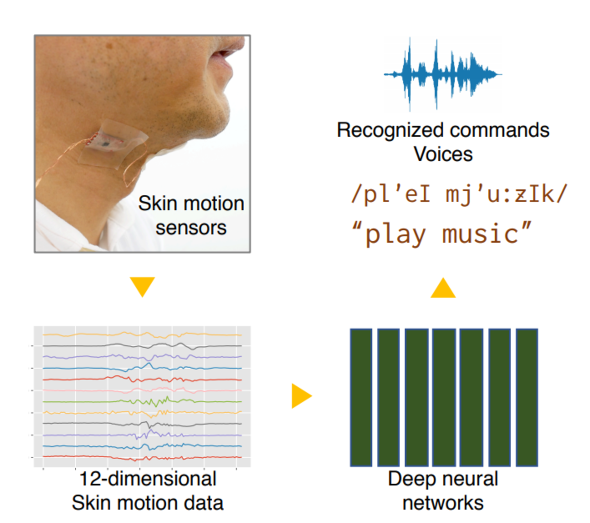

東京大学大学院情報学環とソニーコンピュータサイエンス研究所(CSL)の研究チームが開発した「Derma」は、喉周辺の皮膚にセンサーを張り付け、口パク(無声発話)を音声入力に変換する深層学習を用いたサイレントスピーチインタラクション(Silent Speech Interaction、SSI) だ。

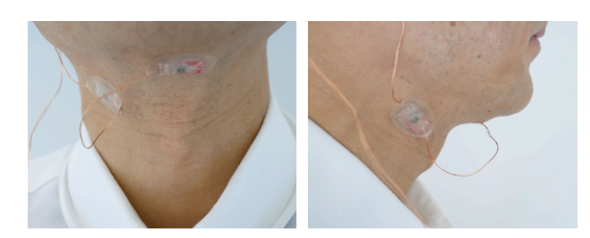

話者の唇や顎(あご)周辺を指で触れ、発話を読み取ろうとする、視聴覚障害者のためのTadoma(触診リップリーディング)法から発想を得ている。Tadoma法では主に唇周辺の皮膚を触って発話を認識しているが、今回の研究ではそれを機械学習により自動化した。さらにウェアラブルでの利用を想定し、より目立ちにくい顎下(がっか)の皮膚からも発話が推定できることを示している。

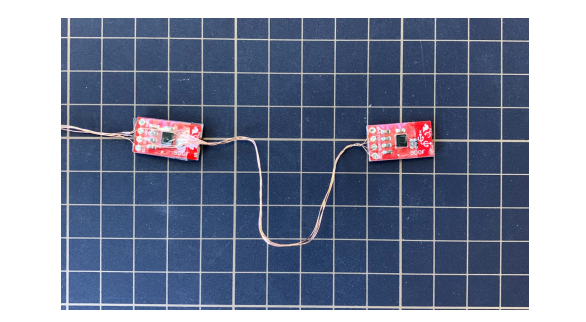

今回の手法は、顎下皮膚2カ所にMEMS(Micro ElectroMechanical Systems)加速度計と角速度センサーを装着し、発話により下顎から喉までの皮膚が変動する顎運動と舌筋の運動を計測することで無声発話を認識する。

具体的には、センサーから12次元の皮膚運動情報を取得し、深層学習の解析で35種類の発声コマンド・フレーズを識別する。実験では、94%以上の認識率で識別できた。

この結果を用いて、無声発話から音声合成を生成するために、音素記号系列を作り出すコネクショニスト時間分類(Connectionist Temporal Classification、CTC)を用いたニューラルネットワークで訓練する。訓練したモデルは、無声発話時の皮膚運動情報から音声合成への変換を可能にする。

変換後の音声合成は、近くにある音声アシスタントなどの音声認識機能を備えたデジタル機器に入力できるほか、声帯損傷などの理由により有声発話が困難な利用者のコミュニケーション支援にも利用可能だ。

今回の手法の特徴は、既存のサイレントスピーチインタラクション研究に比べ、装着時に目立ちにくく、小型で軽量、低消費電力であり、照明条件などの周囲の環境要因の影響を受けにくいことだ。そのため、食事や通常の会話などを阻害しにくく、実用向けといえるだろう。将来はウェアラブルエレクトロニクスや身体埋め込み型のコンピューティングとの融合を目指している。

関連記事

AirPodsでヒソヒソ音声入力 口を手で押さえるジェスチャーで 清華大学など発表

AirPodsでヒソヒソ音声入力 口を手で押さえるジェスチャーで 清華大学など発表

直感的なジェスチャーでひそひそ音声入力を起動できる。 電磁コイル式リングで空中指入力 ワシントン大学「AuraRing」開発

電磁コイル式リングで空中指入力 ワシントン大学「AuraRing」開発

AuraRingは指輪型ウェアラブルとして、かなり実用的な操作が可能だ。 その空間だけボケさせる隠消現実メガネ 阪大「IlluminatedFocus」開発

その空間だけボケさせる隠消現実メガネ 阪大「IlluminatedFocus」開発

Augmented Realityと対になるDiminished Reality。ボケを使ってそうした隠消現実を実現するデバイスが登場した。 人差し指にQWERTYキーボードをかぶせ、片手で文字入力 米ダートマス大学など「TipText」開発

人差し指にQWERTYキーボードをかぶせ、片手で文字入力 米ダートマス大学など「TipText」開発

指サックのようなQWERTYキーボードを人差し指にかぶせ、親指でタッチして文字入力する。

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR