OpenAI、自然な言葉の説明からイラストを描くAI「DALL・E」発表

米AI研究企業OpenAIは1月5日(現地時間)、人間の自然な言葉による説明を入力するとそれを画像として描くAI「DALL・E」を発表した。例えば下の画像は「チュチュを着て犬を散歩させている大根の赤ちゃんのイラスト(an illustration of a baby daikon radish in a tutu walking a dog)」という説明をDALL・Eが画像化したものだ。

OpenAIの説明によると、DALL・Eは「テキストと画像のペアのデータセットを使って、テキストの説明から画像を生成するようトレーニングされた120億パラメータ版のGPT-3」という。DALL・Eという名称は、アーティストのサルバドール・ダリとPixarの映画「ウォーリー」の主人公のロボットの名前を合成したものとのこと。

GPT-3は、ネット上のテキストの次の単語を予測するためだけに訓練されたTransformerベースの自己回帰言語モデル。1750億個のパラメータで動作し、いくつかのキーワードを与えると人間が書いたような文章を生成する。DALL・Eはテキストの代わりに画像を生成する。

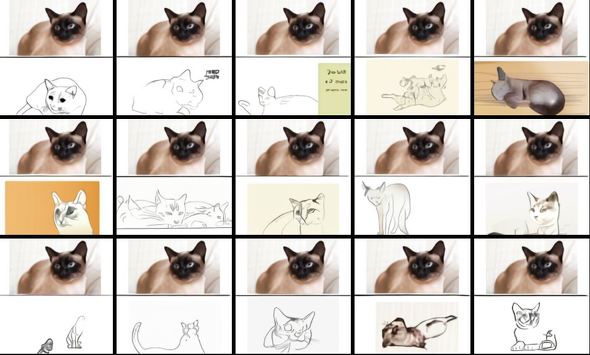

架空の画像の生成の他、「写真の猫のスケッチ」という入力で写真の手書きスケッチのような画像も生成する。

同社はまた、ネット上から集めた画像とそのキャプションのペア4億点でトレーニングしたマルチモーダルモデル「CLIP」も発表した。こちらはGPT-2、GPT-3の言語モデルに似た「ゼロショット学習」を採用している。ゼロショット学習は、学習と推論の2つのステップを経ることで“見たことのないもの”を予測できるようにする技術。詳細はこちら。

OpenAIは、DALL・Eのように生成モデルを含む技術は重大な社会的影響を与える可能性があることを認識しているとしている。将来的には、こうしたモデルが特定の職業に与える経済的影響やモデル出力の偏りの問題、倫理的課題などを分析していくという。

関連記事

Microsoft、汎用言語モデル「GPT-3」のライセンス取得

Microsoft、汎用言語モデル「GPT-3」のライセンス取得

イーロン・マスク氏などが率いる非営利AI企業OpenAIの高性能言語モデル「GPT-3」の独占ライセンスをMicrosoftが取得した。Microsoftは自社製品やサービスにGPT-3を採用していく。OpenAIのβ版API経由でのGPT-3へのアクセスは引き続き可能だ。 画像を半分入れたら残りを自動生成 OpenAI、文章自動生成モデルの画像版「Image GPT」開発

画像を半分入れたら残りを自動生成 OpenAI、文章自動生成モデルの画像版「Image GPT」開発

半分残っていれば後の半分はAIで推定できる。 OpenAI、まことしやかなフェイクニュースも簡単生成の言語モデル「GPT-2」の完全版を公開

OpenAI、まことしやかなフェイクニュースも簡単生成の言語モデル「GPT-2」の完全版を公開

OpenAIが、テキストの一部を入力すると自然言語の文章を生成する言語モデル「GPT-2」の完全版を公開した。2月の段階では「悪用される危険がある」として限定版を公開したが、完全版を公開することで高性能な検出モデル開発を促すのが目的。 AI記者、AI小説家、そしてAI作曲家も――創作する人工知能を支える技術

AI記者、AI小説家、そしてAI作曲家も――創作する人工知能を支える技術

ビジネスに役立つAIの基礎知識について分かりやすく解説する連載。今回のテーマは「コンテンツ生成」について。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR