キーワードから小説や画像を自動生成 自然言語処理の革命児「GPT-3」の衝撃(2/2 ページ)

GPT-3の可能性

GPT-3は、次に来る単語の予測を学習する。予測した単語を組み合わせて文章を出力する。学習は、大量の文章(Wikipedia英語版など)を用い、正解は与えられず、文脈にある単語との関係性について分析してパターンを学習していく。

特徴は、これまでの自然言語処理モデルで使用されてきたタスク固有のデータセットと微調整を行わないことだが、複数の自然言語処理ベンチマークで優れた結果を示した。

タスク固有のデータセットや微調整を行わなくても良い結果が得られることは、OpenAIが2020年1月に発表した「Scaling Laws for Neural Language Models」という論文で既に結論付けていた。Transformerベースのモデルの性能は、「モデルパラメーターの数」「データセットサイズ」「学習に使用される計算量」の3つの変数に応じて累乗則でスケーリングするという内容だ。性能を高めたいのであれば、タスク固有のデータセットや微調整を探求するのではなく、これら3つの変数を増やすことが効果的だという。

この法則を実証するため、GPT-3では、パラメーター数1億2500万から1750億個のモデルサイズを学習し性能を比べた。最大の1750億個は、当時多いとされた米Microsoft開発の言語モデル「Turing-NLG」の170億個をはるかに超える。結果は、パラメーターの増加に伴い性能が向上することを示した。他方で、1750億個以上のモデルは実験されていないため、どれくらいまで適応できるか分かっていない。まだ上限が見えていないともいえる。

GPT-3は汎用性が高いモデルだ。OpenAIはGPT-3発表から5カ月後の2020年10月、「Scaling Laws for Autoregressive Generative Modeling」という論文を発表した。画像、動画、マルチモーダル(画像とテキスト間)、数学の4つの領域において、この法則が適応できるか検証した内容だ。画像や動画には、1億枚のラベル付き画像データセット「Yahoo Flickr Creative Commons 100M」を使用。結果は、全てのドメインにおいて適用できることを示し、汎用性の高さを理論的に実証した。

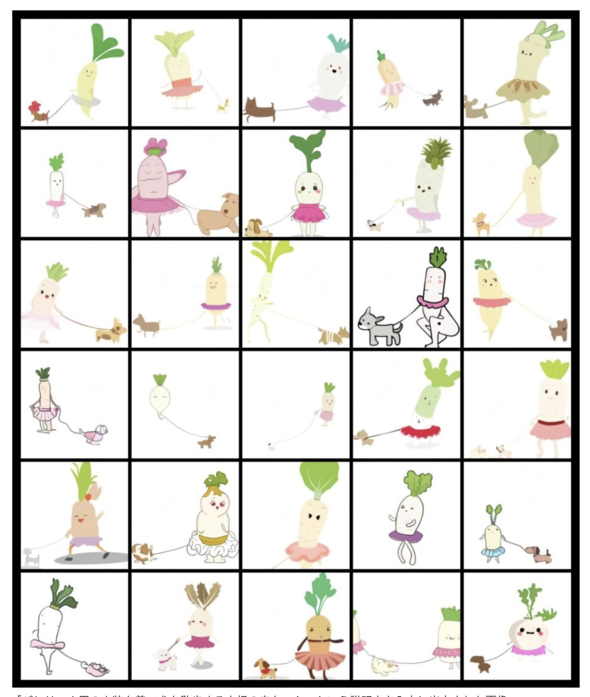

この流れからOpenAIは2021年1月、言語から画像を生成するGPT-3(120億個のパラメータ数)を用いたモデル「DALL・E」を発表した。簡単な説明文を入力に、その文章の内容に適した画像を生成するモデルだ。例えば、説明文の「バレリーナ用の衣装を着て犬を散歩する大根の赤ちゃん」に対して、以下の画像を生成する。

このように、言語から画像を生成するタスクにおいても高い精度を世に知らしめた。

ここまでの変遷から分かるように、OpenAIはここ数年、GPTの開発を積極的に行なっている。GPT-3が掲載される論文の著者数を見ても、31人(OpenAIの従業員数は2020年時点で約120人)と多くの人材リソースを投入し本気度が伺える。このことからも今後数年、OpenAIが世間を驚かせる論文を発表するであろうと予想できる。

関連記事

OpenAI、自然な言葉の説明からイラストを描くAI「DALL・E」発表

OpenAI、自然な言葉の説明からイラストを描くAI「DALL・E」発表

AI研究企業のOpenAIが、人間の言葉による説明を入力するとそれを画像として生成するAI「DALL・E」を発表した。例えば「チュチュを着て犬を散歩させる大根の赤ちゃん」というシュールな設定でも絵にする。 Microsoft、汎用言語モデル「GPT-3」のライセンス取得

Microsoft、汎用言語モデル「GPT-3」のライセンス取得

イーロン・マスク氏などが率いる非営利AI企業OpenAIの高性能言語モデル「GPT-3」の独占ライセンスをMicrosoftが取得した。Microsoftは自社製品やサービスにGPT-3を採用していく。OpenAIのβ版API経由でのGPT-3へのアクセスは引き続き可能だ。 画像を半分入れたら残りを自動生成 OpenAI、文章自動生成モデルの画像版「Image GPT」開発

画像を半分入れたら残りを自動生成 OpenAI、文章自動生成モデルの画像版「Image GPT」開発

半分残っていれば後の半分はAIで推定できる。 OpenAI、まことしやかなフェイクニュースも簡単生成の言語モデル「GPT-2」の完全版を公開

OpenAI、まことしやかなフェイクニュースも簡単生成の言語モデル「GPT-2」の完全版を公開

OpenAIが、テキストの一部を入力すると自然言語の文章を生成する言語モデル「GPT-2」の完全版を公開した。2月の段階では「悪用される危険がある」として限定版を公開したが、完全版を公開することで高性能な検出モデル開発を促すのが目的。

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR