ITmedia NEWS >

STUDIO >

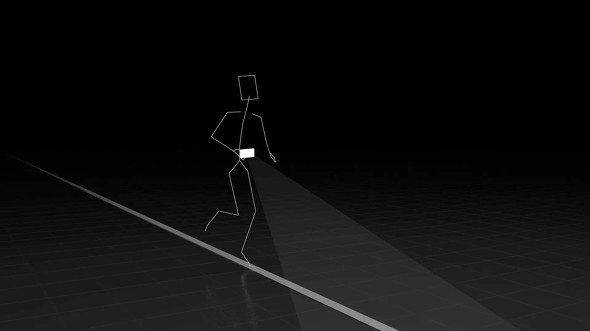

「盲目でも一人で真っすぐ走れる」 スマホカメラ+AIでランニング支援、Googleが日本で研究スタート

» 2021年08月17日 14時40分 公開

[ITmedia]

体に装着したスマートフォンで地面に引いた線を撮影し、線からそれた場合に音で知らせることで、視覚障害者でも一人で真っすぐ走れるようにする──米Googleの日本法人Google Japanは8月17日、こんな研究を日本でも始めると発表した。テストに協力したい企業や団体、視覚障害者を募集している。

プロジェクト名は「Project Guideline」。Androidスマートフォンをベルトでランナーの腹部に固定し、地面に引かれた線をスマホのカメラで撮影。その線がランナーより左にあるか、右にあるかなどを、Googleの機械学習用オープンソースライブラリ「TensorFlow」を活用した画像認識AIでリアルタイムに分析する。ランナーが線からそれた場合は、身に付けているヘッドフォンを通して音で知らせる。

もともとは米国で2020年に発足したプロジェクトで、21年5月には視覚障害のあるランナー、御園政光さんと協力してテストを実施。開発した技術を使って実際にランニングしてもらったところ、Project Guidelineの補助だけで10kmを完走することに成功したという。

ただし、ランニングコースには影や落ち葉があることが多く、地面の色も一定でないため、AIがさまざまな条件下で補助線を正確に読み取れるようにするには、追加の学習用データが不可欠という。日本でのテストではこういったデータや視覚障害者からのフィードバックを集め、安全性の向上に役立てるとしている。

関連記事

AI搭載の“走るスーツケース”誕生へ 視覚障害者の移動をサポート IBMら5社が共同開発

AI搭載の“走るスーツケース”誕生へ 視覚障害者の移動をサポート IBMら5社が共同開発

視覚障害者が利用しやすい「AIスーツケース」の開発に向け、IBMら5社が社団法人を設立した。6月にプロトタイプを使った実証実験を行う。 コード付き点字ブロック、カメラで読み取り音声案内 金沢工業大がAI活用の実証実験

コード付き点字ブロック、カメラで読み取り音声案内 金沢工業大がAI活用の実証実験

金沢工業大学が、AI技術を使った点字ブロックの音声案内システムの実証実験を金沢駅で始める。 点字ブロックのQRコード、読み取ると声で道案内 視覚障害者向け「shikAI」メトロで実験

点字ブロックのQRコード、読み取ると声で道案内 視覚障害者向け「shikAI」メトロで実験

駅構内の点字ブロックに表示したQRコードをスマホカメラで読み取ると、目的地まで音声で道案内してくれる――視覚障害者向けナビゲーションシステム「shikAI」の実証実験を、東京メトロが8月6日から辰巳駅構内で行う。 Facebook、AI採用の画像の音声キャプションを視覚障害者向けに提供開始

Facebook、AI採用の画像の音声キャプションを視覚障害者向けに提供開始

人工知能研究に注力するFacebookが、自社開発の物体認識技術を採用した投稿写真の内容説明読み上げ機能「自動代替テキスト」を発表した。目の不自由なユーザーはサービスに投稿された写真をスワイプすることでその説明を再生できる。 ソフトバンク、AIで手話をテキスト化するツール 健常者と聴覚障害者のコミュニケーションを円滑化

ソフトバンク、AIで手話をテキスト化するツール 健常者と聴覚障害者のコミュニケーションを円滑化

ソフトバンクと電気通信大学が、AIを活用して手話をテキスト化するツール「SureTalk」を開発。ビデオ通話と組み合わせることで、健常者と聴覚障害者の円滑なコミュニケーションに役立つという。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PRアイティメディアからのお知らせ

SpecialPR

あなたにおすすめの記事PR