文章から“動画”を自動作成するAI、中国の研究チームが開発:Innovative Tech

Innovative Tech:

このコーナーでは、テクノロジーの最新研究を紹介するWebメディア「Seamless」を主宰する山下裕毅氏が執筆。新規性の高い科学論文を山下氏がピックアップし、解説する。

中国の清華大学の研究チームが開発した「CogVideo: Large-scale Pretraining for Text-to-Video Generation via Transformers」は、簡単なテキストを入力に、その文章を基にした簡単な動画を自動作成する機械学習モデルだ。

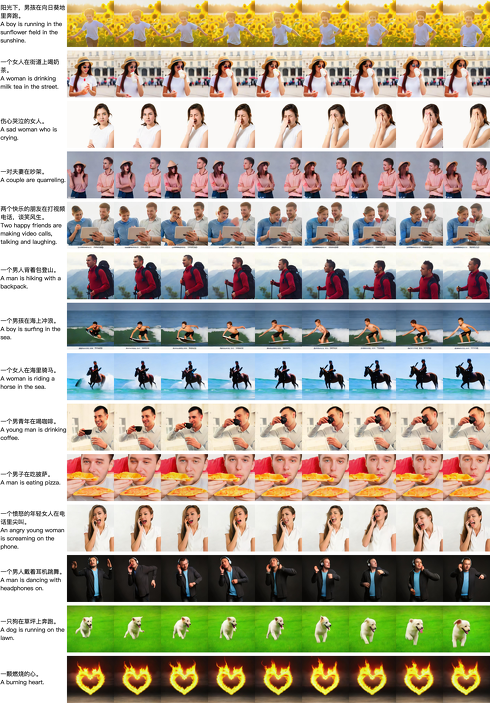

以下の画像のように、例えば「A man is sking.」と入力すると、男性が雪の上をスキーで滑る映像を出力し「A lion is drinking water.」だとライオンが手にコップを持ち水を飲む映像を出力する。ここでの映像サンプルは、4秒間の32フレームで解像度480×480で出力される。

昨今、米OpenAIのDALL-Eや米GoogleのImagen、中国の清華大学によるCogView2などのように、テキストから画像に変換するモデルの精度が高まっている。次のステップとして、テキストから動画に変換するモデルを開発するのは自然なことだろう。

だが、学習用としてキャプション付きの画像ペアを収集することはデータセットも充実しており容易だが、キャプション付きビデオデータを大量に集めるのは容易ではない。画像は止まっているためテキスト情報とペアにしやすく、ビデオは時間的に連続しているためテキストと分割クリップのペアを正確に組み合わせるのが非常に難しいからだ。

例えば、「飲む」動画が、「飲む」という同じテキストで「グラスを持つ」「持ち上げる」「飲む」「置く」という4つの個別クリップに分割されると、モデルは飲むという正確な意味を理解できず学習するのに混乱する。

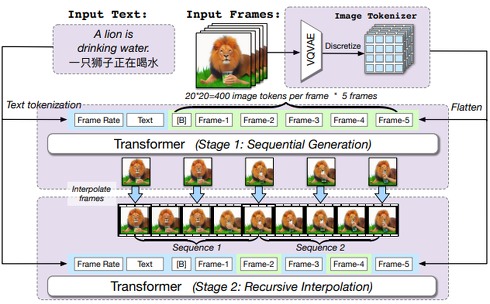

この研究では、94億個のパラメータを持ち、540万組のテキストとビデオに対して学習された、テキストからビデオを生成する事前学習済みtransformer「CogVideo」を提案する。CogVideoは、テキストから画像を生成するモデル「CogView2」に基づいて構築されており、CogView2の事前学習で得られた知識を継承している。

この手法は、テキストと映像中の時間的な対応関係を確実にするために、マルチフレームレートによる階層的な学習を導入している。これによってテキストとクリップの意味をより良く整合でき、特に複雑な意味を持つ動きに対して生成精度を大幅に向上させることに成功した。

Source and Image Credits: Hong, W., Ding, M., Zheng, W., Liu, X., & Tang, J. (2022). CogVideo: Large-scale Pretraining for Text-to-Video Generation via Transformers. ArXiv, abs/2205.15868.

関連記事

画像生成AIが独自の“AI語”を生み出した? 「DALL-E 2」を巡って、米テキサス大学が論文発表

画像生成AIが独自の“AI語”を生み出した? 「DALL-E 2」を巡って、米テキサス大学が論文発表

AIが人間の言葉ではない独自の言語を生成した──米テキサス大学の研究チームはそのような研究結果を示す論文を発表した。画像生成AIが生み出す文字列は意味不明なものであると思われていたが、それらの言葉は鳥や野菜などの意味を持つ“AI語”であったという。 最新AIの描く絵が「ヤバすぎ」「個展開ける」と話題 文章から画像を生成する「DALL・E 2」、米OpenAIが発表

最新AIの描く絵が「ヤバすぎ」「個展開ける」と話題 文章から画像を生成する「DALL・E 2」、米OpenAIが発表

米AI研究企業OpenAIは、文章から画像を生成するAI「DALL・E 2」を発表した。生成した画像を掲載するデモサイトも公開しており、その絵のクオリティーの高さにTwitter上では「最新のAIやばすぎる」など、驚きの声が出ている。 Google、文章から画像を生成するAI「Imagen」 「DALL-E 2より好まれる」

Google、文章から画像を生成するAI「Imagen」 「DALL-E 2より好まれる」

Google Researchは、文章から画像を生成する拡散モデル「Imagen」を発表した。独自ベンチマークではOpneAIの「DALL-E 2」よりも人間に好まれる結果が出たとしている。 作家とAIが小説を共作できるツール 主人公の変化する運勢を“手書きグラフ”で操作、AIが物語文を作成

作家とAIが小説を共作できるツール 主人公の変化する運勢を“手書きグラフ”で操作、AIが物語文を作成

米ミシガン大学、韓国のKAIST、韓国のNaver AI LABによる研究チームは、人間(作家)とAI(GPTベースの言語モデル)が小説の物語を共同制作できるツールを開発した。 「マジック:ザ・ギャザリング」風のカードを自動生成できるAI 好きな言葉をカード名に入れるだけ

「マジック:ザ・ギャザリング」風のカードを自動生成できるAI 好きな言葉をカード名に入れるだけ

自然言語処理モデル「Cohere」などを開発する、カナダのCohere社はトレーディングカードゲーム「マジック:ザ・ギャザリング」(MTG)風のカードを自動生成できるAI「Urzas.ai」を作成した。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR