愛犬の合成画像を生成できるAI 文章で指示するだけでコスプレ 米Googleが開発:Innovative Tech

Innovative Tech:

このコーナーでは、テクノロジーの最新研究を紹介するWebメディア「Seamless」を主宰する山下裕毅氏が執筆。新規性の高い科学論文を山下氏がピックアップし、解説する。

米Google Researchと米ボストン大学の研究チームが開発した「DreamBooth: Fine Tuning Text-to-Image Diffusion Models for Subject-Driven Generation」は、数枚の被写体画像とテキスト入力を使って、与えられた被写体が溶け込んだ新たな合成画像を作成する被写体駆動型Text-to-Imageモデルだ。

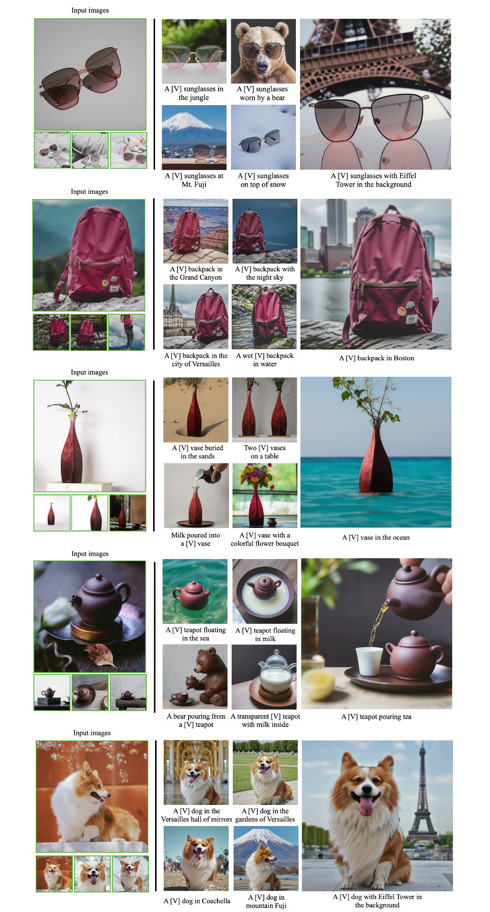

被写体の特徴を多く残しつつ、異なるテキスト入力に従ってさまざまな状況やシーンでの被写体が含まれる画像を生成する。

自然言語で書かれたテキスト入力に基づいて高品質かつ多様な画像を生成する大規模なText-to-Imageモデルが流行している。一方で、テキストを一部変えるだけで全然違う画像になってしまうなどの課題も出てきている。一般的に、詳細な編集や思うような画像が作れないのが現状だろう。そのため、これらの課題を解決する提案が報告されている。

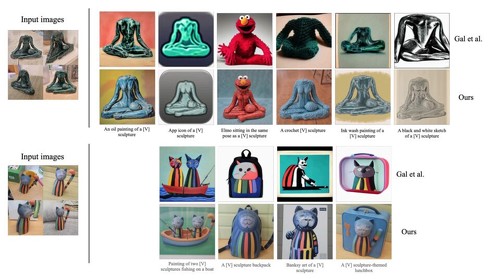

今回の研究もその中の1つで、何か1つの対象物(ユーザー特定の被写体)をベースにした合成画像を生成するText-to-Imageモデルとなる。先日記事にした、ある概念を単語に圧縮して概念ベースで新たな画像を合成するText-to-Imageモデルと違い、今回はもう少し被写体ベースとなり、対象をより固定(高い忠実度の保持)して出力する。

下記の画像内にあるバンクシーが描いた猫の絵が分かりやすい。概念ベースだと猫の絵だが元画像の猫の形状や色などは変わって表現されているのに対し、この手法は被写体の形状や模様、色などほとんどが保持されているのが分かる。

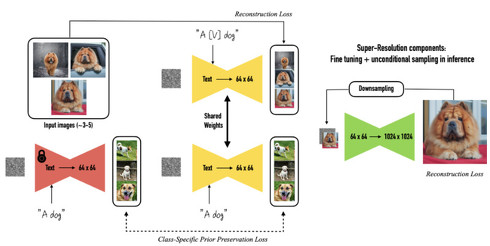

今回のアプローチは、ユーザーが生成したい特定の被写体と新しい単語を結び付けるように既存のText-to-Imageモデルをパーソナライズされたモデルに拡張する。拡張するために、被写体の画像3〜5枚を用いて2つのステップで拡散モデルを微調整する。

まず入力画像と、被写体が属するクラス名(例えば、「A [V] dog」)と一意の識別子を含むテキストプロンプトとで低解像度Text-to-Imageモデルを微調整する。次に、入力画像から低解像度版と高解像度版のペアを用いて超解像成分を微調整する。これにより、被写体のディテールに対するモデルの高い忠実度を維持することができる。

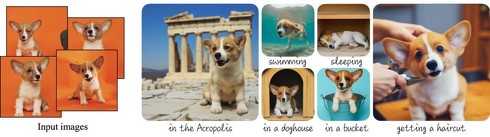

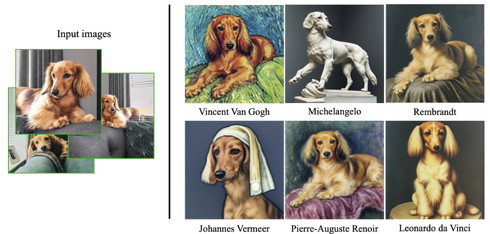

微調整したモデルは、例えば特定の犬にさまざまなコスプレをさせることができる。下の画像を見ても、違和感のない合成画像が生成されているのが確認できる。

特定の犬をベースにゴッホ風やミケランジェロ風などのスタイルを加えて、犬の原型は変えずに指定した画風に変換することもできる。

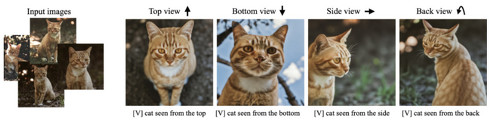

被写体の猫の視点を指定した画像(上面、下面、側面、背面)も合成できる。生成した画像は、ポーズが変わると背景もリアルに変化する。

Source and Image Credits: Ruiz, Nataniel et al. “DreamBooth: Fine Tuning Text-to-Image Diffusion Models for Subject-Driven Generation.” (2022).

関連記事

「好きなキャラに近い絵をAIが量産」――ある概念を“単語”に圧縮し入力テキストに使える技術

「好きなキャラに近い絵をAIが量産」――ある概念を“単語”に圧縮し入力テキストに使える技術

イスラエルのTel-Aviv UniversityとNVIDIAの研究チームは、ある概念を新しい単語(論文ではnew pseudo-wordと表現している)に置き換え、その新しい単語を一部に用いた文章を画像生成AIの入力に使用するシステムを開発した。 AIイラスト生成「mimic」、β版の全機能を停止 不正利用などの課題を改善次第、正式版をリリース

AIイラスト生成「mimic」、β版の全機能を停止 不正利用などの課題を改善次第、正式版をリリース

絵の個性を反映したイラストを無限に生成できるAIサービスとして話題を集めている「mimic」(ミミック)がβ版の全機能を停止する。運営会社のラディウス・ファイブが発表した。不正利用に関わる課題を改善できた場合、mimicの正式版をリリースするという。 イラストレーターの個性を学んで絵を“無限生成”するAIサービス 15枚のイラストから学習

イラストレーターの個性を学んで絵を“無限生成”するAIサービス 15枚のイラストから学習

クリエイティブ関連のAIサービスを手掛けるラディウス・ファイブが、AIイラストメーカー「mimic」(ミミック)β版の提供を開始した。同じイラストレーターが描いた15枚程度のイラストをもとに、絵の個性を反映したイラストを無限に生成できるとうたう。 画像生成AI「Stable Diffusion」がLINEのチャットbotに 九工大の学生が作成 日本語にも対応

画像生成AI「Stable Diffusion」がLINEのチャットbotに 九工大の学生が作成 日本語にも対応

画像生成AI「Stable Diffusion」を使ったLINEのAIチャットbotサービス「お絵描きばりぐっどくん」が公開された。文章を送ることで、AIが画像を生成する。 AI作成の画像を修正する技術 単語を変えて「自転車に乗る猫」を「車に乗る猫」に 米Googleらが開発

AI作成の画像を修正する技術 単語を変えて「自転車に乗る猫」を「車に乗る猫」に 米Googleらが開発

米Google ResearchとイスラエルのTel Aviv Universityの研究チームは、AIが文章から生成した画像に修正を加えられる技術を開発した。入力に使った文章の一部を修正することで画像全体を大幅に変えず、その部分だけをピンポイントで変えられる。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR