Google、マルチモーダルVML「PaLM-E」搭載ロボットのデモを公開

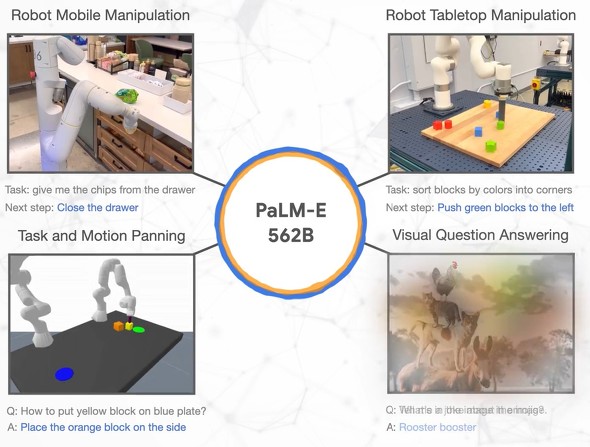

米Googleと独ベルリン工科大学の研究者らは3月6日、ロボット制御のための具現化されたマルチモーダルな視覚言語モデル「PaLM-E」についての論文を発表した。視覚と言語を統合する、5620億ものパラメータを備えた視覚言語モデル(VLM)だ。

PaLM-E(Pathways Language Model with Embodied)は、Googleが昨年のGoogle I/Oで発表した大規模言語モデル(LLM)「PaLM」をベースにしており、画像や状態推定などの視覚的な入力を受け取り、自然言語で出力できる。これにより、ロボットは人間の音声による命令を受けてタスクを実行できる。

例えば、ロボットに「引き出しからスナックの袋を出して持ってきて」と口頭で頼むと、ロボットは頭脳であるPaLM-Eと搭載したカメラの視野に映る情報に基づいて命令を実行に移す。

Githubで公開された動画では、ロボットが引き出しを開けてスナックを取り出し、それを人間が横からこっそりまた引き出しに戻すとまたスナックを取り出し、アームでつかんで命令した人間のところまで運ぶ様子を見ることができる。

つまり、状況が変化するとそれに対応できる。前処理されたデータではなく、視野に映るデータを解析・解釈するから可能なことだ。PaLM-Eは画像やセンサーからのデータを言語トークンと同程度のサイズのベクトルにエンコードし、言語処理と同じ方法でこれらの感覚情報を理解する。こうして従来よりも自律的なロボット制御が可能になる。

研究者らは、ホームオートメーションや産業用ロボットなどのシナリオで、PaLM-Eを調査していく計画だ。

関連記事

Google、「モラベックのパラドックス」打破目指すロボットプロジェクト

Google、「モラベックのパラドックス」打破目指すロボットプロジェクト

Alphabet傘下のGoogleとEveryday Robotsは、ヘルパーロボットに(ロボットにとって)難しい命令を実行させるための共同研究「PaLM-CanSay」を発表した。「飲み物をこぼした。助けてくれる?」と言うとスポンジを持ってくるなど、高い確率で適切な対応ができるとしている。 タチコマのように並列化し進化する、 Google親会社の日常家事ロボット

タチコマのように並列化し進化する、 Google親会社の日常家事ロボット

多くの企業が「メタバース」を喧伝する中、Googleの親会社はロボット事業をXから独立させました。AIを駆使し、タチコマのように並列化することで、汎用ロボット開発の可能性が開けたそうです。 Googleの親会社Alphabet、「X」のロボット部門を「Everyday Robots」としてスピンアウト

Googleの親会社Alphabet、「X」のロボット部門を「Everyday Robots」としてスピンアウト

Alphabetはムーンショット部門「X」のロボット事業を「Everyday Robots」としてスピンアウトした。既にプロトタイプ100体以上がGoogleのキャンパスを動き回っている。人間には簡単でもロボットには難しい日常業務を機械学習でで習得中だ。 Google、OpenAIの「ChatGPT」競合「Bard」を限定公開

Google、OpenAIの「ChatGPT」競合「Bard」を限定公開

Googleは、「ChatGPT」と競合する“実験的な会話型AIサービス”の「Bard」の提供を開始する。まずは限定公開だが、「向こう数週間中により広く公開する」。また、Google検索にクエリにテキストで答える新AI機能を間もなく追加する。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR