Google I/O 2022基調講演まとめ

米Googleは5月11日(現地時間)、年次開発者会議「Google I/O」をオンラインで開催した。約2時間の基調講演で発表されたことを時系列で簡単にまとめる。なお、開発者向け基調講演は別途行われており、技術的な詳細はそちらで発表された。

昨年のGoogle I/Oはキャンパス内の広場のようなところでの開催だったが、今年は2020年まで開催に使っていた本社キャンパス近くの野外イベントスペースShoreline Amphitheatreでパートナー開発者と従業員の観客入りで開催され、世界にライブ配信された。

最初に登壇したスンダー・ピチャイCEOは、Googleのミッションである「世界中の情報を整理し、世界中の人々がアクセスし、使えるようにする(Organize the world's information and make it universally accessible and useful)」の下、提供している現行のサービスや製品について紹介した。例えばロシアによる侵攻でポーランドなど世界に避難したウクライナの難民の生活にGoogle翻訳が役立っていることなどだ。

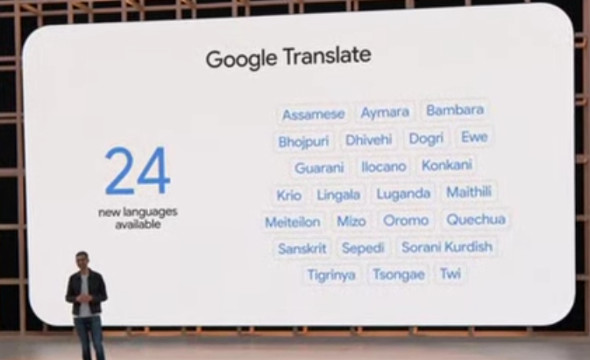

Google翻訳に24カ国語追加

その話からAIと機械学習により、Google翻訳が新たに3億人以上が使っている24カ国語に対応することを発表した。

Googleマップの「没入型ビュー」

次にGoogleマップの新機能として、「immersive(没入型) view」を紹介した。東京やロンドンなど一部の都市のランドマークやレストランなどの目的地に上空から飛び込んでいくようにして入っていける機能だ。「何十億ものストリートビューと航空写真を融合して」デジタルモデルを構築したという。

例えばウェストミンスター寺院を検索すると、ロンドン上空から寺院の周辺を見、そのまま寺院の中に入れる。同時にアクセス手段や混雑する時間帯などの情報にもアクセスできる。

この機能は年内に、東京、ロサンゼルス、ロンドン、ニューヨーク、サンフランシスコで展開開始だ。

Googleマップ関連ではこの他、ナビでエコフレンドリーなルートを紹介する機能が米国以外でも利用できるようになること(日本はまだ)、ARナビ機能「Live View」で採用する「Geospatial API」をARCoreの開発者に公開し、ストリートビューが使える場所であればどこででも利用できるようにしたことなども発表した。

YouTubeの自動チャプター機能と自動翻訳字幕が向上

YouTubeでは、長い動画をチャプターに区切ることができる。チャプターを自動生成する機能も既にあるが、DeepMindのマルチモーダル技術を採用することで、より正確な自動生成チャプターが可能になった。

また、自動翻訳字幕がモバイルで利用できるようになる。対応するのは16カ国語。6月にはウクライナ語の動画でも利用可能にする。

GoogleドキュメントのAI要約機能

これもAI(の自然言語処理)採用の機能で、長大な文書の内容をAIが短くまとめてくれるというものだ。

将来的にはGoogleチャットやGoogle Meetのテキスト化したものもまとめてくれるようになるという。

Google Meetの新機能

Google Meetの映像で、顔の明るさを調整したり、Pixelシリーズの「ポートレートライト」機能のように、光源の位置を人工的に変えることで顔に光を当てたりできるようになる。

Google検索の「マルチ検索」に「near me」と「シーン探索」

4月に発表したGoogle Lensの「マルチ検索」で「near me」オプションが可能になる。人は購入したい商品を検索することが多いので、その商品を近所で売っている店を探しやすくするものだ。例えばプルコギの画像で「near me」をタップすると、近所の韓国料理レストランが表示される。

「scene exploration」は、複数のオブジェクトの情報を表示する。デモでは、スーパーの店頭に並ぶキャンディバーをGoogle Lensで表示すると、レビューの点数やカロリーなどをARで表示できた。

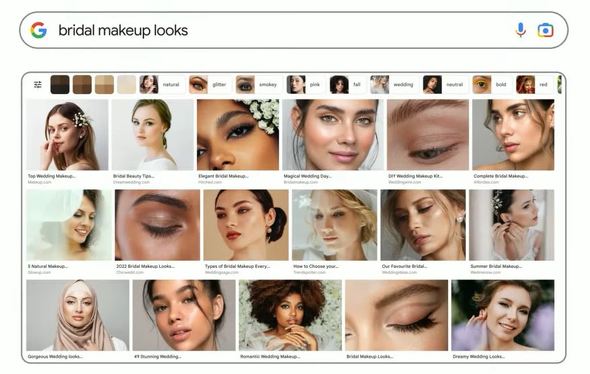

この他、例えば自分に合うアイシャドウを選ぶ際などに自分の肌色(スキントーン)に絞って検索できる「Skin Tone」も紹介した。

「へい、Google」と言わなくて済む2つの方法

次はGoogleアシスタントの新機能。まずカメラ付きのスマートディスプレイ「Nest Hub Max」で、カメラを見つめるだけでウェイクワード(Hey Google)を言わずにGoogleアシスタントを起動できるようになる。端末をただ見るだけでなく、アイコンタクトを取ろうとしないと起動しないよう多様な機械学習モデルを使っているという。

もう1つは「クイックフレーズ」。「ダイニングの灯りをつけて」「3分のタイマーをセット」「今何時?」など、よく使うフレーズを予め設定しておくと、そうしたフレーズについてはウェイクワードなしで使えるようになる。

いずれの方法も、オプトインだ。

さらに、かなり曖昧な質問でも推測して答えてくれるようになる。例では、「あのグループの新曲をかけて。えーーーーと」と言うと、「えーーーっと」と次の言葉を待ってくれて、グループ名も曲名がうろおぼえて「フローレンスとなんたらっていうグループの」と続けると、「わかりました。Florence+the Machineの「Free」をSpotifyでストリーミングします」と応じ、再生を始める。

LaMDA 2とPaLM

再度ピチャイ氏が登場し、自然な会話を実現するための言語モデル「LaMDA」が「2」になり、「Test Kitchen」ツールで最初のフレーズを入力してオリジナルストーリーを構築させたり、様々な質問に答えさせたりできるようになる。

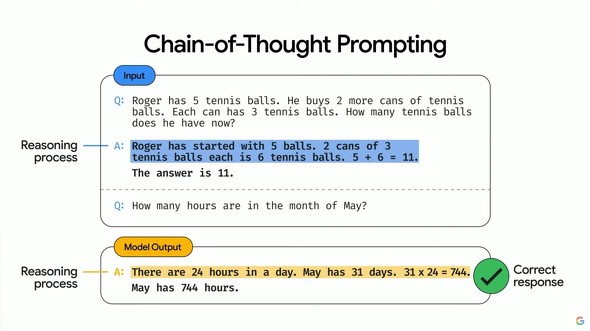

ピチャイ氏はもう1つの言語モデル「PaLM」も紹介した。5400億ものパラメータを持ち、Chain of Thought(思考の連鎖)を促して、思考のプロセスを段階的にたどれるため、従来の言語モデルより精度の高い結果を表示できるという(公式ブログ)。

セキュリティ関連(パスワード不要の未来へ)

Googleは6日、Apple、Microsoftとともに「端末やプラットフォームを超えてサインインできるようにする」と発表している。

Google I/Oでも、Android端末を利用する2要素認証の普及状況などを説明した。この方法を既に1億5000万人以上が利用しているという。

また、サイバー攻撃の最も多い「入り口」であるフィッシングの対策として、Googleドキュメント、シート、スライドにもフィッシング対策機能を搭載すると発表した。メールに添付されたりWebで公開されているこれらのファイルをダウンロードしようとすると、「このファイルは疑わしいです」というプロンプトが表示される。

VisaやMastarCardの「バーチャルカード」

「Virtual Card」は、ChromeブラウザとAndroid端末で使える仮想のクレジットカード。まずは米国で今夏、Visa、American Express、Mastercard、CapitalOneで利用できるようになる。

Chromeでは既にセキュリティコードを入力するだけでカード情報を使えるようになっているが、バーチャルカードは、実際のカード番号を個別の仮想番号に置き換えることでセキュリティを強化するというものだ。これにより、セキュリティコードも手入力する必要がなくなる。

(この発表あたりから、登壇者の腕にPixel Watchが見えるようになってきた。)

個人情報を使わずに最適な広告を表示するために

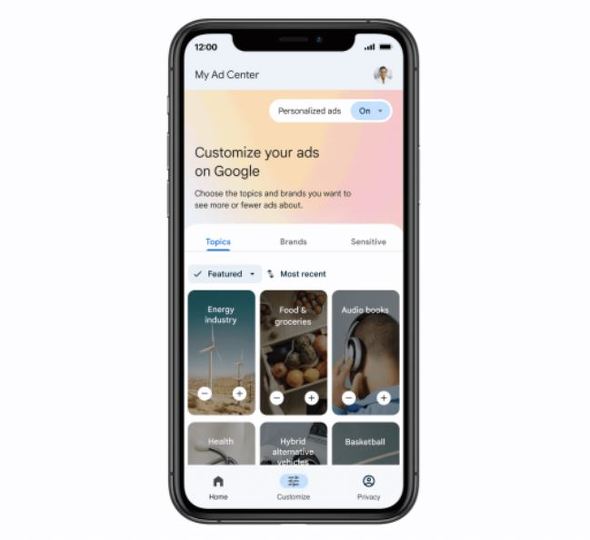

次に登壇したTrust(信頼)担当副社長のダニエル・ロメイン氏は開口一番、「私たちはあなたの個人情報を売ることは決してありません」と語り、個人情報を極力使わずに各ユーザーにパーソナライズした広告を表示するための取り組みについて説明した。

そのための機能の1つとして、年内に「My Ad Center」を立ち上げる。ここでは、検索やYouTubeなどで表示される広告のカテゴリーなどを簡単に設定できるとしている。

Android 13の新機能について 「Google Wallet」など

既に公開されているパブリックβの機能の説明が中心だったが、同日パブリックβ 2がリリースされた。

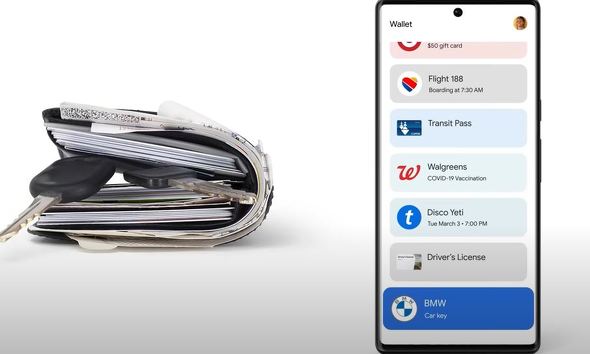

新機能として「Google Wallet」が紹介された。

あのGoogle Walletではない。米Appleの「Apple Wallet」のように、クレジットカード、プリペイドカード、交通系ICカード、運転免許証(まずは米国)などを登録してそれらの代わりに使える新しいアプリだ。

Androidだけでなく、Wear OS版もあるため、今秋登場予定のスマートウォッチ「Pixel Watch」(後述)でも利用できる。

(この後、今シーズン初めてスポンサーになったF1のマクラーレンチームについての動画が流れた。)

Pixel 6a

基調講演も1時間30分たったあたりで、ようやくハードウェアの発表がはじまった。

まずは「Pixel 6a」。詳細は別記事を参照されたい。発売は今夏だ。

Pixel 7

これまではGoogle I/OではPixelのaシリーズを、10月のMade by GoogleイベントでPixelのメインシリーズを発表してきたが、今回はちら見せではあるが「Pixel 7/7 Pro」も紹介した。詳細は別記事。発売は今秋。

Pixel Buds Pro

次は無線イヤホンの「Pixel Buds Pro」。Pixel 6aに合わせて今夏発売。アクティブノイズキャンセリング機能搭載で将来的には空間オーディオにも対応するとしている(別記事)。

Pixel Watch

ここでようやく、デバイス&サービス担当上級副社長、リック・オステルロー氏が登場し、ついに「Pixel Watch」を発表した。

こちらはPixel 7シリーズに合わせて今秋発売の予定(別記事)。

Pixel Tablet

ハードウェアはここまでと思いきや、2023年にはオリジナルタブレット「Pixel Tablet」を発売するとオステルロー氏。詳細はほとんど不明だが、Androidの大画面対応などが、ここに生かされるのだろう(別記事)。

ARメガネ

最後にピチャイ氏が再登場し、ARについて語りだした。メタバース礼賛の世情を批判するかのように「リアルな世界は素晴らしい」と強調し、GoogleのAR技術はリアルな世界を便利にするためのものだと語った。

ARメガネは動画でのみの紹介。製品化の時期などについては何も説明がなかった。同社は「Google Glass」とは別にProject Irisの下でコンシューマー向けのスマートグラスに取り組んでおり、2024年発売の計画と報じられていた(別記事)。

関連記事

「Pixel Watch」正式発表 Google初のスマートウォッチ 2022年秋に登場

「Pixel Watch」正式発表 Google初のスマートウォッチ 2022年秋に登場

米Googleは、同社のテクノロジーカンファレンス「Google I/O 2022」において、Google初のスマートウォッチ「Pixel Watch」を発表した。 Google、「Pixel 7」を“チラ見せ” 次世代「Google Tensor」搭載 秋に登場予定

Google、「Pixel 7」を“チラ見せ” 次世代「Google Tensor」搭載 秋に登場予定

米Googleは、同社のテクノロジーカンファレンス「Google I/O 2022」において、新型スマートフォン「Pixel 7」「Pixel 7 Pro」の概要を発表した。 Google、「Pixel 6a」を正式発表 自社チップ搭載で5万3900円 7月28日発売【追記あり】

Google、「Pixel 6a」を正式発表 自社チップ搭載で5万3900円 7月28日発売【追記あり】

米Googleは、同社のテクノロジーカンファレンス「Google I/O 2022」において、新型スマートフォン「Google Pixel 6a」を発表した。国内価格は5万3900円。 Google、待望のANC搭載ワイヤレスイヤホン「Pixel Buds Pro」発表 2万3800円

Google、待望のANC搭載ワイヤレスイヤホン「Pixel Buds Pro」発表 2万3800円

米Googleは、同社の大型カンファンレス「Google I/O 2022」において、新型ワイヤレスイヤホン「Pixel Buds Pro」を発表した。国内価格は2万3800円。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR