ITmedia NEWS >

製品動向 >

Meta、マルチモーダルAI「ImageBind」をオープンソース化

» 2023年05月10日 09時30分 公開

[ITmedia]

米Metaは5月9日(現地時間)、マルチモーダルな情報をバインドするAIモデル「ImageBind」をオープンソース化したと発表した。

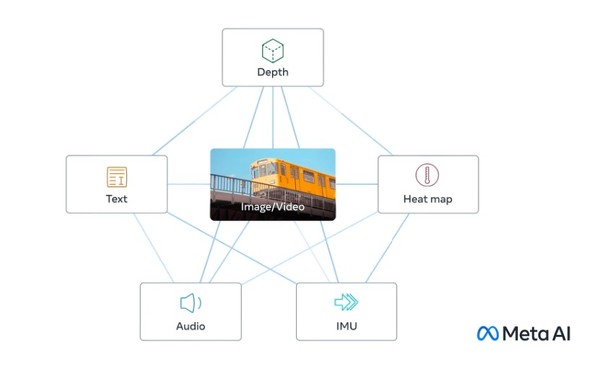

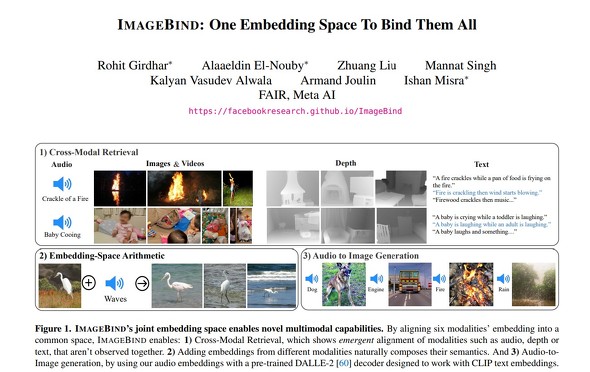

「マルチモーダル」は複数の「モダリティ」の処理が可能であることを示す。モダリティは、データの種類。ImageBindは、テキスト、画像および動画、音声、深度(3D)、熱(赤外線)、慣性測定単位(IMU)という6種類のモダリティの情報を単一の表現空間で学習する。

例えば、トラの写真を解析し、その吠え方、体温、動きなどの総合的な情報を生成したり、にぎやかな市場の音に基づいて市場の画像を生成したりできるという。

ImageBindは、モダリティの組み合わせごとのデータのトレーニングが不要で、複数のモダリティにわたって結合埋め込み空間を作成できる。

例えば、研究用に交通量の多い都市の道路からの音声データと熱データを1つのデータセットにすることも可能だ。

3DセンサーとIMUセンサーを組み合わせれば、没入型の仮想世界を開発することも可能だとMetaは説明する。「メタバース」の展開に役立ちそうだ。

マーク・ザッカーバーグCEOは直近の業績発表で、「われわれは何年もの間、AIとメタバースの両方に注力してきたし、今後も両方に注力していく。この2つの領域は関連している」と語った。

関連記事

Meta、手書きキャラをアニメ化するAIツール「Animated Drawings」をオープンソースで公開

Meta、手書きキャラをアニメ化するAIツール「Animated Drawings」をオープンソースで公開

MetaのAI部門は、描画をアニメ化するAIツール「Animated Drawings」をオープンソースで公開した。2021年に公開したデモで集めた160万件以上の描画でトレーニングした。クリエイターがアニメーションを簡単に作成できるようにすることを目指す。 Meta、画像内アイテム識別のAIモデル「SAM」と大規模データセットを無償公開

Meta、画像内アイテム識別のAIモデル「SAM」と大規模データセットを無償公開

MetaのAI部門Meta AIは、画像内のオブジェクトをセグメント化するAIモデル「SAM」を無償公開した。また、このモデルのトレーニングに使った大規模データセット「SA-1B」も公開。従来のマスクデータセットの400倍の規模だ。 Meta、ジェネレーティブAIのチーム結成を発表 AIペルソナ開発目指し

Meta、ジェネレーティブAIのチーム結成を発表 AIペルソナ開発目指し

MetaのザッカーバーグCEOは「ジェネレーティブAIチーム」結成を発表した。長期目標として、人間を支援するAIペルソナの構築を掲げた。 Meta、独自大規模言語モデル(LLM)の「LLaMA」を限定リリース

Meta、独自大規模言語モデル(LLM)の「LLaMA」を限定リリース

Metaは独自の大規模言語モデル「LLaMA」(Large Language Model Meta AI)を研究者向けにリリースした。「ChatGPT」のLLM「GPT-3.5」よりも小規模でも高性能としている。 Meta、動画生成AI「Make-A-Video」を発表 「肖像画を描くテディベア」などの作品公開

Meta、動画生成AI「Make-A-Video」を発表 「肖像画を描くテディベア」などの作品公開

Metaが動画生成AI「Make-A-Video」を発表した。「Stable Diffusion」や「Midjourney」、「DALL・E 2」などの画像生成AIの動画版。「浜辺を走るユニコーン」などの生成作品を公開した。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PRアイティメディアからのお知らせ

SpecialPR

あなたにおすすめの記事PR