OpenAIやDeepMindのCEOやトップ研究者ら、「AIによる人類絶滅リスク」警鐘声明に署名

AIに取り組む著名研究者、エンジニア、CEOなどのグループが5月30日(米国時間)、AIによる人類絶滅の危機について、新たな警告を発した。

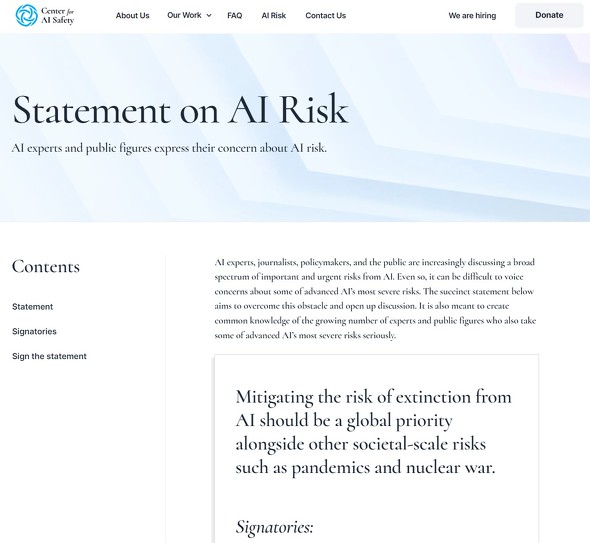

「Statement on AI Risk」(AIリスクに関する声明)に署名したのだ。広く受け入れられるよう簡潔にまとめられたこの声明は、「Mitigating the risk of extinction from AI should be a global priority alongside other societal-scale risks such as pandemics and nuclear war.」(AIによる絶滅のリスクを軽減することは、パンデミックや核戦争などの他の社会的規模のリスクと並んで世界的な優先事項とすべきだ)というものだ。

この声明は、サンフランシスコに拠点を置く非営利団体Center for AI Safety(CAIS)が発出した。

チューリング賞を受賞したジェフリー・ヒントン博士とモントリオール大学のヨシュア・ベンジオ教授、米OpenAIのサム・アルトマンCEO、米Google DeepMindのデミス・ハサビスCEO、米Anthropicのダリオ・アモデイCEOなどが署名している。

日本からも、全脳アーキテクチャ・イニシアティブ代表の山川 宏氏、慶應義塾大学特別招聘教授の高橋恒一氏が署名している。

ヒントン氏らと同時にチューリング賞を受賞した米Metaのヤン・ルカン博士は署名していない。同氏は「人間を超えるAIはまだ存在しないので、リスクのリストの上位に位置づけるのはまだ早すぎる。せいぜい犬レベルのAIの基本設計ができるまでは、AIを安全にする方法を議論するのは時期尚早だ」とツイートした。

主なAI関連企業で署名した従業員がいない企業は、Apple、Amazon、Microsoft、Meta、NVIDIA、IBM、Intel、Salesforceなど。イーロン・マスク氏も署名していない。なお、GoogleMindの親会社であるGoogleも署名していない。(本稿執筆現在)

CAISのエグゼクティブディレクター、ダン・ヘンドリックス氏は米New York Timesに対し、声明を簡潔にしたのは、意見の相違を避けるためと語った。3月にFLIが公開したAI開発を6カ月停止するよう呼びかける署名運動に対しては、リスクは認めるが開発停止は解決にならないなどの批判が寄せられた。

CAISは「AIリスクの8つの例」という文書を公開している。この文書では、「AIがより高度になると、最終的には壊滅的なリスクや存続リスクを引き起こす可能性がある」としている。

AIは人間が作成したコンテンツと区別するのが難しいテキスト、画像、ビデオを生成できるようになりつつあり、偏見を永続させ、自律型兵器を強化し、誤った情報を広め、サイバー攻撃を実行するためにも使用される可能性がある。さらに、AIが自律的に行動できるようになれば、人間はAIを制御できなくなるリスクが高まる──とCAISは説明している。

関連記事

OpenAIのアルトマンCEO、“スーパーインテリジェンス”の国際規制機関立ち上げを提唱

OpenAIのアルトマンCEO、“スーパーインテリジェンス”の国際規制機関立ち上げを提唱

OpenAIは、将来的にはAI開発を監視する国際規制機関が必要になると提唱した。10年以内にAIはAIGを超えるsuperintelligence(超知能)になるという。ただし、現行のプロジェクトを規制すべきではないとも。 米バイデン政権、OpenAIなどAI関連4社のCEOを招き「責任あるイノベーション」促す

米バイデン政権、OpenAIなどAI関連4社のCEOを招き「責任あるイノベーション」促す

米バイデン政権は、Google、OpenAI、Microsoft、AnthopicのCEOをホワイトハウスに招集。AI開発に関する「率直で建設的な議論が行われた」としている。 “AIのゴッドファーザー”ことヒントン博士、Googleを退社してAI開発に警鐘

“AIのゴッドファーザー”ことヒントン博士、Googleを退社してAI開発に警鐘

“AIのゴッドファーザー”の二つ名を持つジェフリー・ヒントン博士がGoogleを辞めた。New York Timesのインタビューで「Googleを辞めたので、AIのリスクについて自由に話せるようになった」と語った。企業がAIシステムを改善するにつれて、危険は増大すると警鐘を鳴らす。 OpenAI、「AI の安全性に対する当社のアプローチ」を説明 「年齢確認オプション検討中」

OpenAI、「AI の安全性に対する当社のアプローチ」を説明 「年齢確認オプション検討中」

OpenAIが「AIの安全性に対する当社のアプローチ」を説明した。「GPT-4より強力なAIの開発を直ちに停止せよ」という署名運動などを受けたものとみられる。「悪用する方法をすべて予測することはできない」が新しいシステムのリリースは慎重に行っていると主張する。 AI開発停止要求署名は無意味、透明性と説明責任の改善を──Hugging Faceのルッチョーニ博士

AI開発停止要求署名は無意味、透明性と説明責任の改善を──Hugging Faceのルッチョーニ博士

イーロン・マスク氏などが署名した「GPT-4より強力なシステム開発を停止せよ」という公開書簡について、AI研究者が「非現実的で不必要」と評した。それよりもガイドラインを作成し、透明性と説明責任を改善すべきだと主張する。 「GPT-4より強力なAIの開発を直ちに停止せよ」──公開書簡にマスク氏やウォズニアック氏が署名

「GPT-4より強力なAIの開発を直ちに停止せよ」──公開書簡にマスク氏やウォズニアック氏が署名

非営利のAI研究組織FLIは巨大AI実験の一時停止を求める書簡を公開した。「GPT-4より強力なAIの開発を少なくとも6カ月停止せよ」としている。マスク氏やウォズニアック氏、「サピエンス全史」のハラリ氏などが署名済みだ。 OpenAI、AGI(人間より賢いAI)へのロードマップを公表 「世界に深刻な害を及ぼす可能性」回避のために

OpenAI、AGI(人間より賢いAI)へのロードマップを公表 「世界に深刻な害を及ぼす可能性」回避のために

会話型AIサービス「ChatGPT」を手掛けるOpenAIは、AGI(Artificial General Intelligence;汎用人工知能)実現のロードマップを公開した。同社はAGIを「一般的に人間より賢いAIシステム」と定義する。AGIが世界に害を及ぼさないよう、公開協議が必要としている。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR