YouTuber向けカメラマンロボット 出演者の動きや話をAIで理解、最適なカメラワークを実行:Innovative Tech

Innovative Tech:

このコーナーでは、テクノロジーの最新研究を紹介するWebメディア「Seamless」を主宰する山下裕毅氏が執筆。新規性の高い科学論文を山下氏がピックアップし、解説する。Twitter: @shiropen2

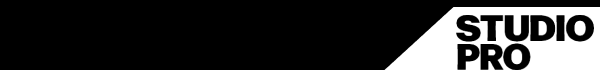

カナダのトロント大学とシンガポールマネジメント大学に所属する研究者らが発表した論文「Stargazer: An Interactive Camera Robot for Capturing How-To Videos Based on Subtle Instructor Cues」は、出演者の動きや話の内容に応じて自律的に動くカメラマンロボットを提案した研究報告である。

カメラマンロボットは、7つの独立したモーターが自律的に動作するロボットアームに1台のカメラを取り付け、柔軟なカメラワークを実行する。また、RGBカメラや深度センサー(Kinect v2)が検知した出演者の動きと、ワイヤレスマイクで検知した出演者のスピーチをカメラワークに生かす。

カメラの位置調整は、出演者の微妙な動きや話す内容に基づいて行われる。例えば、机上でアイテムを紹介する動画の場合、出演者が両手を使ってアイテムを操作している場合には、自律的にクローズアップが行われる。出演者がアイテムを手に持ちながら顔の横で話す場合には、出演者とアイテムがフレーム内に収まるように調整する。出演者が意図的にアイテムを指さして注目を引くような場合、カメラはそれに対応して位置を調整する。

話す内容に基づいた移動では、例えば、出演者が視聴者に「AをBに入れるところを上から見てください」と言った場合、システムはその要求に応えて、ハイアングルからの映像をフレームに収め、視聴者によく見えるように調整する。

出演者のスピーチは、まずマイクで録音し、次に音声認識システム「Microsoft Azure Speech-to-Text」を使用してテキストに変換する。その後、得たテキストは大規模な言語モデルであるGPT-3へ送り、出演者のカメラに対する意図を理解するために訓練する。

このように出演者は、表向きは視聴者に向けたジェスチャーや発話で、カメラフレームやアングルを変更するよう合図できる。

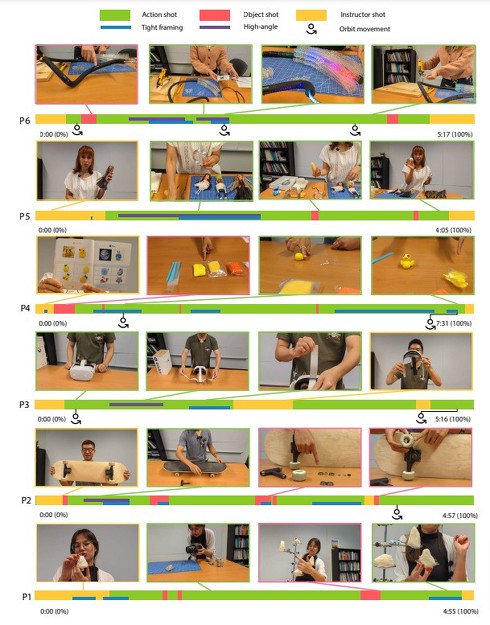

実験では、プロ映画監督2人を含む6人の参加者を対象に、カメラマンロボットを使用した撮影が満足いくものとなるかをユーザー調査した。その結果、参加者は練習セッションを受けた後、2テイク以内に動画の収録を完了した。参加者全員が作成した動画の品質に満足していることが確認できた。

今回は初期研究として、机上でのチュートリアル動画を紹介することに焦点を当てている。将来的には、より広範な環境でのタスクをさまざまな角度から撮影するために、カメラドローンや車輪付きロボットの可能性も検討していきたいと考えている。

Source and Image Credits: Jiannan Li, Mauricio Sousa, Karthik Mahadevan, Bryan Wang, Paula Akemi Aoyagui, Nicole Yu, Angela Yang, Ravin Balakrishnan, Anthony Tang, and Tovi Grossman. 2023. Stargazer: An Interactive Camera Robot for Capturing How-To Videos Based on Subtle Instructor Cues. In Proceedings of the 2023 CHI Conference on Human Factors in Computing Systems(CHI ’23). Association for Computing Machinery, New York, NY, USA, Article 800, 1-16. https://doi.org/10.1145/3544548.3580896

関連記事

YouTubeで“聞こえない音”を流し、スマホを遠隔操作する攻撃 音声アシスタント機能を悪用

YouTubeで“聞こえない音”を流し、スマホを遠隔操作する攻撃 音声アシスタント機能を悪用

米テキサス大学サンアントニオ校と米コロラド大学コロラドスプリングス校に所属する研究者らは、スマートフォンやスマートスピーカーの音声アシスタント(Siri、Google Assistant、Alexa、Cortana)に対する不可聴攻撃を提案した研究報告を発表した。 YouTubeで不正に収益化する6つの悪用方法、米研究者らが分析結果を公開

YouTubeで不正に収益化する6つの悪用方法、米研究者らが分析結果を公開

米シカゴ大学と米パデュー大学の研究チームは、YouTubeの不正収益化行為を研究した論文を発表した。世界中のオンラインコミュニティーとYouTubeアカウント売買サイトから複数の情報を集め、分析して6つのカテゴリーに不正行為をまとめた。 排便の音を聞いて“下痢”かを判定するAI 精度98%で特定 YouTubeなどからトイレの音350件を学習

排便の音を聞いて“下痢”かを判定するAI 精度98%で特定 YouTubeなどからトイレの音350件を学習

米ジョージア工科大学に所属する研究者らは、トイレに設置したセンサーで排便の音を録音し、下痢かどうかを判断する機械学習モデルを提案した研究報告を発表した。コレラなどの腸に関する病気の早期発見に役立てたいという。 Googleの“2年放置アカウント削除”、YouTube投稿アカは対象外に

Googleの“2年放置アカウント削除”、YouTube投稿アカは対象外に

Googleは、2年間使用またはログインされていない個人用Googleアカウントを削除する新ポリシーについて、YouTube動画を含むアカウントは対象外にする方針を示した。 ウマ娘のYouTubeチャンネル「ぱかチューブっ!」収益化 収益の一部は「馬事産業の発展のための費用へ」

ウマ娘のYouTubeチャンネル「ぱかチューブっ!」収益化 収益の一部は「馬事産業の発展のための費用へ」

Cygamesは、メディアミックスコンテンツ「ウマ娘プリティーダービー」のYouTubeチャンネル「ぱかチューブっ!」を収益化させると発表した。収益の一部は「馬事産業の発展のための費用として充てていく」としている。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR