Meta、テキストや旋律から音楽を生成するAI「MusicGen」をオープンソース化 Hugging Faceでお試し可能

米Metaは6月9日(現地時間)、音楽生成LMの「MusicGen」を発表した。ディープラーニングによる音声処理と生成のためのライブラリ「Audiocraft」の一部として、GitHubでオープンソース化した。商用利用も可能だ。

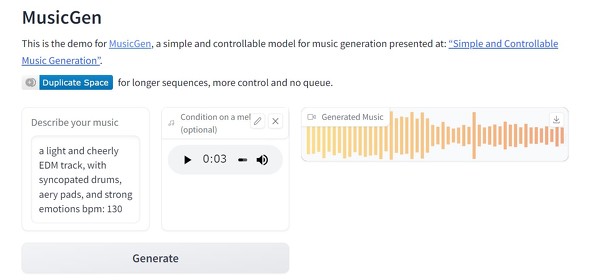

曲のイメージをテキストプロンプトで入力することで音楽を生成できる。オプションで、mp3形式のメロディデータを追加することも可能だ。

MusicGenは、米Googleが2017年に発表した深層学習モデル「Transformer」をベースにした音楽生成モデル。Googleが1月に発表した「MusicLM」のような従来の類似モデルとは異なり、自己教師型でセマンティック表現が不要だ。

MusicGenのトレーニングには、1万件の高品質な音楽トラックの内部データセットと、ShutterStockとPond5の音楽データを利用した。2万時間分のライセンス音楽を使ったとしている。

Audiocraftのインストールには、少なくとも16GBのメモリを備えるGPU、Python 3.9、PyTorch 2.0.0が必要。

デモがHuggingFace Spaceで公開されており、例えば「重厚なドラムとシンセパッドをバックに据えた、80年代のドライブ向けポップソング。テンポは130bpmで」としてバッハのトッカータとフーガの最初のフレーズのmp3を添えて生成ボタンをクリックすると、約2分でそれらしい音楽が生成される。

論文(PDF)によると、3サイズ(3億、15億、33億)のパラメータのモデルでテストしたところ、当然大きなモデルの方が高品質なオーディが生成できたが、人間は15億パラメータによる楽曲を最もよく評価したという。

関連記事

Meta、4000言語の話し言葉を理解する多言語LLM「MMS」をオープンソース化

Meta、4000言語の話し言葉を理解する多言語LLM「MMS」をオープンソース化

Metaは、4000以上の音声言語を理解する多言語大規模言語モデル「MMS」をオープンソースで公開した。同様の既存技術の40倍の能力だとしている。これにより、たとえばメタバースでもユーザーは互いの母国語で会話できるようになるだろう。 Meta、AI強化に向けた自社開発のAIチップ、スパコン、データセンター、生成AIアシスタントを発表

Meta、AI強化に向けた自社開発のAIチップ、スパコン、データセンター、生成AIアシスタントを発表

MetaはAIに関する取り組みについて発表した。自社開発のAIチップ2種、スパコン「RCS」の進捗、GitHub Copilotのような「Code Compose」、AIデータセンターについてだ。 Meta、マルチモーダルAI「ImageBind」をオープンソース化

Meta、マルチモーダルAI「ImageBind」をオープンソース化

Metaは、マルチモーダルなAIモデル「ImageBind」をオープンソースで公開した。テキスト、画像および動画、音声、深度(3D)、熱(赤外線)、慣性測定単位(IMU)という6種類のモダリティをサポートする。「メタバース」生成にも使えそうだ。 歌詞を入力するだけでAIが作曲、歌ってくれる「SongR」話題 日本でも研究されてきた技術

歌詞を入力するだけでAIが作曲、歌ってくれる「SongR」話題 日本でも研究されてきた技術

Webブラウザから英語の歌詞を入力するだけで、AIが作曲して楽曲を自動生成する「SongR」が話題だ。日本語の歌詞なら、別の日本のサービスがおすすめだ。 Google、テキストから音楽を生成する「MusicLM」発表 リリースはせず

Google、テキストから音楽を生成する「MusicLM」発表 リリースはせず

Googleは、テキストから音楽を生成するAIモデル「MusicLM」を発表した。多数のサンプルを聞くことができるが、著作権侵害などの恐れがあるため、現時点では公開はしない。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR