ITmedia NEWS >

企業・業界動向 >

NII、130億パラメータのLLM構築 コーパスなども全公開 「今後の研究に資するため」

» 2023年10月20日 17時00分 公開

[ITmedia]

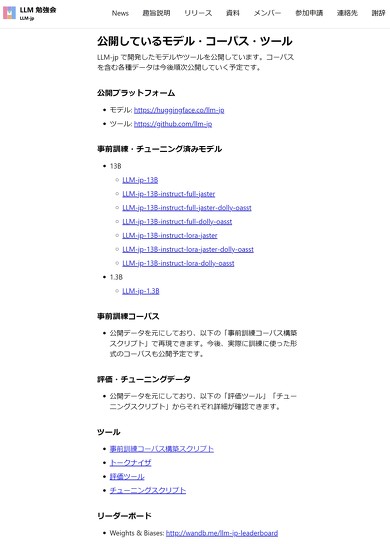

国立情報学研究所(NII)は10月20日、パラメータ数130億の大規模言語モデル(LLM)「LLM-jp-13B」を公開した。初期段階のモデルだが、アカデミアや産業界の研究開発に資するため、コーパスやツールなどを含めてすべてオープンにする。

公開したLLMの学習データ量は合計約3000億トークン。うち日本語は約1450億トークン(mC4/Wikipedia)、英語は約1450億トークン(The Pile/Wikipedia)、プログラムコード約100億トークン。

計算資源としては、大学や研究機関が共同運営する仮想化環境・データ活用社会創成プラットフォーム「mdx」を12ノード活用。モデル構築にはMicrosoftのDeepSpeedを、モデル構築時の監視やログの保存には、モデル開発プラットフォームのWeights&Biasesを利用した。

NIIが主宰するLLM勉強会(LLM-jp)で7月から構築してきたLLM。公開したモデルは初期段階のものであり、評価値はこれまで日本で公開されたものと同程度。そのまま実用的なサービスに利用することは想定していないが、今後の研究に貢献するために現段階で公開した。

今後、モデル学習用コーパスの検索ツールを公開する予定。産総研・東工大とも協力し、GPT-3級・1750億パラメータの日本語LLMの構築を目指す計画も発表している。

関連記事

「世界トップレベルの大規模言語モデルの開発に着手」──産総研らが表明 目指すのは“GPT-3級の日本語LLM”

「世界トップレベルの大規模言語モデルの開発に着手」──産総研らが表明 目指すのは“GPT-3級の日本語LLM”

「世界トップレベルの大規模言語モデル(LLM)の開発を始める」──産業技術総合研究所は、そんな声明を発表した。 PFNが生成AI新会社「Preferred Elements」設立へ 130億パラメータの和製LLMもオープンソースで公開

PFNが生成AI新会社「Preferred Elements」設立へ 130億パラメータの和製LLMもオープンソースで公開

AIベンチャーのPreferred Networks(PFN)は、生成AI事業に関する新子会社「Preferred Elements」を11月1日に設立すると発表した。併せて、研究・商用利用が可能な、130億パラメータの事前学習済み大規模言語モデル(LLM)「PLaMo-13B」も公開した。 約16万件の商品・サービスの口コミデータ、NIIが無償提供 自然言語処理などの研究向けに

約16万件の商品・サービスの口コミデータ、NIIが無償提供 自然言語処理などの研究向けに

国立情報学研究所(NII)は、商品・サービスの口コミサイト「みん評」を運営するマイスタースタジオと提携し、同サイトの口コミデータ約16万件を研究者向けに無償提供を始めた。 NEC、独自の日本語大規模言語モデルを開発 パラメータ数130億、クラウドで運用可能 性能も世界トップクラス

NEC、独自の日本語大規模言語モデルを開発 パラメータ数130億、クラウドで運用可能 性能も世界トップクラス

NECは、独自の日本語大規模言語モデル(LLM)を開発したと発表した。パラメータ数は130億で、クラウド/オンプレミス環境での運用も可能。性能面でも、世界トップクラスの日本語能力を実現しているという。 サイバーエージェント、日本語の大規模言語モデルを一般公開 最大68億パラメータ 商用利用可能

サイバーエージェント、日本語の大規模言語モデルを一般公開 最大68億パラメータ 商用利用可能

サイバーエージェントは最大68億パラメータの日本語LLM(大規模言語モデル)を一般公開した。ライセンスはCC BY-SA-4.0で、商用や研究目的で自由に利用できる。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PRアイティメディアからのお知らせ

SpecialPR

あなたにおすすめの記事PR