自分の文章がAIに学習されているか調べるツール 米国チームが開発

Innovative Tech:

このコーナーでは、2014年から先端テクノロジーの研究を論文単位で記事にしているWebメディア「Seamless」(シームレス)を主宰する山下裕毅氏が執筆。新規性の高い科学論文を山下氏がピックアップし、解説する。

Twitter: @shiropen2

米ワシントン大学と米プリンストン大学に所属する研究者らが発表した論文「Detecting Pretraining Data from Large Language Models」は、任意の文章が大規模言語モデル(LLM)で事前学習されているかを検出できるツールを提案した研究報告である。

LLMの訓練に用いられるデータの多くは非公開であり、その中には著作権で保護された文書や個人識別情報、ベンチマークのテストデータなど、問題を引き起こす可能性のあるテキストが含まれている場合がある。

過去の研究によれば、LLMが著作権で保護された書籍の一部を生成したり、個人のメールを生成したりしたことが示されている。これは元のコンテンツの作成者の法的権利を侵害し、プライバシーを侵す可能性がある。しかし、現時点では、どのような種類のデータがどれだけの割合で含まれているかを知る方法はない。

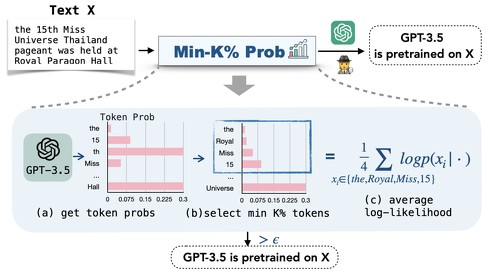

この研究では、どの事前学習データが使用されたか不明な状況で、特定のテキストがその言語モデルの事前学習データに含まれているか否かを判断できるかを評価する。この課題に取り組む基準として「WIKIMIA」というベンチマークを、また検出手法として「MIN-K% PROB」というアプローチを提案する。

WIKIMIAは、正確なベンチマークとして機能させるために、モデル訓練前後のデータを利用している。具体的には、モデルの公開日付とWikipediaのデータに基づいて、事前学習に使用されたと考えられる旧データと、事前学習後の新しいデータをWikipediaから収集している。このデータ収集は自動化されており、継続的に新しいデータをWikipediaから取り込むことで、ベンチマークを常に最新の状態に保っている。

MIN-K% PROBでは、あるテキストがモデルによって学習されたかどうかを判断するために、シンプルな仮定に基づいている。モデルが未知のテキストを処理する際、低い確率で出現する単語(外れ値)が含まれる傾向があるが、既知のテキストではそうした単語が含まれることは少ないと仮定している。MIN-K% PROBはこれらの予期せぬトークンの平均確率を計算し、モデルが特定のテキストを知っているかどうかを推測する。

実験結果によれば、提案された手法であるMIN-K% PROBは、従来の最も優れた方法よりも高い性能を示した。特に、WIKIMIAでの評価において、性能指標の一つであるAUCスコアが7.4%向上したことを確認した。加えて、検出性能はモデルの大きさや分析対象のテキストの長さと正の相関関係があることが明らかになった。

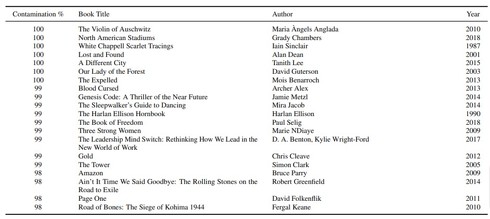

MIN-K% PROBの実用性を実際の環境で検証するために、「著作権のある書籍の検出」「プライバシー監査」「データセットの汚染検出」を含む3つのケーススタディーが行われた。これらのケーススタディーにおいて、MIN-K% PROBは従来の基準となる手法に比べて顕著に優れた性能を発揮した。

注目すべきケーススタディーは、「著作権のある書籍の検出」と「プライバシー監査」である。著作権のある書籍の検出に関する実験では、GPT-3がBooks3データセットに含まれる著作権で保護された書籍を使用して事前学習された可能性が高いことを示唆する強力な証拠が見つかった。

プライバシー監査のケーススタディーでは、著作権で保護された書籍の情報を忘れさせるように訓練されたLLMをMIN-K% PROBを用いて再検証した。その結果、当該モデルが依然として著作権で保護されたコンテンツを生成する可能性があることを示した。

Source and Image Credits: Shi, Weijia, et al. “Detecting Pretraining Data from Large Language Models.” arXiv preprint arXiv:2310.16789(2023).

関連記事

Google、生成AIによる著作権訴訟リスクで企業顧客に補償

Google、生成AIによる著作権訴訟リスクで企業顧客に補償

Googleは、Google CloudとWorkspaceで提供している「Duet AI」などで生成するコンテンツについて、著作権訴訟リスクを補償すると発表した。Adobe、Microsoftに続くものだ。 ChatGPTユーザーは毎週1億人 著作権侵害防止の「Copyright Shield」追加

ChatGPTユーザーは毎週1億人 著作権侵害防止の「Copyright Shield」追加

OpenAIはサンフランシスコで開催の初の開発者会議「DevDay」で、「ChatoGPT」のユーザー数が週当たり1億人になったと発表した。基調講演にはMicrosoftのサティア・ナデラCEOも登壇した。 日本にも“社内GPT”の導入相次ぐ 日本マイクロソフトが語る最新動向

日本にも“社内GPT”の導入相次ぐ 日本マイクロソフトが語る最新動向

「日本でAzure OpenAI Serviceを活用している企業数は560社以上」──日本マイクロソフトが10月23日に開催した、AIに関するメディア向け説明会にてそのように明かした。 「生成AIは著作権保護の検討が不十分」新聞協会など声明 「著作権法30条の4は大きな課題」

「生成AIは著作権保護の検討が不十分」新聞協会など声明 「著作権法30条の4は大きな課題」

新聞協会など4団体は、生成AIにまつわる著作権保護策の再検討を求める共同声明を発表した。日本の著作権法第30条の4が「諸外国に比べ、AI学習に極めて有利に作られていることは大きな課題」と指摘している。 “オリジナルCopilot”が作れる「Copilot Studio」登場 スタンドアロン型にも対応 GPTとも連携

“オリジナルCopilot”が作れる「Copilot Studio」登場 スタンドアロン型にも対応 GPTとも連携

米Microsoftは、AIプラットフォーム「Microsoft Copilot Studio」を発表した。自身の好みにカスタマイズした生成AIツール「Copilot for Microsoft 365」(Copilot)をローコードで作成できる。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR