ITmedia NEWS >

AI+ >

最強タッグ「OpenAI+Microsoft」を追いかけるAWS 勝機は“選べる自由”にあり(2/5 ページ)

» 2023年12月06日 13時00分 公開

[西田宗千佳,ITmedia]

AWSといえば膨大な演算能力 NVIDIAとも親密アピール

そんな生成AIについて、セリプスキーCEOは「3つのレイヤーがある」と話す。

1つは学習や推論を行うための「コンピューティングプラットフォーム」としての役割だ。大量のGPUや推論用のプロセッサなどを用意し、高い演算能力を必要とする生成AIの開発について、全ての企業が自前で演算インフラを用意するのは無理がある。AWSのような存在は「必要な時に必要な『火力』の提供」を期待されるものだ。

今回も、ArmコアCPUを使った高速演算CPUである「Graviton 4」やAIの学習を高速化する「Trainum 2」など、独自設計によるプロセッサ群が発表されている。特に、2024年提供開始が予定されているTrainum 2は最大65エクサFLOPSの演算能力を持ち、3000億パラメーターという大規模なLLM(大規模言語モデル)の学習をする場合でも、必要な期間を「数カ月から数週間に短縮できる」(セリプスキーCEO)という。

また、基調講演にはNVIDIAのジェンスン・フアンCEOがサプライズ登壇した。

今回NVIDIA・フアンCEOが登場したのは、両社の関係がハードウェアの提供のみならず、ソフトウェアにも拡大したためだ。NVIDIAのAIソフトウェアライブラリがAWSを介して顧客に提供されることになる。

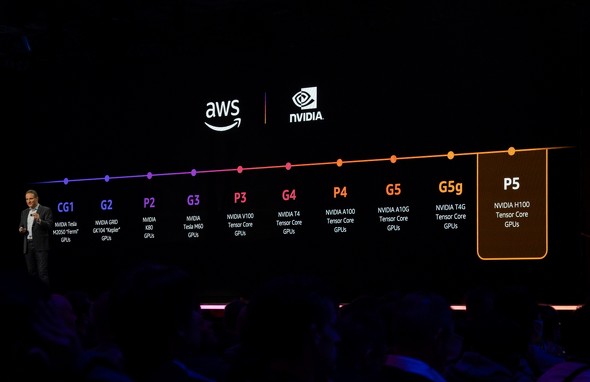

AWSは2010年からNVIDIAのGPUを演算資源として提供し続けており、お互いに非常に重要なパートナーでもある。セリプスキーCEOも「われわれが最初にNVIDIAのGPUインスタンスを提供した」と関係の深さを強調する。

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PRアイティメディアからのお知らせ

SpecialPR

あなたにおすすめの記事PR