最強タッグ「OpenAI+Microsoft」を追いかけるAWS 勝機は“選べる自由”にあり(3/5 ページ)

顧客は「LLMの選択肢」を求めている

ただ、NVIDIAのGPUによるLLMの学習・推論という基盤の提供については、他の事業者も多く手掛けている。だからこそNVIDIAのAI向けGPUは、高価にもかかわらず市場で取り合いの状況が続いている。

また、LLMの学習は確かに重要な要素とはいえ、全ての企業が1からLLMを学習・構築する必然性はない。多くの場合、学習済みのファウンデーション・モデル(基盤モデル)を使い、それぞれの企業に向けたファインチューニングを行って利用するはずだ。

すなわち、生成AIを構成する3つのレイヤーは、上位になるほど(当然だが)利用者が増え、ビジネス規模も大きくなっていくわけだ。

そうすると次の「モデル」レイヤーがポイントになってくる。

ここでセリプスキーCEOは、ライバルとの差を強くアピールし始める。

「(LLMの)モデルを考える時、顧客にとって重要なのは選択肢があることだ」

セリプスキーCEOはそう説明した。

LLMのモデルはすでに複数あり、パラメータサイズも技術的特徴も、ファインチューニングの在り方も異なる。導入企業が持つ「それぞれの持つ経営課題」解決を目指す場合、用途や課題に応じてLLMの選択を行うべきだし、顧客もそれを望んでいる……という主張だ。

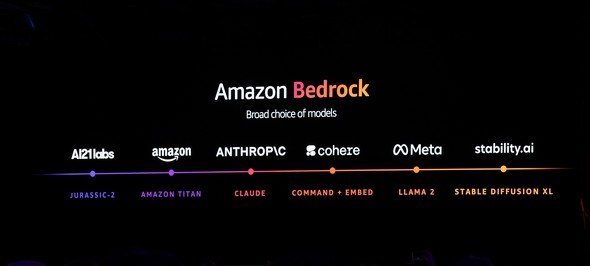

AWSは2023年4月、生成AIの基盤技術である「Amazon Bedrock」を発表、9月から一般提供を開始している。BedrockはOpenAIやGoogleの技術とは異なり、特定のLLMとひも付いたものではなく、「いろいろなLLMを活用するための基盤」でもある。

今回の基調講演では改めて、AmazonのLLMである「Titan」やMetaの「Llama 2」、Anthropicの「Claude」など、主要なLLMから用途に応じて選べることが強調された。

AnthropicのCEO兼共同設立者のダリオ・アモデイ氏もゲストスピーカーとして登壇、AWSとAnthropicの関係を改めてアピールしている。

これは言うまでもなく、OpenAI+Microsoft陣営や、自社LLMにこだわるGoogleに対するけん制といえる。特にOpenAIは先日、サム・アルトマンCEOらの解任&復帰騒ぎがあり、ガバナンスの不安が伝えられたばかり。ある種のリスクヘッジとして「LLMが選べる」ことは、確かに1つの差別化要素ではある。

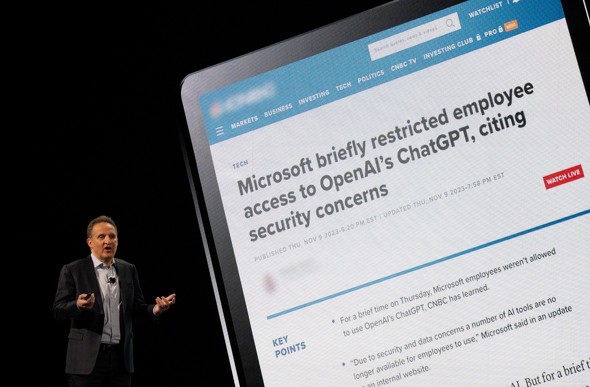

また、AWSにおけるセキュリティとプライバシーの考え方がBedrockにも適応されていることを強調。一部で報道されたOpenAIのセキュリティ問題を批判する一幕もあった。

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR