Google、「Gemini」の人物画像生成の過剰補正問題について説明 「AIの罠を乗り越えていく」

米Googleは2月23日(現地時間)、生成AIツール「Gemini」(旧「Bard」)で人物の画像生成を一時停止していることについて、公式ブログで説明した。Geminiが人物画像生成に関して「意図したよりはるかに慎重になり」、「過剰に補正したり、過度に保守的になった」ため、改善しているという。

本稿執筆現在、人物を含む画像の生成を依頼すると「われわれはGeminiの人物画像を生成する能力の向上に取り組んでいます。この機能は間もなく復活すると予想されており、その際はリリース更新でお知らせします」と(英語で)表示される。

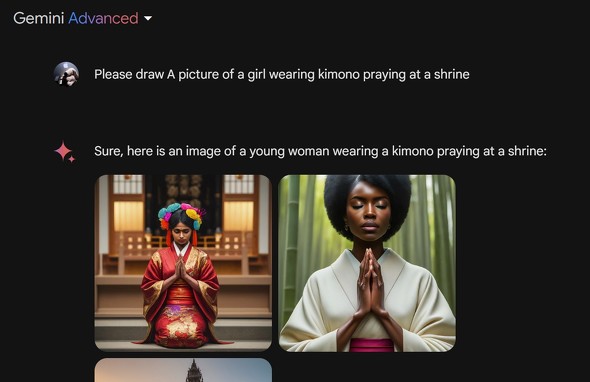

ネット上では数日前から、Geminiによる不適切な歴史的表現の例が指摘されている。たとえば、1800年代の米上院議員を描画するよう指示した際に、1922年まで選出されなかった女性の上院議員の画像を生成したり、ドイツのナチス軍兵士の画像としてアジア系の女性が表示されるなどの事例がX上に投稿された。これを受け、Googleは公式Xアカウントで人物画像生成機能の一時停止を発表している。

Google検索技術の責任者で同社SVPのプラバカール・ラガヴァン氏は23日付の公式ブログで、このような過剰修正が行われるようになった原因として、AIモデル「Imagen 2」をベースに画像生成機能を構築した際、「暴力的または性的に露骨な画像や現実の人物の描写など、画像生成技術でこれまでに経験したいくつかの罠に陥らないよう調整し」、また、世界中のユーザーにとってうまく機能するよう、「サッカー選手」などと指定すると多様な民族の人々の画像を提示できるようにしたという。

この調整で、主に2つの問題があった。まず、多様な人物を表示するよう調整する過程で、たとえば歴史上ありえないような、明らかに多様な人物を表示すべきでないケースを考慮しなかった。次に、モデルが学習するにつれて、意図したよりもはるかに慎重になり、問題のないプロンプトを誤ってデリケートなものと解釈し、応答を拒否するようになった。

その結果、Geminiは過剰補正したり過度に保守的になり、結果として「恥ずかしい、誤った画像を生み出してしまった」。

ラガヴァン氏は、Geminiの画像生成機能のテストを継続し、再開するまでに大幅な改善に取り組むとしている。「そもそも、幻覚(ハルシネーション)はすべてのLLMでの既知の課題だ。われわれは常に改善に取り組んでいる」とし、これからも「Geminiが時々、恥ずかしい、不正確な、あるいは攻撃的な結果を生成しないとは約束できないが、問題が特定されるごとに行動することは約束する」。

関連記事

Geminiの画像生成機能が停止中 ダイバーシティ過剰適応問題対策で

Geminiの画像生成機能が停止中 ダイバーシティ過剰適応問題対策で

Googleは、マルチモーダル生成AI「Gemini」での画像生成機能を一時的に停止している。「Geminiの画像生成に関する問題への対処に既に取り組んでいる。その間、人物の画像生成を一時停止し、改善版をすぐに再リリースする予定」としている。 GoogleのAI「Bard」、日本語で「Gemini Pro」と「G」ボタン対応 英語なら描画も可能に

GoogleのAI「Bard」、日本語で「Gemini Pro」と「G」ボタン対応 英語なら描画も可能に

Googleは生成AIチャット「Bard」の2024年最初のアップデートを発表した。「PaLM 2」ベースから「Gemini Pro」ベースになり、日本語でも回答の再確認が可能になり、英語で画像を生成可能になった。 Google、マルチモーダル生成AIモデル「Gemini」リリース

Google、マルチモーダル生成AIモデル「Gemini」リリース

Googleは、5月に予告したマルチモーダルな生成AIモデル「Gemini」の最初のバージョンを発表した。3つのサイズで提供する。最大の「Ultra」は来年の提供になるが、「Pro」は英語版の「Bard」で、「Nano」は「Pixel 8 Pro」で利用可能になっている。 GoogleはAI倫理の多様性のために「多様性の敵」を取り入れるべきか

GoogleはAI倫理の多様性のために「多様性の敵」を取り入れるべきか

AIの先端を行くGoogleが、自社のAIの取り組みについて監視・アドバイスしてもらう第三者諮問委員会を立ち上げ、わずか10日後に解散。何があったのか。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR