Alibaba、1枚の画像と音声でリアルな動画を生成する「EMO」発表

» 2024年03月01日 10時39分 公開

[ITmedia]

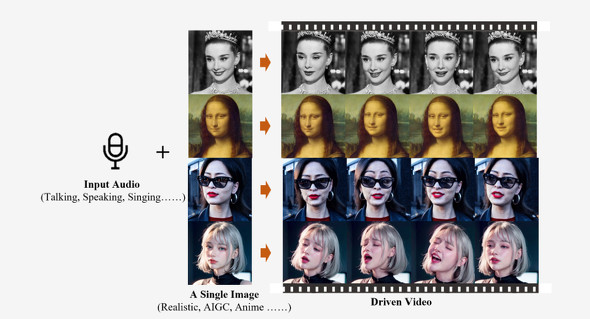

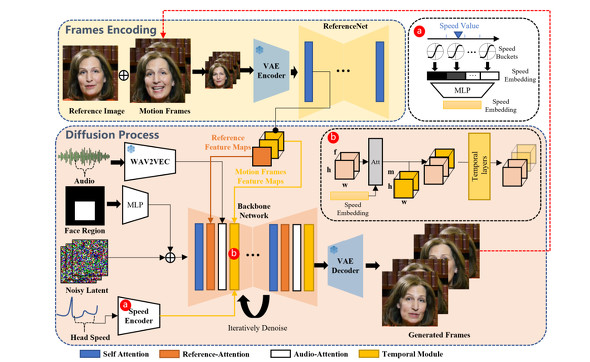

中国AlibabaのInstitute for Intelligent Computingは2月29日(現地時間)、「EMO」(Emote Portrait Alive)というAIシステムを発表した。1枚の人物画像をアニメーション化し、話したり歌ったりする動画を生成する。音声から動画に直接合成するアプローチを採用することで、リアルな動きを実現している。

オーディオ波形を動画フレームに変換することで、自然な音声に伴う微妙な顔の動きや人物固有のニュアンスをキャプチャするという。

研究者らは、モデルのトレーニング方法について、250時間以上の映像と1億5000万以上の画像を蓄積したオーディオ動画のデータセットを構築したと説明した。このデータセットには、複数の言語によるスピーチ、映画やテレビ番組のクリップなどが含まれているという。

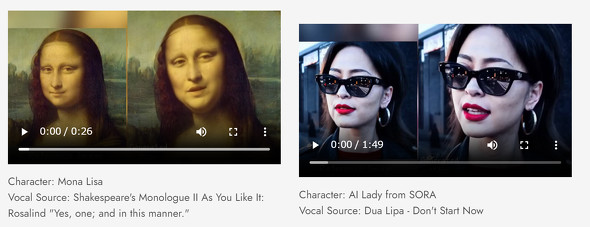

写真だけではなく、「モナリサ」などの絵画や米OpenAIが「Sora」の発表で紹介した架空の女性などがしゃべったり歌ったりする動画も紹介されている。

Alibabaは、このプロジェクトは学術研究と効果実証のみを目的としているという。GitHubにリポジトリはあるが、公開するかどうかは不明だ。

関連記事

OpenAI、テキスト→最長1分の動画の生成AI「Sora」発表 一般公開はせず

OpenAI、テキスト→最長1分の動画の生成AI「Sora」発表 一般公開はせず

OpenAIは、テキストプロンプトから最長1分の動画を生成するAIモデル「Sora」を発表した。「AGIを達成するための重要なマイルストーンになる」としている。 キャラクター画像をアニメに 中国アリババなど「Animate Anyone」開発 ボーンの動きを反映

キャラクター画像をアニメに 中国アリババなど「Animate Anyone」開発 ボーンの動きを反映

中国のAlibaba Groupなどに所属する研究者らは、画像内のキャラクターや人物をアニメーション化する手法を提案した研究報告を発表した。 アリババなど中国各社からChatGPT対抗AI続々 “にわか”ではない開発の背景

アリババなど中国各社からChatGPT対抗AI続々 “にわか”ではない開発の背景

4月11日、中国アリババグループが自社開発の対話型AIを発表した。3月には中国バイドゥ、米Google、4月には米Amazonも参戦を表明し、中国では5月までに数社がリリース予定だ。「中国版ChatGPT」は数年前から開発されており、社会実装では中国が先行する可能性もある。 五輪選手の躍動、リアルタイムで3Dモデルに IntelとAlibabaが開発へ

五輪選手の躍動、リアルタイムで3Dモデルに IntelとAlibabaが開発へ

米Intelと中国Alibabaが、アスリートの動きを立体的にトラッキングする技術を共同開発へ。ビデオカメラが捉えた映像をAIが分析し、アスリートの3Dモデルを作成する。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PRアイティメディアからのお知らせ

SpecialPR

あなたにおすすめの記事PR