キャラクター画像をアニメに 中国アリババなど「Animate Anyone」開発 ボーンの動きを反映:Innovative Tech

Innovative Tech:

このコーナーでは、2014年から先端テクノロジーの研究を論文単位で記事にしているWebメディア「Seamless」(シームレス)を主宰する山下裕毅氏が執筆。新規性の高い科学論文を山下氏がピックアップし、解説する。

Twitter: @shiropen2

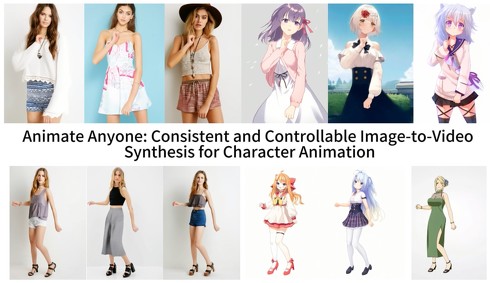

中国のAlibaba Groupなどに所属する研究者らが発表した論文「Animate Anyone: Consistent and Controllable Image-to-Video Synthesis for Character Animation」は、画像内のキャラクターや人物をアニメーション化する手法を提案した研究報告である。

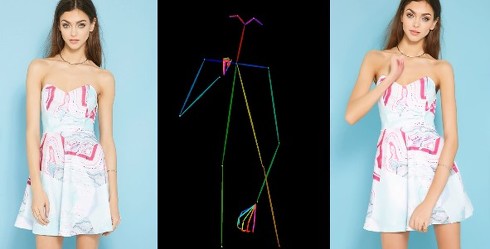

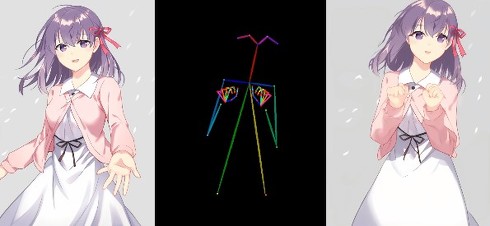

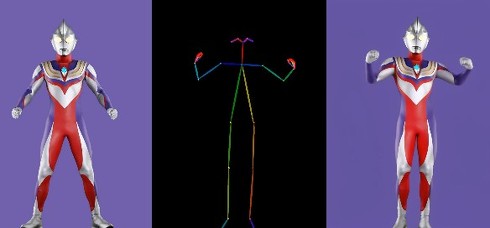

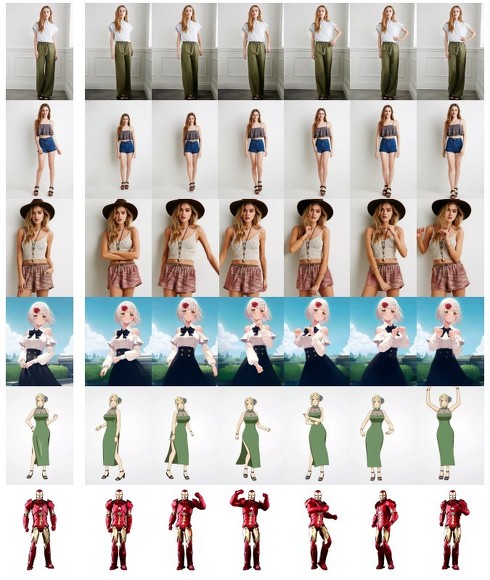

「Animate Anyone」という新モデルは、1枚の画像とポーズシーケンス(骨格動画)を入力にして、ポーズシーケンスの動きに応じて画像内のキャラクターを滑らかに動かすモーションアニメーションを生成する。動いた際のなびく服や髪の毛も再現される。この手法は従来の手法に比べ、外観の一貫性を維持し、フレーム間のチラつきを軽減している。

モデルは、Stable Diffusion(SD)のネットワーク設計と事前訓練された重みを継承し、Denoising UNetを複数フレームの入力に対応できるように変更している。

この方法には3つの重要なコンポーネントが組み込まれている。参照画像からキャラクターの外観的特徴をエンコードする「ReferenceNet」。骨格動画からキャラクターの動きを制御するためのモーションデータをエンコードする「Pose Guider」。キャラクターの動きの連続性を確保するための時間的関係を補う「Temporal layer」。

ReferenceNetで抽出した特徴は、Spatial-Attentionを用いてDenoising UNetに統合される。これにより、Denoising UNetはReferenceNetと同じ特徴空間にある関連する特徴を選択的に学習できる。また、CLIP画像エンコーダーを使用したCross-Attentionにより、参照画像の意味的特徴も統合。Pose Guiderで処理したモーションデータは、Denoising UNetへの入力前に基礎となるノイズ情報に追加される。

Temporal Layerは、Denoising UNet内のSpatial-AttentionとCross-Attentionの後に組み込まれ、ビデオの各フレームがどのようにつながるかを理解するのに使われる。これにより、フレーム間の時間的一貫性を保った滑らかな動きを生成できる。

このモデルは、1枚の画像からその画像内のキャラクターをさまざまな動きに合わせてアニメーション化できる。仕上がりは高品質であり、リアルなキャラクターの細部を忠実に再現し、大きな動きのシーンでも参照画像との一貫性を維持する。また、フレーム間で時間的な連続性を実現している。

このモデルは、キャラクターの骨格の動きだけでなく、動いた際の服や髪の動きも高品質に生成する。UBCファッションビデオデータセットとTikTokデータセットという2つのビデオ合成ベンチマークでの評価結果は、この手法が最先端の成果を達成していることを示している。

Source and Image Credits: Hu, Li, et al. “Animate Anyone: Consistent and Controllable Image-to-Video Synthesis for Character Animation.” arXiv preprint arXiv:2311.17117(2023).

関連記事

オタ恋のカップル、動く 公式が“AI動画”投稿 「今後は動画広告も展開していく」

オタ恋のカップル、動く 公式が“AI動画”投稿 「今後は動画広告も展開していく」

恋愛マッチングアプリ「オタ恋」が掲載した“AI動画”が話題だ。これまで「絵面が濃いオタクカップル」のAI画像を広告に起用しSNS上で人気を得ていたが、今回投稿した動画ではそれらのカップルが動く様子を確認できる。 Stability AI、テキスト→動画の「Stable Video Diffusion」をGitHubで公開

Stability AI、テキスト→動画の「Stable Video Diffusion」をGitHubで公開

Stability AIは、テキストから動画を生成するAIモデル「Stable Video Diffusion」のリサーチプレビュー版をGitHubで公開した。テキスト入力のためのWebツールを入手するにはウェイティングリストに登録する必要がある。 Meta、独自の動画生成AI「Emu Video」と編集AI「Emu Edit」を紹介

Meta、独自の動画生成AI「Emu Video」と編集AI「Emu Edit」を紹介

Metaは、9月に発表した独自の画像生成基盤モデル「Emu」に基づく2つのモデルを発表した。4秒のリアルな動画を生成できる「Emu Video」とプロンプトで画像を編集する「Emu Edit」だ。 長時間の動画から、短縮動画と説明文をAIで自動生成 ドラレコ解析に……NECが開発

長時間の動画から、短縮動画と説明文をAIで自動生成 ドラレコ解析に……NECが開発

映像認識AIとLLMを組み合わせ、長時間の動画から、目的に応じた短縮動画と説明文を自動生成する技術を、世界で初めて開発したとNECが発表した。 「アニメーションのレベル高すぎ」──“原神”のmiHoYo新作ゲームが「変態クオリティー」と話題

「アニメーションのレベル高すぎ」──“原神”のmiHoYo新作ゲームが「変態クオリティー」と話題

「原神」などを手掛ける中国miHoYoの新作ゲームが話題だ。11月24日からクローズドβテストを実施しており、プレイヤーたちが投稿するプレイ映像が注目を浴びている。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR