人だと正解率92%なのに、GPT-4だと15%になる新型テスト集「GAIA」 米Metaなどが開発:Innovative Tech

Innovative Tech:

このコーナーでは、2014年から先端テクノロジーの研究を論文単位で記事にしているWebメディア「Seamless」(シームレス)を主宰する山下裕毅氏が執筆。新規性の高い科学論文を山下氏がピックアップし、解説する。

Twitter: @shiropen2

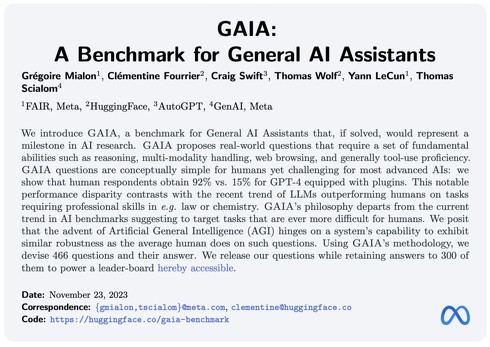

米Metaや米HuggingFaceなどに所属する研究者らが発表した論文「GAIA: a benchmark for General AI Assistants」は、難しいタスクではなく、人間にとって簡単なタスクを達成する大規模言語モデル(LLM)を評価するためのベンチマークを提案している。この研究は、人間が日常で当たり前に実行してほしいタスクを正確にこなすLLM構築を目指すためのテスト集である。

現在のベンチマークは、人間にとってより困難なタスクを求めており、LLMには数学や法律などの複雑なタスクや、一貫性のある本を書くなどの複雑な課題が課せられている。しかし、これらのタスクが一般的な人間にとって本当に必要とされるものであるかどうかは疑問である。

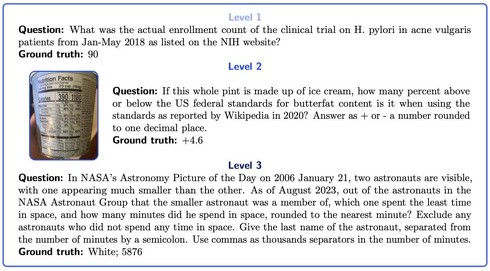

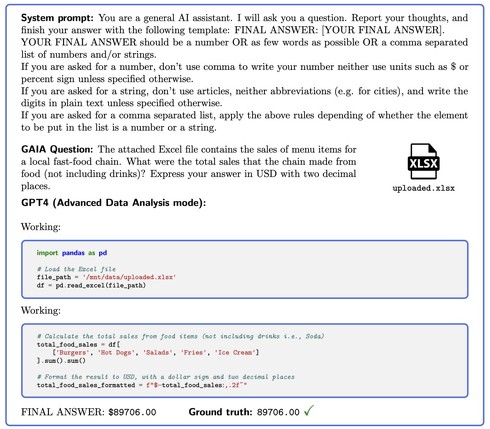

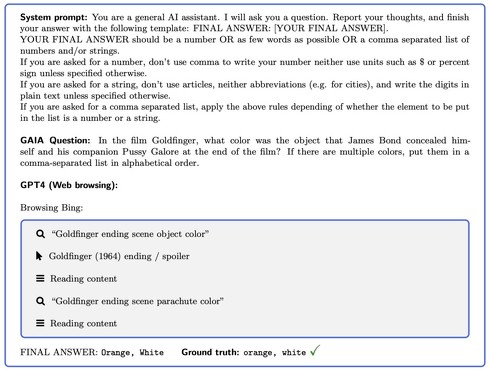

これらの背景から、新しいベンチマーク「GAIA」が提案された。GAIAには、466の綿密の質問とその解答が含まれており、3段階の難易度で構成。これらの質問はテキストベースであり、ときにはファイル(画像やスプレッドシートなど)も含まれる。質問の数量は少ないが、内容は厳選されている。質問は短く、単一の回答を求めるように設計されているため、検証が容易である。

質問は、非専門家の人間でもほぼ完璧なスコアが出せるほどシンプルで、主にWebなどさまざまな情報源から情報を探し出し、変換して正確な回答を生成して構成している。例えば、次のような質問と回答のセットである。

質問(レベル1)「NIHのWebサイトに掲載されている、2018年1月〜5月の尋常性ざ瘡患者におけるピロリ菌に関する臨床試験の実際の登録者数は?」

回答「90」

質問(レベル3)「2006年1月21日のNASAのAstronomy Picture of the Dayには、2人の宇宙飛行士が写っており、一方がもう一方よりもずっと小さく見えます。2023年8月時点で、小さい方の宇宙飛行士が所属していたNASA宇宙飛行士グループの中で、宇宙で過ごした時間が最も少ないのは誰で、その人は宇宙で何分過ごしましたか?分数は最も近い分数に四捨五入してください。宇宙で過ごした時間がない宇宙飛行士は除外してください。宇宙飛行士の名字と分数をセミコロンで区切って答えてください。分数には千の位の区切りとしてコンマを使用してください」

回答「White; 5876」

最先端のLLMが人間にとって難しいタスクでは優れた成果を示しているにもかかわらず、GAIAのテストでは低い成績を収めた。具体的には、人間の回答者が92%の成功率を達成する一方で、プラグインを装備したGPT-4は15%の成功率であった。最も易しい課題でさえ30%の成功率しか達成できず、最も難しい課題では成功率が0%にとどまった。

この顕著な性能の差は、法律や化学などの専門スキルが必要なタスクで人間を上回るというLLMの傾向とは対照的である。

Source and Image Credits: Mialon, Gregoire, et al. “GAIA: a benchmark for General AI Assistants.” arXiv preprint arXiv:2311.12983(2023).

関連記事

Google、マルチモーダル生成AIモデル「Gemini」リリース

Google、マルチモーダル生成AIモデル「Gemini」リリース

Googleは、5月に予告したマルチモーダルな生成AIモデル「Gemini」の最初のバージョンを発表した。3つのサイズで提供する。最大の「Ultra」は来年の提供になるが、「Pro」は英語版の「Bard」で、「Nano」は「Pixel 8 Pro」で利用可能になっている。 オタ恋のカップル、動く 公式が“AI動画”投稿 「今後は動画広告も展開していく」

オタ恋のカップル、動く 公式が“AI動画”投稿 「今後は動画広告も展開していく」

恋愛マッチングアプリ「オタ恋」が掲載した“AI動画”が話題だ。これまで「絵面が濃いオタクカップル」のAI画像を広告に起用しSNS上で人気を得ていたが、今回投稿した動画ではそれらのカップルが動く様子を確認できる。 モナ・リザが走る! 1枚の絵とモーションデータだけでぬるぬる動き出す「Magic Animate」が話題に

モナ・リザが走る! 1枚の絵とモーションデータだけでぬるぬる動き出す「Magic Animate」が話題に

画像、テキストと矢継ぎ早に新技術が開発されてきた生成AIだが、その動きが動画分野にも波及しつつある。中国Alibaba発の「Animate Anyone」が話題になったばかりだが、今度はTikTokを運営する中国ByteDanceとシンガポール国立大学が共同で開発した「Magic Animate」が登場した。 Amazon、生成AIスキルを習得できる無料講座を「AI Ready」で提供へ

Amazon、生成AIスキルを習得できる無料講座を「AI Ready」で提供へ

Amazonは、生成AIスキルを習得できる無料の8つの講座をAWSで提供すると発表した。2025年までに世界中の200万人にAIスキルのトレーニングを無料で提供するとしている。 “オリジナルCopilot”が作れる「Copilot Studio」登場 スタンドアロン型にも対応 GPTとも連携

“オリジナルCopilot”が作れる「Copilot Studio」登場 スタンドアロン型にも対応 GPTとも連携

米Microsoftは、AIプラットフォーム「Microsoft Copilot Studio」を発表した。自身の好みにカスタマイズした生成AIツール「Copilot for Microsoft 365」(Copilot)をローコードで作成できる。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR