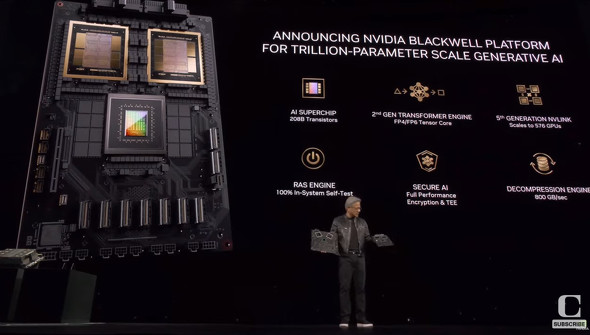

NVIDIA、GPUプラットフォーム「Blackwell」発表 「兆パラメータ規模のAIモデル実現」

米NVIDIAは3月18日(現地時間)、5年ぶりに開催の年次カンファレンス「GTC 2024」で、AI向けプラットフォーム「Blackwell」を発表した。“兆パラメータでリアルタイム生成AIを構築および実行できるようになる”としている。

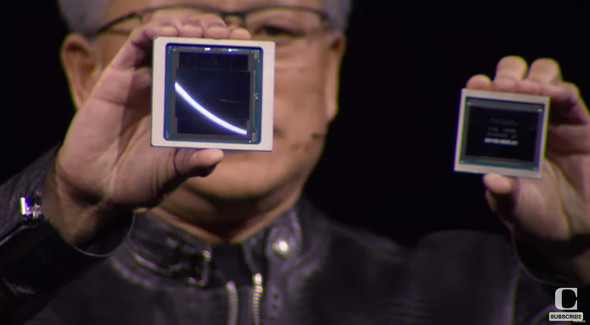

ジェンスン・ファンCEOは基調講演で、Blackwellは、ゲーム理論で知られる米国の数学者、デビッド・ブラックウェル氏(リンク先はWikipedia)にちなんだと語った。

プラットフォームに搭載する「GB200 Grace Blackwell Superchip」は、新GPU「B200」(2080億個のトランジスタを搭載し、現行の「H100」と比較して、AI向けの作業で5倍の処理能力を発揮するGPU)を2基と1基のGrace CPUを組み合わせたもの。

NVIDIAによると、1兆8000億パラメータのAIモデルをトレーニングするには、Hopper GPUでは8000個のGPUで15メガワットの電力が必要だったが、新スーパーチップであれば2000個で可能で、消費電力は4メガワットで済むという。

NVIDIAはGB200を、水冷ラックスケールシステム「NVL72」などで提供する。これは第5世代NVLinkで接続された72個のBlackwel GPUと36個のGrace CPUを含む36個のGrace Blackwellスーパーチップを搭載する。

Blackwellプラットフォームの製品は、今年後半からパートナーから提供される予定。Google、Meta、Microsoft、OpenAI、Oracle、Tesla、xAI、Amazon傘下のAWS、DellなどがBlackwellを採用する見込みという。

プレスリリースには、OpenAIのサム・アルトマンCEOやTeslaとxAIのCEOでもあるイーロン・マスク氏からのコメントが紹介されている。

Google Cloud、AWS、Microsoft、Oracleが今年後半にBlackwell搭載インスタンスのホストを開始する予定。

GB200は、NVIDIA DGX Cloudでも利用可能になる見込みだ。

関連記事

NVIDIA、4608基のH100GPUを搭載したデータセンター規模のAIスパコン「Eos」を披露

NVIDIA、4608基のH100GPUを搭載したデータセンター規模のAIスパコン「Eos」を披露

米NVIDIAは同社が独自に開発したデータセンター規模のスーパーコンピュータ「Eos」をブログと動画で披露しました。 NVIDIA、AI関連好調で売上高が初の200億ドル突破

NVIDIA、AI関連好調で売上高が初の200億ドル突破

半導体大手NVIDIAの2023年11月〜2024年1月の決算は、売上高は前年同期比265%増の221億300万ドル、純利益は769%増の122億8500万ドルだった。 「できるだけ多くのGPU提供」を要請 岸田首相、NVIDIAフアンCEOと面会

「できるだけ多くのGPU提供」を要請 岸田首相、NVIDIAフアンCEOと面会

米半導体大手NVIDIAのジェンスン・フアン最高経営責任者(CEO)は12月4日、岸田文雄首相と面会し、首相から日本国内での「できるだけ多くの」GPUの提供を要請されたと明らかにした。フアン氏は「できる限り提供できるようにしていきたい」と答えた。面会後、官邸で記者団に述べた。 NVIDIAのファンCEOがCOMPUTEXで披露した生成AI関連製品まとめ

NVIDIAのファンCEOがCOMPUTEXで披露した生成AI関連製品まとめ

NVIDIAは「COMPUTEX 2023」で、多数の生成AI関連製品を発表した。大容量AIスパコン「DGX GH200」やゲームキャラに命を吹き込む「Avatar Cloud Engine」など、ジェンスン・ファンCEOが発表した主な製品をまとめてみた。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR