一度は諦めた「ARグラス」を再始動させるGoogle、今度は“引けない“理由とは?(1/2 ページ)

Googleが再びスマートグラスに参入する。先日のGoogle I/O 2025では、新プラットフォームである「Android XR」を使い、同社のAIであるGeminiと連携するグラス型デバイスを発表した。

このデバイスの狙いはどこにあり、2012年に発表した「Google Glass」とどこが違うのだろうか。

Android XRとはなにか

Google I/Oで公開されたデバイスは、前述のように「Android XR」というプラットフォームの上で動いている。名前でわかるように、基盤となるのはAndroidであり、そこに、仮想現実・拡張現実(XR)向けの機能と最適化したGoogle純正アプリ、Google Playストアなどを加えたものと考えていい。

Metaなどの他社のXR機器の多くも、Androidの核となるオープンソース版である「Android Open Source Project(AOSP)」をベースにしている。だが、その上で動くXR向けのUIや、アプリケーションストアなどのエコシステムは独自のものだ。

そして、他とAndroid XRの大きな違いが「複数の使い道に対応し、アプリ開発に一貫性がある」ことだ。

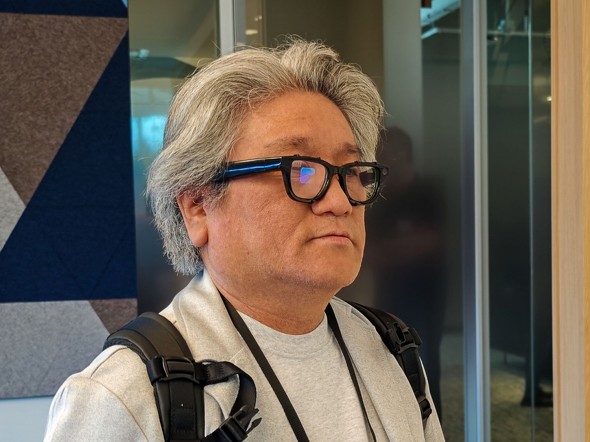

Google I/Oで筆者は2つのAndroid XR対応機器を体験した。

1つは「Project Moohan」。Googleが韓国Samsung Electronics、米Qulacommとともに開発中のデバイスで、年末までには発売を予定している(日本での発売は未定)。

こちらはMeta Quest 3やApple Vision Proに近い、他の機器と接続せずに使える単独のデバイス。ビデオシースルー型のMixed Realityであり、使い勝手のイメージはVision Proに近い、かなりハイエンドなデバイスだ。画質もかなり高く、YouTubeやGoogleマップなどを非常に没入感のある形で楽しめる。GoogleによるVision Pro対抗、といってもいいだろう。

もう1つがスマートグラス型のプロトタイプだ。こちらはGoogle I/Oの基調講演でデモされたものとほぼ同じもので、Googleの内製による開発機材。別途スマートフォンを用意し、そちらとワイヤレス接続して使う。カメラやマイクで周囲の情報を把握し、情報・画像を表示する機能はあるものの、画像は常に視野の一部に固定される。XRというよりも「情報表示型デバイス」といった印象が強い。

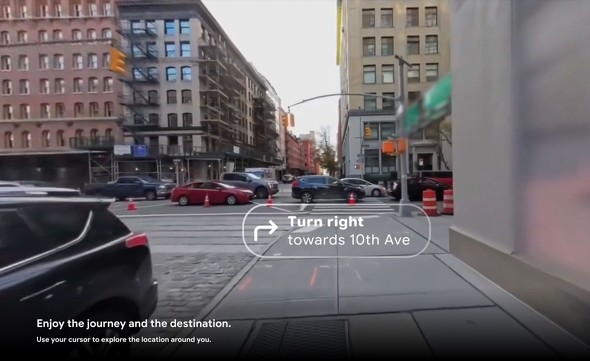

例えばGoogleマップと連動し、「次にどこをどちらに曲がるべきか」をチェックしつつ歩くこともできる。以下の画像はAndroid XRの公式ページからの抜粋だが、解像度こそ劣るものの、実際にほぼこの通りの表示が体験できた。

Googleはこれらのデバイスを、Android XRという1つのプラットフォームでカバーする。Googleはアプリ開発者のエコシステムを重視し、一貫したプラットフォームを使って、できれば一度の、1つのアプリ開発でハイエンドからスマートグラスまで対応することを目指しているわけだ

他社は現状、ハイエンドなものとスマートグラス的なアプローチを別のプラットフォームに分ける傾向がある。UIや体験、ハードウエア用件が大きく異なるので、分ける理由も理解できる。

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR