“大は小を兼ねない”生成AI 注目集める「小規模言語モデル」(SLM) そのメリットとは?:小林啓倫のエマージング・テクノロジー論考(2/3 ページ)

LLMの場合、それを動かすためには大きな計算リソースが不可欠だ。高性能のGPUと大きなメモリ、ストレージが必要になるため、ほとんどのLLMは、クラウド環境上で動いている。

スマートフォンアプリからChatGPTを使うとき、別に手元のスマホ上にGPT-4などのモデルがインストールされているわけではない。あくまでアプリはクラウドに接続するためのインタフェースにすぎず、ユーザーが入力したプロンプトやアップロードしたファイル類は、クラウド環境上にあるLLMで処理されている。

しかしSLMは小規模であるが故に、より限定的な環境で実行可能で、オフラインでも言語モデルのメリットを享受できる。これは言語モデルの実行がローカル環境でしかできない、あるいはローカル環境に留めておいた方が望ましいユースケースにおいて、大きな魅力となる。

第2に、SLMではモデルの規模が小さいが故に、推論がシンプルなものになる。その結果、レイテンシ(LLMの場合、ユーザーがプロンプトを入力してから回答が返ってくるまでの待ち時間)が低減され、モデルが予期せぬ挙動をするリスクも減る。

LLMは優秀だが、大規模なだけに「考えすぎ」てしまい、回答が返って来るまでに長い時間がかかることがある。それは医療や災害対応など、1分1秒を争う場面では致命的だ。またパラメータ数が大きいということは、それだけモデルが取り得る行動の幅が大きくて複雑という意味であり、いくらテストを重ねても脆弱性が残ってしまう恐れがある。

実際に主要なLLMについては、毎日のように、その新たな脆弱性が発見されたというニュースが流れている。しかしSLMであれば、多少の優秀さは犠牲になるかもしれないが、よりレスポンスが早く、信頼性の高いアプリケーションを構築できるというわけだ。

第3に、SLMは小規模であるために、特定のタスクやドメイン(専門領域)に特化したファインチューニングを実施しやすい。

LLMは大規模であるが故に、その開発やファインチューニングにも大きな計算リソースと学習データが必要となる。またパラメータ数が大きい、つまり複雑な処理ができる故に、パラメータをどう調整すれば意図したチューニングを行えるかという判断が難しくなる。

これらの問題がSLMでは軽減され(あくまでLLMと比較してだが)、特定の目的に合致したモデルを実現しやすい。つまりSLMは、限定的なユースケースに対応する生成AIアプリケーションを開発しようとしたとき、LLMより優れた選択肢になる可能性があるというわけだ。

もちろんLLMの汎用性も大きな魅力であり、幅広いテーマに対して、正確で複雑な回答が求められるケースもある。しかしいま実現しようとしているのが「寝るときだけに使う枕が欲しい」だけなら、巨大な長持は必要ないのだ。

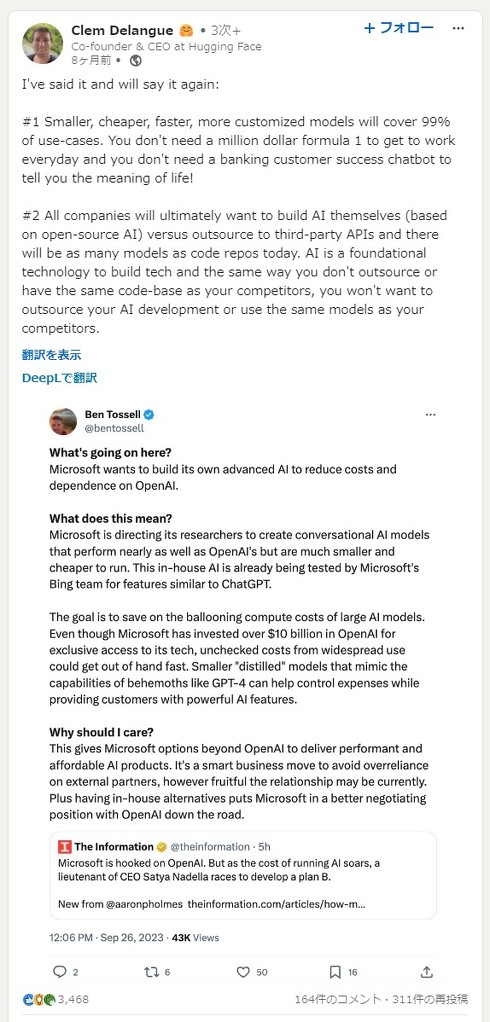

興味深いことに、AI開発・実行環境を提供する米Hugging Faceのクレマン・ドランジュCEOは、LinkedIn上に投稿した記事の中で「より小さく、より安く、より速く、よりカスタマイズされたモデルが、ユースケースの99%をカバーする。毎日の通勤に100万ドルのF1カーは必要ないし、銀行の顧客向けチャットbotが人生の意味を教えてくれる必要もない」と指摘している。

それでは具体的に、SLMに最適なユースケースとして、どのようなものが考えられているのだろうか?

SLMに期待されるユースケース

まず挙げられるのが、医療の現場で使用されるチャットbotへの応用だ。

言うまでもなく、医療分野では高度な専門用語が用いられ、それを正しく理解しなければ患者の健康状態に影響を及ぼす。またそこでやりとりされる情報は極めて機密性が高く、外部に漏らすことは許されない。さらに何らかの質問に対する回答を得るまでにかかる時間が、患者の生死を分けてしまう恐れがある。

このような環境では、先ほど整理したSLMの3つのメリット全てが有効に機能するだろう。比較的小規模な学習データで調整してやることで、高度な医療用語を理解し、誤作動も少ないモデルが手に入る。それに基づいて構築したアプリケーションは、外部にデータが出て行かないローカルな環境で動き、しかも回答をすぐに返してくれる。まさにSLMにうってつけのユースケースだ。

Copyright © ITmedia, Inc. All Rights Reserved.