米Appleの独自AI「Apple Intelligence」の技術詳細 基盤モデルや学習データなどを解説:Innovative Tech(AI+)(2/3 ページ)

iPhone 15 Proでは“30トークン/秒”を生成

Apple AIの高い性能を支えるために、デバイス上とプライベートクラウドでの速度と効率を最適化する技術を多数取り入れている。

高速推論のためのグループ化されたクエリアテンションや、メモリ使用量と推論コストを削減するための入力と出力で共通語彙(ごい)を使用している。この語彙リストは、重複なくマッピングされており、オンデバイスモデルでは49Kの語彙サイズ、サーバモデルでは追加の言語とテクニカルトークンを含む100Kの語彙サイズを使っている。

オンデバイスでの推論では、必要なメモリや電力、パフォーマンス要件を満たすために、ビット数を減らす最適化手法を利用。LoRAを組み合わせて、2ビットと4ビットを混合した構成戦略を採用した新しいフレームワークを開発し、非圧縮モデルと同等の精度を維持しつつ、データ量を削減した。

また、独自開発した「Talaria」というツールを使用して、各操作に最適なビットレートを選択し、効果的に最適化している。さらに、データの量子化を利用し、ニューラルエンジンで効率的にKVキャッシュを更新する方法も開発した。

こうした最適化により、AppleはiPhone 15 Proにおいて、わずか0.6ミリ秒という遅延で最初のトークンを生成し、1秒間に30トークンを出力する性能を実現。これは、単語の予測を先読みするような考えられる最適化技術を使う前の数字である。

さまざまなユーザーの使い方に合わせる適応技術

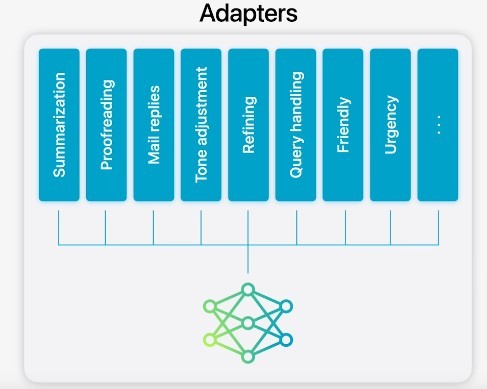

Apple AIの重要な特徴の1つにモデルの適応がある。これは汎用的な基盤モデルを、ユーザーの多様なニーズに合わせて動的に最適化する仕組みだ。アダプターと呼ばれる小さなニューラルネットワークモジュールを中心に、基盤モデルの重みを変更することなく、さまざまな層に接続可能でタスクに特化した微調整を行う。

アダプターのパラメータ値は16ビット表現を採用しており、約30億パラメータを有するオンデバイスモデルにおいて、ランク16のアダプターのパラメータは通常数十Mバイト程度で済む。アダプターモデルは動的にロード可能で、一時的にメモリ上にキャッシュされ、必要に応じて入れ替えられる。

これにより、基盤モデルは、メモリを効率的に管理しつつ、オペレーティングシステムの応答性を損なうことなく、その場で目前のタスクに特化することが可能となる。

さらに、アダプターのトレーニングを円滑に行うため、基盤モデルやトレーニングデータが更新された際に、アダプターを迅速に再トレーニング、テスト、デプロイできる効率的なインフラストラクチャも構築している。

Copyright © ITmedia, Inc. All Rights Reserved.