米Appleの独自AI「Apple Intelligence」の技術詳細 基盤モデルや学習データなどを解説:Innovative Tech(AI+)(3/3 ページ)

機械ではなく“人間”がモデルの精度を評価

Appleは、モデルのベンチマークには人間による評価を用いている。これは、機械的な指標よりも、ユーザーの満足度により強く相関すると考えられるためだ。評価は、汎用的な基盤モデルと、タスク特化型のアダプターの両方で行われている。

例えば、要約タスクの評価では、実際の製品を想定した多様な入力データを用意し、アダプター適用後のモデルが生成した要約を人間が採点。その際、要約の品質だけでなく、重要な情報の欠落がないかなども確認している。その結果、要約のアダプターモデルは、ベースラインモデルよりも高品質な要約を生成することを確認した。

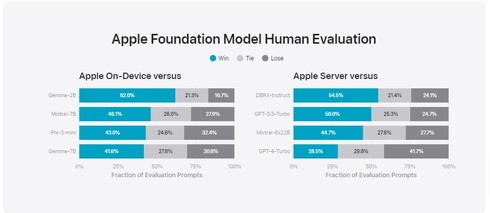

続けて、オンデバイスモデルとサーバベースモデルの一般的な能力も評価する。一般的なモデルの能力をテストするために、プロンプトの包括的な評価セット(質問応答、コーディング、数学的推論、書き換えなど)を使用する。

提案モデルをオープンソースモデル(Phi-3、Gemma、Mistral、DBRX)や同等サイズの商用モデル(GPT-3.5-Turbo、GPT-4-Turbo)と比較した結果、提案モデルは、多くの比較可能な競合モデルよりも人間の評価者に好まれた。

具体的には、約30億のパラメータを持つオンデバイスモデルが、Phi-3-mini、Mistral-7B、Gemma-7Bを含む大規模モデルを上回り、サーバモデルではDBRX-Instruct、Mixtral-8x22B、GPT-3.5-Turboと比較して好成績を収めた。

また、有害なコンテンツ、機密トピック、事実性に関するモデルのパフォーマンスをテストするための評価セットでも、オンデバイスモデルとサーバモデルの両方で高い堅牢性を示し、オープンソースモデルや商用モデルよりも低い違反率を達成した。

さらに、Instruction-Following Eval(IFEval)ベンチマークを使用して、同等のサイズのモデルと命令に従う能力を比較した結果、オンデバイスモデルとサーバモデルの両方が、同等のサイズのオープンソースモデルや商用モデルよりも詳細な命令に従うことを示した。

Appleは近日中に、さらなる詳細なモデルセットを共有する予定としている。

関連記事

米Appleの独自AI「Apple Intelligence」 iPhone・iPad・Macで動作 各純正アプリに文章や画像生成機能がビルトイン

米Appleの独自AI「Apple Intelligence」 iPhone・iPad・Macで動作 各純正アプリに文章や画像生成機能がビルトイン

米Appleは、独自AI「Apple Intelligence」を発表した。iPhoneやiPad、Macで、AIを利用した機能を使えるようになる。まずは秋ごろに米国で、Apple AIを搭載したiOS 18、iPadOS 18、macOS Sequoiaのβ版を提供する予定。 iPhoneにChatGPTが統合 最新モデル「GPT-4o」で応答 OpenAIアルトマンCEO「きっと気に入ってもらえる」

iPhoneにChatGPTが統合 最新モデル「GPT-4o」で応答 OpenAIアルトマンCEO「きっと気に入ってもらえる」

米Appleは、iPhoneなどの製品に米OpenAIのAIチャット「ChatGPT」を統合すると発表した。 Appleシリコンで稼働するApple純正クラウド「Private Cloud Compute」登場 独自AI「Apple Intelligence」の複雑な計算に

Appleシリコンで稼働するApple純正クラウド「Private Cloud Compute」登場 独自AI「Apple Intelligence」の複雑な計算に

米Appleが、同社純正の生成AIサービス「Apple Intelligence」(以下、Apple AI)のクラウド側実行基盤として「Private Cloud Compute」を発表した。サーバはAppleシリコンで稼働する。 Apple Vision Pro、日本で6月28日に発売へ 59万9800円から

Apple Vision Pro、日本で6月28日に発売へ 59万9800円から

米Appleは6月10日(現地時間)、開発者向けイベント「WWDC24」において、同社のMRヘッドセット「Apple Vision Pro」を日本を含む8カ国で発売すると発表した。価格は59万9800円から。 「iOS 18」登場、対応機種は? Face IDでアプリをロック、ホーム画面はカスタム自在に 新AI機能も

「iOS 18」登場、対応機種は? Face IDでアプリをロック、ホーム画面はカスタム自在に 新AI機能も

米AppleはiOSの最新版「iOS 18」を発表した。無料のソフトウェアアップデートとして2024年秋に提供開始予定で、対象の機種は18年発売のiPhone Xs以降。独自のAI機能「Apple Intelligence」を搭載する他、Face IDを使ったアプリロックなどが可能になる。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.