Appleが作ったAI 「Apple Intelligence」とは結局何なのか、改めておさらいしてみる(2/4 ページ)

オンデバイスで動く意味

Apple Intelligenceは、あくまでユーザーの日々の行動をアシストする目的で作られている。例えば、友達からiMessage上でパブに誘われたとしよう。「Hey Siri ! そのパブって家からどのぐらいかかるの?」と聞くと、Apple Intelligenceは、文脈から「そのパブ」が、友達と話していたパブであること、「家」が自分の自宅であることを察知し、ルートを案内する。

Apple Intelligenceが扱うデータは、個人の行動や、デバイスに入ってる写真、iMessageでのチャットのやりとりや、メールのやりとりなど。ユーザー情報の塊であるスマートフォン内のデータをもとに、Apple Intelligenceは「パーソナル」を理解しているというわけだ。

処理能力に優れた巨大なサーバベースの生成AIと、Apple Intelligenceを比較するのはあまり意味がない。多くの企業が絶対性能で競争する中、その技術をユーザー体験に全振りするのがAppleの常とう手段だ。RioなどMP3プレーヤー全盛期のiPodだったり、ボタンだらけの携帯電話全盛だったころのiPhoneだったり、絶対的な数値よりもユーザーに寄り添う、Appleならではの行動規範に従ったといえる。

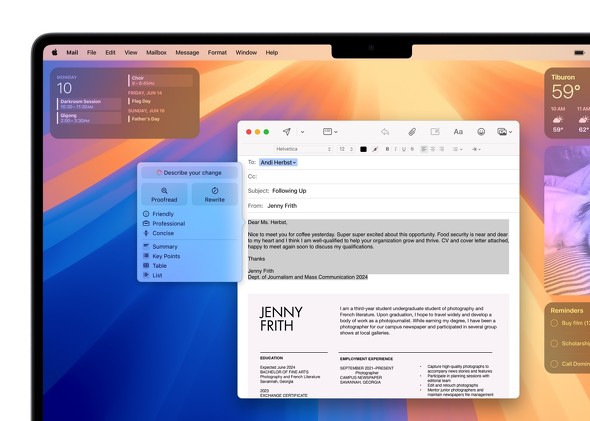

基調講演を注意深く見ると分かるように、Appleは現時点ではApple Intelligenceの機能をいくつかのテーマに絞っている。例えば、言語モデルを生かした記述ツールや、iPhoneで撮ったりMacにため込んだりした写真の解析など、Siriによる文脈理解とデバイスの制御などに限っている。

プライバシー配慮のアピールが生きてきた

Appleは長年「プライバシー」をしつこく謳ってきた。ユーザーデータも同社の「Secure Enclave」(メインチップとは別に用意されたセキュリティサブシステム)などの仕組みを使って管理している。もちろん他社との競争軸で「プライバシーが大切だ」と言ってる側面もあるかもしれない。

GAFAの他3社は、広告もしくは流通のビジネスモデルなので、どうしてもユーザーの情報をメシの種にせざるを得ない。だがAppleは、iPhoneやMacという製品の販売が主軸なので、顧客のデータをビジネスの糧にする必要がない。そういう立ち位置が、プライバシーを守ったまま「パーソナルなインテリジェンス」を構築できる背景にある。生成AIの学習にユーザーデータを使っていないとも公言している。

長年Appleデバイスを使っていると、データの蓄積はすごいことになる。筆者の場合、写真アプリには30万枚もの写真が入っているし、位置情報の記録もあるはずだ。Apple Watchから得たヘルスケア情報には、15年に使い始めてから筆者の心臓が何回鼓動して、何歩歩いたかの記録まであるだろう。もちろん、たくさんのドキュメントが保存されているし、メール、メッセージなどのやりとりも入っている。

これらのデータからどの程度を読み込むかは公開されていないが、Apple Intelligenceはこうした情報を解析してセマンティック(意味論的)インデックスを構築し、ユーザー行動を理解している。“自分に関する情報だらけ”のiPhone/iPad/Macだからこそ、デバイス上で単独処理できるオンデバイスAIにこだわったといえる。

Copyright © ITmedia, Inc. All Rights Reserved.