Appleが作ったAI 「Apple Intelligence」とは結局何なのか、改めておさらいしてみる(3/4 ページ)

“全部オンデバイス”というワケではない

多くの生成AIモデルは、インターネットにあるテキストや、画像を学習ソースの1つとして使っており、いかに大量のデータを学習しているかが生成AIの性能を決める1つのファクターなのだが、このあたりの事情も少し違う。

Apple Intelligenceは、テキストと画像ともにSafariのWebサーチインデックスを通して学習を行っている。しかも、大量に読ませるのではなく、質の高い内容のものを厳選しているという。画像に関してはこれとは別に、ストックフォト企業からライセンスを取得した画像も使っており、Appleいわく「権利上クリアになっているデータ」を学習しているとする。

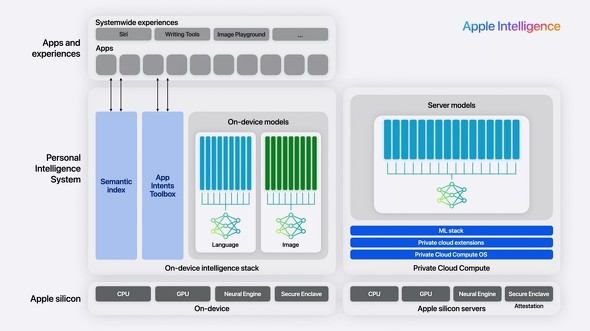

また、オンデバイスだけで処理が完結するわけではない。人間によるベンチマーク評価で、倍以上のパラメーターを持つLLM(Mistral-7BやGemma-7Bなど)を上回ったとはいえ、30億パラメーターのAIモデルの性能には限界がある。そこで活用されるのが「Private Cloud Compute」だ。

これは、デバイス内だけで処理できないデータをクラウドで処理する仕組み。先ほどオンデバイスAIのメリットを語ったばかりで「言っていることが違うじゃないか」と思われるかもしれないが、Private Cloud Computeは特殊なAppleオリジナルのクラウドだ。

Private Cloud Computeは、大量のApple Siliconで構築されたクラウドサーバで、オンデバイスAIで処理しきれなかったデータを暗号化して転送し、Appleでもデータには触れられない構造のまま処理する。データをクラウドで処理するかどうかはApple Intelligenceが判断し、ユーザーはどちらで処理されているのかを意識することはないという。

同クラウドは、Private Cloud Compute OSと、Private Cloud extension、ML stackで構築されており、その上でApple Intelligenceのクラウドモデルが動作している。このApple Siliconサーバは大きなメモリを持つが、ストレージは持っておらず、処理したあとはデータを保持しない仕組みになっているという。

Apple Intelligenceの要求スペックが高い理由

なお、Apple IntelligenceはApple M1以降、A17 PRO以降をサポートしている。A17 PROといえば、iPhone15 Pro/Pro Maxのみで使われている最新チップで、iPhoen 15や1世代前のiPhone 14 Pro(ともにA16 Bionic)ですら動作しない。筆者の単なる想像だが、Apple IntelligenceがA17 PROとMチップでしか使えないのは、Private Cloud Computeの処理能力の都合もあるのではないだろうか。

データサーバの処理能力向上には物理的な投資が必要だが、全く新しい構造のサーバゆえ、全世界のAppleユーザーをカバーできるほどの処理能力をすでに構築できているとは考えにくい。特にMacとiPhoneではユーザーベースの規模は桁違いで、年間2億台以上といわれるiPhoneの販売台数に対応するサーバを作るというのは、いかにAppleといえども容易ではない。そこで、機種を限定して処理能力を絞るために、iPhoneのチップセットはA17 PROのみとしたのだろう。

そもそも、Apple Intelligenceでできることを見るに、このAIモデルをオンデバイス動作させるには強力なNPUが必要となる。これをクリアするのがApple M1やA17 PROだったのだろう(M1のNPU性能はA17 PROと同等といわれている)。メモリも、A16 Bionicを載せるiPhone 15/14 Proは6GBとされており、iPhone 15 ProやM1マシンに載っている8GBを下回る。デバイス側のNPU性能が足りないと、頻繁にPrivate Cloud Computeで処理させる必要があり、クラウドにより大きな負荷が掛かってしまうことは想像にたやすい。

つまり、NPU性能やメモリと、Private Cloud Computeのキャパシティー的に今の対応機種となったのだろう。この辺はAppleに問い合わせても答えてもらえないので、あくまでも仮説でしかないが。

Copyright © ITmedia, Inc. All Rights Reserved.