生成AIでコーディング効率化!→待っていたのは“失敗の日々” とあるITエンジニアとAIの試行錯誤の記録(3/3 ページ)

そこで行き着いたのが「エラーメッセージを読んでもらう」という方法だ。出力形式毎に専用のライブラリで検証させれば、検証結果としてエラーメッセージが返ってくる。それを生成AIに与えフィードバックしていくことで、失敗に対応するためのプロンプトやコードの量が減り、開発が楽になったという。

「これまでは僕はエラーメッセージは人間が読むものだと思っていた。その意味を理解して挙動を変えていくのは人間の特権だと思っていたため、AIに読み込ませるという発想には至らなかった」

最後になる3つ目の要因は「失敗が十分に減らない」ことだ。当初、山西さんは成功率8〜9割でなければ人間側の負荷が増えるため、生成AIによる効率化は実現できないと考えていた。しかし、生成AIを触っていく中で、実戦で育つ仕組みを作って徐々にAIが成長できる環境であれば実務に導入しても問題ないのでは、という考えに変わっていったという。

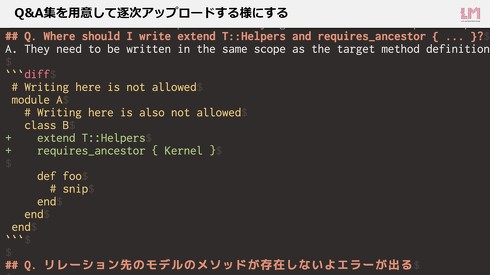

そこで山西さんは、生成AIが読み込めるQ&A集を作成。タスクに失敗するたびにこれを更新していくようにした。AIにこれを読み込ませることで出力が改善するケースも見られたという。これについて山西さんは「最初は手間がかかるが、いずれ成長して役に立ってくれるならアリだと感じた」と話す。

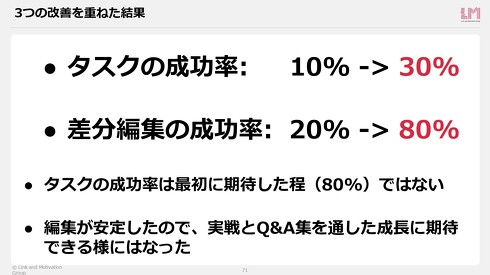

これらの試行錯誤を通した現状の成果として、型注釈のタスク全体の成功率は30%と説明。当初の目標である成功率8割はまだまだ達成できていないと正直に話す。しかし、小さく分解した差分編集のタスクの成功率は80%ほどとなり、希望を見いだせたという。

「生成AIは人間によく似ている」

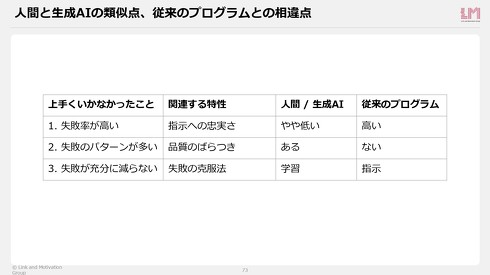

生成AIを業務導入に取り組んだ感想として「生成AIは人間によく似ているのではないか」と山西さんは総括する。例えば、前述の失敗要因の一つ「失敗率が高い」点は、“指示にどれだけ忠実か”ということに関連する。この点でいえば、従来のプログラムであれば指定した通りの振る舞いをするため、忠実度は高いといえる。

一方、生成AIは人の意図を必ずしも全てくみ取ってくれるわけではないため、忠実度は従来のプログラムほど高くないともいえる。とはいえ、この点は人も同様と山西さん。他にも、失敗の克服法が学習であることや、タスクの品質にばらつきがある点も人と生成AIの類似点ではと話す。

以上の気付きから、生成AIは従来のプログラムのように扱うのではなく、もっと人間らしく扱うことでさまざまな活路が開けるのではないかと、山西さんは提案する。

山西さん自身も、今後の生成AIの業務活用については「生成AIがチームメンバーならどうする?」という仮定で進めていく方針という。Q&A集への書き込みをAI自身が行える方法や、人間が作成しマージされたPRの差分データを学習データとして使い、AIをファインチューニングする「人の背中を見て学ぶ」に近い仕組みを構築。いずれは組織の一員として生成AIを迎えられる可能性もあるのではないかと、山西さんは期待を寄せている。

ITmedia デジタル戦略EXPO 2024夏 いよいよ開幕!

経営×IT×事業のコラボレーション――変革を進めるためのオンライン展示会

いよいよ開幕した「ITmedia デジタル戦略EXPO 2024 夏」。デジタル経営戦略やAI活用、業務効率化など10カテゴリーをラインアップし、ビジネスパーソンが"今"知りたいデジタル戦略の最前線を探求します。

関連記事

「RAGはそんなに簡単じゃない」──AIエンジニア主導でLLMを導入すると失敗に? 日本語特化のELYZA・曽根岡CEOに聞く、LLM開発&活用のいま

「RAGはそんなに簡単じゃない」──AIエンジニア主導でLLMを導入すると失敗に? 日本語特化のELYZA・曽根岡CEOに聞く、LLM開発&活用のいま

GPT-3.5と同水準の日本語特化型LLMを開発したELYZA。4月にはKDDIグループの傘下となり、注目を集めている。日本語性能トップクラスのLLMをどう作っているのか。KDDI傘下になったのはどんな狙いが? LLM活用でいま注目のポイントは? 気になることを、曽根岡侑也CEOにインタビューした。 生成AIのプロンプト投稿サイト「Prompt Style」 ソフトバンク系列企業が公開

生成AIのプロンプト投稿サイト「Prompt Style」 ソフトバンク系列企業が公開

ソフトバンクのグループ会社で出版事業を手掛けるツギクルは、生成AIのプロンプト投稿サイト「Prompt Style」を公開した。 LLMが別のLLMを何度も改善 より良い回答を出す最適化手法をAIが発見する技術 Sakana AIなどが開発

LLMが別のLLMを何度も改善 より良い回答を出す最適化手法をAIが発見する技術 Sakana AIなどが開発

AIベンチャーのSakana AIやFLAIR、英ケンブリッジ大学、オックスフォード大学に所属する研究者らは、人間の介入を最小限に抑えて新しい最適化アルゴリズムをAIによって発見する手法を提案した研究報告を発表した。 安野たかひろ氏のAITuber「AIあんの」 技術解説記事を公開 RAG活用&ハルシネーション対策のダブルチェックなど

安野たかひろ氏のAITuber「AIあんの」 技術解説記事を公開 RAG活用&ハルシネーション対策のダブルチェックなど

東京都知事候補である安野たかひろ氏の運営事務所は、YouTubeで公開しているAITuber「AI安野たかひろ」(AIあんの)の仕組みを解説する記事を公開した。 イラストの手書き証明が不可能に? “絵の制作過程”動画を生成するAI 米スタンフォード大の研究者が発表

イラストの手書き証明が不可能に? “絵の制作過程”動画を生成するAI 米スタンフォード大の研究者が発表

米スタンフォード大学の研究者は、イラストの制作フロー動画を生成するAI「PaintsUndo」を発表した。すでに完成したイラストを入力することで、下書きの状態から着彩され、イラストが完成するまでの流れのディープフェイクを自動生成する。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.