AI開発に黄色信号? 市場急成長で“学習用データ枯渇”の懸念 解決策といわれる「合成データ」とは何か:小林啓倫のエマージング・テクノロジー論考(2/4 ページ)

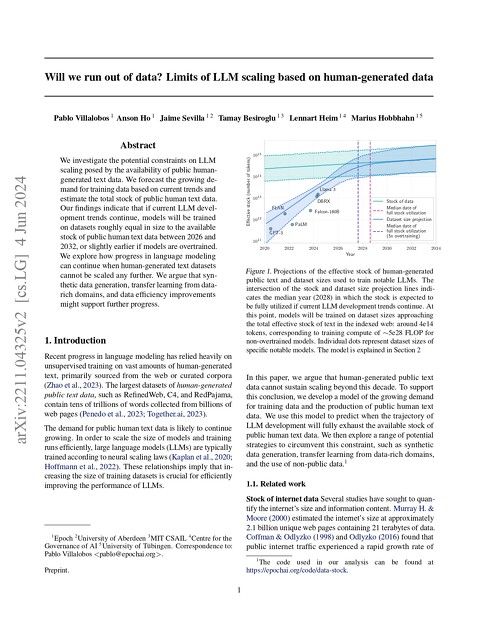

22年に発表されたある論文では、現在のAI開発の傾向が続けば、26年までに高品質のテキストデータが枯渇すると予測している。また、低品質の言語データは30〜50年の間に、低品質の画像データは30〜60年の間に枯渇すると推定している。

そこで合成データの出番というわけだ。合成データは既存のデータセットを補強し、多様なサンプルを生成することで、この問題に対応する。特に画像認識のような大量のラベル付きデータを必要とするタスクで有効という。合成データによって、手動でのデータラベリングにかかるコストと労力を大幅に削減できるためだ。

“実在しない人物”のデータの価値

合成データは、データの枯渇という問題だけでなく、特定の分野や領域に特化した課題にも対応できる。例えば、大規模言語モデル(LLM)は多くの分野で優れた性能を発揮しているが、医療などの特殊な分野では、回答品質を維持するのに苦戦することがある。

医療データは、個人情報保護の観点から公開されにくく、AIの学習に利用できるデータが限られているためだ。このような制約によるデータ不足は他の分野でも見られている。GDPR(EU一般データ保護規則)など各国の規制により、今後も個人情報を含む実際のデータの共有は厳しく制限されると考えられている。

しかし合成データであれば、前述のAMLの事例のように、実データを参照しつつプライバシーに配慮した形でデータを生み出せる。生成したデータは、本当の人間が生み出す行動や症例などのデータにそっくりでありながら、その「人」は実在しない。このため合成データは、プライバシーに敏感な分野でも、現実的かつ人工的なデータを作成することで、専門的なAIモデルの学習を可能にするのだ。

さらに仮説的なシナリオや、発生頻度の低いシナリオの実現も、合成データの重要な利点だ。研究者は合成データを生成することで、実際のデータには十分に表れていない仮説的なシナリオやレアケースを作成し、AIモデルの性能を確認できる。これは、AIシステムの堅牢性をテストし、異なる条件下での結果を探るのに有益となる。

これらはデータ不足という観点から合成データが求められる理由だが、それ以外にも、合成データの必要性を高めている理由がいくつか存在している。

Copyright © ITmedia, Inc. All Rights Reserved.