EUの最新AI規制で課される「透明性義務」 ユーザー企業への影響は:AI規制の最先端「EU AI Act」の全体像

2024年5月、世界に先駆けて、欧州連合(EU)ではAIに対する包括的な規制「EU AI Act」(EU AI規制法)が成立した。AIシステムをEU域内に投入する各国・地域の企業にも適用され、世界に大きな影響を与えている。この法律が禁止するAIは25年2月から適用され、他の要件も今後数年かけて順次適用されていく。まさに今、企業はその備えをすべきタイミングだ。

本連載では、各企業がこの法律に対応するための基礎的な内容と抑えておくべきポイントなどを全3回にわたって解説する。連載最終回の本稿では、第1回と第2回で解説した「禁止AI」「ハイリスクAI」「汎用目的AIモデル」に続き、「透明性義務のあるAIシステム」について、その定義や企業が対応すべき内容を解説。AI規制は開発者に課せられる義務に注目が集まる傾向にあるが、あらためてユーザー企業への影響や準拠対応として何をすべきか考察する。

著者プロフィール:KPMGコンサルティング 執行役員 パートナー 熊谷堅(くまがい けん)

システム開発等に従事した後、外資系コンサルティング会社を経て2002年にKPMGビジネスアシュアランス(現KPMGコンサルティング)に入社。デジタル化やデータに関わるガバナンス、サイバーセキュリティ、IT統制に関わるサービスを数多く提供。現在は、KPMG各国事務所と連携し、KPMGジャパンにおけるTrusted AIサービスをリード。法規制対応を含むAIガバナンス構築プロジェクトを手掛ける。

透明性義務のあるAIとは

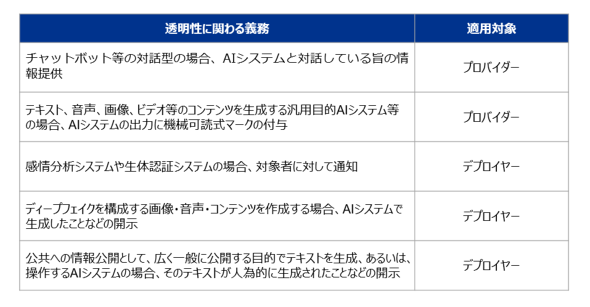

透明性義務のあるAIシステムに当てはまるのは、チャットbotのように、人と対話するようなAIシステムなど、テキスト・音声・静止画・動画を問わず、いわゆる生成AIも透明性義務の対象となる。

EU AI規制法では、前者はAIシステムとの対話であることの情報を、後者は出力物に対して機械可読式マークの付与を求めている。いずれも、AIシステム自体に何らかの対応が必要となる可能性が高いため、プロバイダーの義務となっている。

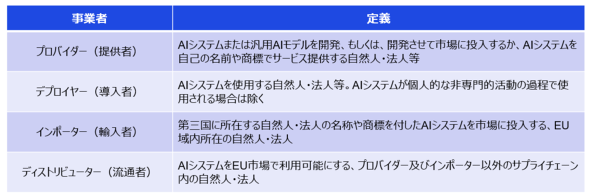

第1回でも解説した通り、EU AI規制法では、AIシステムをユースケースなどの条件によってカテゴリー分けしている。さらに、汎用性の高いAIモデルに対しても規制を設けている。

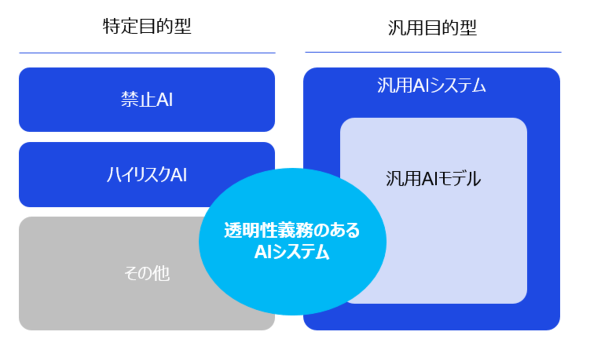

透明性義務のあるAIシステムは、ハイリスクAIシステムや汎用目的AIモデルを搭載したシステムと排他的な関係ではなく、重複し得る。ただし「禁止AI」として扱われるモデルやシステムは、その名の通り利用などが禁止されるため、重なりを認識する必要はない。

EU AI規制法対応を進めるうえでは、おそらくAIシステムの洗出し作業から着手することになるが、その際は大きく分けて図1に示す2種類の「透明性義務のあるAIシステム」を特定することとなる。

ただし、AIによる感情認識システムや生体認証システムは、同じく透明性義務のあるAIシステムに当てはまるものの、エンドユーザーへの通知義務がデプロイヤーに対して追加で課される。

また、ディープフェイクを構成する画像・音声・コンテンツを作成する場合、デプロイヤーがAIシステムで生成したことなどを開示する必要がある。日常のビジネスシーンや利用方法に関係するものであり、エンドユーザーやデプロイヤーに対しても明確に義務を課している。

デプロイヤーの法的義務と、透明性の実現

なお、ハイリスクAIシステムに対しては、別の条文でも透明性義務が規定されている。

ハイリスクAIシステムは、システムの出力を理解して適切に使用できるように「その運用が十分に透明であることを保証するように設計・開発されなければならない」とされる。プロバイダーに対してはAIシステムの透明性確保を求めており、デプロイヤー向けに簡潔で正確かつ理解しやすい「使用説明書」の添付が必要となる。具体的には、次のような内容を含めなければならない。

- ハイリスクAIシステムの性能の特性、能力および限界

- 堅牢性、サイバーセキュリティなどに影響を与える既知あるいは予見可能な状況

- 健康、安全、基本的権利に対するリスクの防止、または、最小化を目的とした人的監視措置

- デプロイヤーがログを適切に収集、保存、解釈できるようにするメカニズム

この「使用説明書」の提供はプロバイダーに課せられるが、それを受け取るデプロイヤーの責任も大きい。使用説明書に従ってシステムを使用することを確実にするため、適切な技術的措置および組織的措置を講じることが求められる。

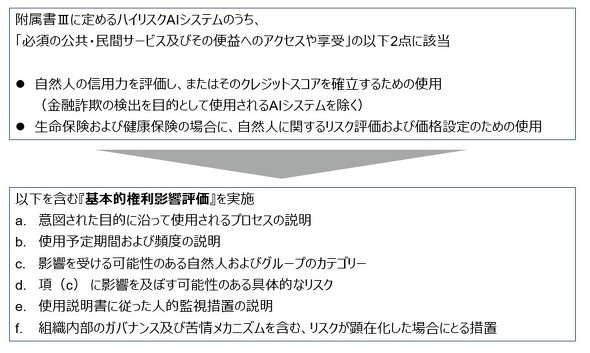

自社の業務環境においてAIシステムを導入する場合は、利用開始前に従業員の代表者および影響を受ける従業員に対して、使用の対象となることを通知しなければならない。さらに、所定の条件に該当する場合は、EU一般データ保護規則(GDPR)のデータ保護影響評価とも関連付けて、「基本的権利影響評価」を実施しなければならないなど、ハイリスクAIシステムのデプロイヤーは相応の対応が必要となる。

ハイリスクAIシステムの導入後はその動作を監視し、法の定めに従い、使用停止の判断や当局ならびに関係者に報告する義務も課せられている。EU AI規制法には報告を求める重大インシデントの定義や、該当する場合はデプロイヤーにも報告義務とその期限が設定されている。ハイリスクAIシステムを利用する場合、組織内のインシデント対応に関わる規定や計画を見直すことになるだろう。

ちなみにEU AI規制法では、市場投入後のモニタリング義務も明確に規定されている。プロバイダーに課せられた義務ではあるが、デプロイヤーから提供され得るデータや他のソースからのデータを積極的かつ体系的に収集・分析しなければならないとされる。そのためデプロイヤーはプロバイダーから提供される使用説明書に従い、協力が求められる可能性がある。

このように、EU AI規制法に定めるプロバイダーとデプロイヤーは相互協力のもと、リスクを抑制するための対応が必要となる。

デプロイヤーとプロバイダーの境界線はどこで引く

とはいえ、システム開発やサービス提供には多くの関係者が携わる。EU AI規制法ではプロバイダーとデプロイヤーが切り分けられており、その立場の違いは明確だが、現実には簡単に割り切れないことも多いだろう。実際、その境界は不明瞭だ。

そのため「当社はあくまでユーザーの立場であるため、法規制対応は開発者にて実施するもの」と安易に決めつけてしまうのは危険といえる。EU AI規制法の準拠対応を進めるうえでは、対象となるAIシステムごとに入念な確認をすべきだ。

ITベンダーに対して顧客企業が直接的な要件や仕様を提示して開発するケースなどは、ITベンダーが法律上のプロバイダーとなって責任を果たすことが難しい場合もある。また、ユーザー企業独自のデータを用いて構築される専用のAIモデルやAIシステムは、稼働後のモニタリング、適合性評価、CEマーキングに関わる実務、EUのデータベースへの登録などをユーザー企業が担わざるを得ない可能性もあるだろう。

ビジネスにおいてAIに起因するリスクに対して直接影響を受けるのはAIシステムを導入側、すなわちユーザー側だ。法律の理解と準拠対応の役割分担などを主体的に検討・推進することを期待したい。

関連記事

EUの最新AI規制、AIモデル・システム開発企業が取るべき対応は?

EUの最新AI規制、AIモデル・システム開発企業が取るべき対応は?

企業がAIに対する包括的規制“EU AI Act”(EU AI規制法)に対応するためのポイントなどを全3回にわたって解説する。 他人事ではない、AI規制の最先端「EU AI Act」に備えよ 何が禁止され、誰に影響が及ぶのか

他人事ではない、AI規制の最先端「EU AI Act」に備えよ 何が禁止され、誰に影響が及ぶのか

本連載では、企業がAIに対する包括的な規制“EU AI Act”(EU AI規制法)に対応するための基礎的な内容と抑えておくべきポイントなどを全3回にわたって解説する。 「AIリテラシー」って一体なに? 企業に求められる水準を考える

「AIリテラシー」って一体なに? 企業に求められる水準を考える

「ネットリテラシー」と言えば、ネット上に流れる有象無象の情報を正しく理解し、活用する能力……といった意味で使われている。それと同じように「AIリテラシー」の必要性が昨今叫ばれている。具体的にどのような能力が求めれれるのか? 科学研究をAIで全自動化──論文執筆や査読ができる「The AI Scientist」 Sakana AIが発表

科学研究をAIで全自動化──論文執筆や査読ができる「The AI Scientist」 Sakana AIが発表

AIモデルを使って、科学研究を自動化できないか?──AIベンチャーのSakana AIは、そんな需要に対応するAIシステム「The AI Scientist」を発表した。 2025年、AIエージェント元年? 企業内で安全に使うには 「AIエージェント・ガバナンス」を考える

2025年、AIエージェント元年? 企業内で安全に使うには 「AIエージェント・ガバナンス」を考える

AI関連企業各社が発表している「AIエージェント」。企業内で安心安全に活用するためには、どのようなガバナンスを確立すれば良いのだろうか。「AIエージェント・ガバナンス」がどのような姿になり得るのか考えてみたい。

Copyright © ITmedia, Inc. All Rights Reserved.