Anthropic、AI「Claude」に“核兵器への悪用”を防ぐシステム実装

米Anthropicは8月21日(現地時間)、AIの悪用を防ぐ取り組みとして、米エネルギー省(DOE)傘下の国家核安全保障局(NNSA)と協力し、核兵器に関する危険な利用を検知する“分類器”を開発したと発表した。AIモデルが正当な研究目的と兵器開発を目的とした不正利用を区別できるようにするもので、既に同社の「Claude」に実装しているという。

NNSAとの協力は2024年4月から始まっており、NNSAの専門家がClaudeに対して核技術に関する挑発的な質問や模擬攻撃を仕掛ける「レッドチーミング」を行い、その結果得られた知見をAnthropicが分類器の設計に活用した。分類器はAIとのやり取りをリアルタイムで判定し、核兵器開発に直結するような不審な対話を検知する役割を担う。

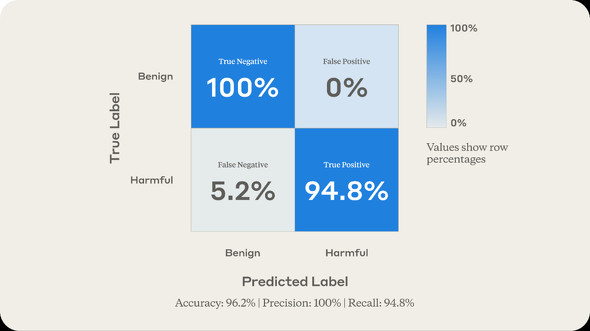

この分類器は、危険性のある対話の約95%を正しく識別でき、正当な教育目的やエネルギー研究に関する会話を誤って遮断することはなかったという。最終的な総合精度は96%を超え、既に実際のトラフィックで有効性が確認されていると同社は説明している。ただし一部のケースは検知をすり抜ける可能性も残されており、完全な安全策ではないことも認めている。下の画像では、有害な会話の5.2%を無害だと分類していたことが示されている。

Anthropicは今回の成果をFrontier Model Forumを通じて業界全体と共有する計画で、核技術に限らず、化学や生物といった他のセンシティブな領域にも応用可能だとする。AIが人間社会に広く使われる中で、どのような利用が安全で、どのような利用が危険なのかを官民で共通認識として定義することが重要だと強調した。

同社はこれまでもAIの安全性や透明性をめぐる提言を積極的に行っている。15日にはClaudeの「使用ポリシー」を更新し、翌16日には“AIの福祉”研究の一環として、Claudeに有害な会話を打ち切る機能を追加している。

関連記事

Google、「Gemini」の環境負荷を公表 テキストプロンプト1回で「水5滴分、TV視聴9秒以下」

Google、「Gemini」の環境負荷を公表 テキストプロンプト1回で「水5滴分、TV視聴9秒以下」

Googleは、Geminiの環境負荷を公表した。テキストプロンプト1回で水5滴分、TV視聴9秒以下の消費量と主張する。測定にはLLMのトレーニングや画像生成は含まれていないが、過去1年で効率は大幅改善したとしている。 Anthropic、「Claude」の使用ポリシーを更新 エージェント機能の悪用規制を明示

Anthropic、「Claude」の使用ポリシーを更新 エージェント機能の悪用規制を明示

Anthropicは、AI「Claude」の使用ポリシーを9月15日付で更新すると発表した。エージェント機能の進化を受け、マルウェア作成やサイバー攻撃などの悪用を具体的に禁止。一方、政治的コンテンツに関する制限は一部緩和する。 OpenAI、AIによる生物兵器開発リスクに警鐘

OpenAI、AIによる生物兵器開発リスクに警鐘

OpenAIは、AIが悪用され生物兵器開発につながる深刻なリスクがあると警告した。同社の将来のAIモデルは専門知識のない人物による生物学的脅威の作成を可能にする恐れがあるという。有害リクエストの拒否や専門家との連携、疑わしい行為の監視などの多角的な対策を講じ、社会全体の防御力向上も提唱している。 AIの4社(Anthropic、Google、Microsoft、OpenAI)、安全なAI目指すフォーラムFMF立ち上げ

AIの4社(Anthropic、Google、Microsoft、OpenAI)、安全なAI目指すフォーラムFMF立ち上げ

米国のAI主要企業であるAnthropic、Google、Microsoft、OpenAIは、新フォーラム「Frontier Model Forum」(FMF)を立ち上げた。AIの安全性のベストプラクティスを特定し、社会的課題へのAI技術の利用を促進するのが目的としている。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.