Google、差分プライバシー適用の「VaultGemma」 個人情報の記憶・漏洩リスクを低減

米Googleは9月12日(現地時間)、「Differential Privacy」(差分プライバシー、DP)を適用したオープンなLLM「VaultGemma」を発表した。差分プライバシーの原則に則ってゼロからトレーニングされた、現在最も高性能なLLMとしている。

VaultGemmaは、10億パラメータを持つオープンモデルで、その設計にはGemmaモデルの中核をなす責任と安全性が組み込まれているという。AIが日常に浸透するにつれて、プライバシーに配慮することが重要になってきており、差分プライバシーはこの課題に対する数学的に堅固な解決策を提供するとしている。差分プライバシーのアプローチは、トレーニングデータに調整されたノイズを加えることで、モデルがトレーニングデータを記憶するのを防ぐというものだ。

従来のLLMとの大きな違いは、この差分プライバシーの全面的な適用にある。一般的なLLMは、Web規模の膨大なデータでトレーニングされるため、意図せず個人情報や機密データを記憶し、漏洩するリスクが指摘されてきた。VaultGemmaは、個々のトレーニングデータがモデルの最終的な振る舞いや出力に与える影響を厳しく制限し、特定の個人の情報がモデルによって「記憶」され、出力から漏洩するリスクを極めて低くするように設計されているという。

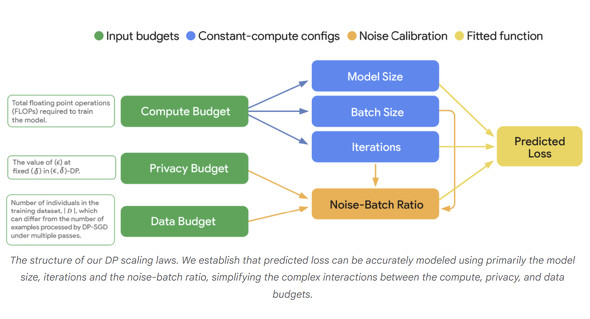

その結果、VaultGemma 1Bは、トレーニングデータの記憶を検出できないことが実証されており、個々のトレーニング例の保持を防ぐ差分プライバシーの有効性が強く裏付けられているとしている。また、差分プライバシーによるトレーニングは従来のLLMトレーニングとは異なる特性を持つため、Googleは新たなスケーリング法則を確立し、計算コスト、プライバシー予算、ユーティリティの間の複雑なトレードオフを正確にモデル化することで、VaultGemmaの開発を導いたという。

VaultGemmaはオープンモデルとして公開されており、そのモデルウェイトはHugging FaceとKaggleを通じて利用可能だ。

医療や金融など、トレーニングデータのプライバシーが非常に重要な分野でのアプリケーションや、プライバシーが懸念される状況でのコンテンツ作成やチャットボット、文書要約などにも利用できるとしている。

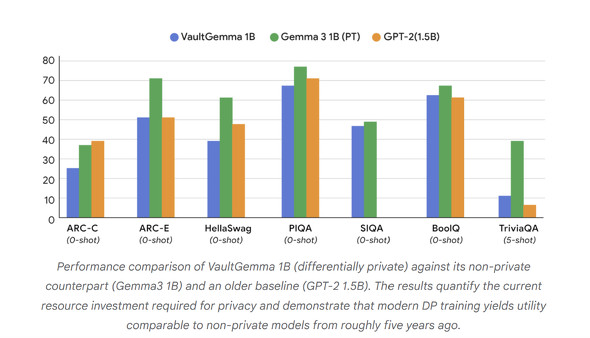

現状では、差分プライバシーでトレーニングされたモデルとそれ以外のトレーニングモデルとの間には実用性のギャップが存在するものの、このギャップを体系的に縮小し、安全で責任あるプライベートな次世代AIの構築をコミュニティ全体で推進することを目指すとしている。

関連記事

Google、“超小型”AIモデル「Gemma 3 270M」公開 スマホで動き、省電力性能に優れる

Google、“超小型”AIモデル「Gemma 3 270M」公開 スマホで動き、省電力性能に優れる

米Googleは、2億7000万パラメータの小型AIモデル「Gemma 3 270M」を公開した。エッジデバイス向けで、マルチモーダルに対応。省電力性能に優れるという。 Googleが軽量AIモデル「Gemma 3n」を発表 スマホ上で高性能マルチモーダルAI Claude 3.7 Sonnetに肉薄

Googleが軽量AIモデル「Gemma 3n」を発表 スマホ上で高性能マルチモーダルAI Claude 3.7 Sonnetに肉薄

米Googleが、モバイルデバイス向けの新しいAIモデル「Gemma 3n」を発表した。スマートフォンやタブレットなどのモバイルデバイス上で直接動作する高性能なマルチモーダルAIで、テキスト、画像、音声、動画を理解・処理できる能力を備える。 Googleのオープンな生成AIモデル「Gemma」、1億5000万超ダウンロード

Googleのオープンな生成AIモデル「Gemma」、1億5000万超ダウンロード

Googleのオープンな生成AIモデル「Gemma」のダウンロード数が累計1億5000万回を超えたと発表した。Gemmaは昨年2月に公開された。2023年2月に公開されたGemmaと競合するMetaの「Llama」のダウンロード数は累計12億回以上だ。 Google、オープンな生成AIモデル「Gemma」公開 商用利用OK、Geminiと同じ技術の軽量LLM

Google、オープンな生成AIモデル「Gemma」公開 商用利用OK、Geminiと同じ技術の軽量LLM

米Googleは、大規模言語モデル(LLM)「Gemma」を公開した。同社が開発するLLM「Gemini」に使ったのと同じ技術を活用して開発した軽量版LLMで、同社は「オープンなAIモデル」として位置付けている。商用利用も可能としている。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.