パラメータ数は1兆超──“超巨大”なLLM「Qwen3-Max」は何がすごいのか? 中華製フラッグシップAIの現在地:小林啓倫のエマージング・テクノロジー論考(1/3 ページ)

中国Alibabaが9月に発表した、同社のLLM「Qwen」シリーズの新たなフラッグシップモデル「Qwen3-Max」。同モデルは1兆超パラメータを持ち、特にタスクを自律的に実行するエージェント能力が強みだ。AI分野の中心が、タスク特化型AIから生成AI(チャットbot)、AIエージェントへと移りつつある中、Qwen3-Maxはどのような存在といえるのだろうか。

「Qwen3-Max」の仕組みは?

まずは、このモデルの概要をまとめておこう。Qwen3-Maxは、Alibabaが中国の浙江省杭州市で開催した年次イベント「Apsara Conference」で発表したAIモデル。記事時点で同社最大規模のAIモデルであり、開発には36兆トークンという膨大な学習データを使ったという。

パラメータ数は1兆以上で、119の言語に対応している。米OpenAIなどの競合他社はこれらの指標について明確な数値を示していないが、Qwen3-Maxの性能は、他の先端AIモデルに匹敵するか、それを上回るものと考えられている。

この巨大な規模を実用的なレベルで実現するために採用したのが、MoE(Mixture of Experts、エキスパート混合)と呼ばれるアーキテクチャだ。

これまでの大規模なAIモデルでは、計算処理が膨大になるという問題が指摘されてきた。例えば1兆パラメータのモデルでは、1つの質問に答えるだけでも全パラメータを通す必要があり、そのままではレスポンスが非常に遅く、コストも高くなってしまう。これは特に、企業内で大規模な利用を想定している場合には大きな課題となる。

しかしQwen3-Maxでは、モデル内に小規模な128の専門家(エキスパート)モデルを組み込んでおり、1つの質問に対して8つの専門家モデルを選択・活用する。

各専門家モデルは、数学やプログラミング、言語翻訳など特定の種類のタスクや知識領域に特化しており、実際の処理では、8つの専門家モデルのアウトプットを統合して最終的な答えを生成する。この仕組みにより、推論時の計算リソースを大幅に節約し、運用効率を高めているという。

またAlibabaは、OpenAIのAIモデル「GPT-5」と同様、Qwen3-Maxに「Instruct」(非思考)と「Thinking」(思考)の2モードを用意する方針を示している。InstructはAPIとAlibabaのチャットAI「Qwen Chat」で提供中で、Thinkingは今後順次提供する予定だ。

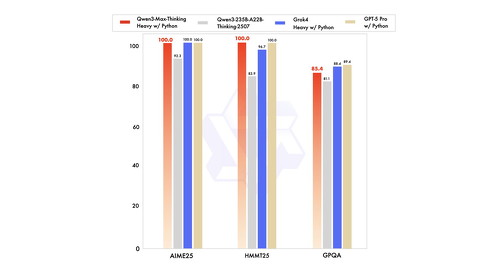

Instructは標準的な指示の実行や、コーディング向けに設計しており、高速な応答が必要なタスクに適している。一方Thinkingは、複雑な論理推論や、外部ツールを活用するエージェント処理に特化したバージョンだ。同モードは思考時間をより長くすることで、数学的推論などの性能を強化。ベンチマークでは、米国数学オリンピック予選問題(AIME 2025)で100%の正答率を達成している。

この切り替え可能な設計により、ユーザーはタスクの複雑さに応じて、計算リソースを効率的に配分できる。前述のMoE同様、巨大なモデル規模と効率性・省コストを両立させる工夫がなされているわけだ。

Copyright © ITmedia, Inc. All Rights Reserved.