EPGも大きく、見やすく〜NHKの情報バリアフリー技術:技研公開2004

年々高度化していく放送技術の中で、決して派手さはないものの、重要な役割を持っているのが「情報バリアフリー」を目指した研究開発だ。デジタル化とともにチャンネル数や新しい機能が増えたのはいいが、一方で操作が複雑になっているのも一面の事実。高度になる放送と通信の技術を“誰でも使える”方向に生かすのが情報バリアフリーの研究といえる。NHK放送技術研究所の公開展示には、そんな研究成果が多く展示されている。

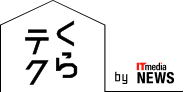

こちらは、音声認識機能を使って字幕をリアルタイムに作成し、画面に表示してくれるテレビだ。文字放送などに対応していない番組にも適用できるため汎用性が高く、放送局のコスト負担も少なくてすむ。ただし、周囲の雑音などを拾って認識率が下がることもあるため、専任の“字幕キャスター”が番組音声を字幕用に言い直して音声認識させる「リスピーク」方式の研究も進められているという。

日本ビクターが開発した「音声がゆっくり聞けるテレビ」は、お年寄りや聴覚に障害のある人には心強い味方になりそうだ。これは、2002年秋にビクターが発売した「音声がゆっくり聞けるラジオ」の第2弾。基本的な仕組みはラジオと同じで、話し始めをゆっくり再生し、音声のない部分で必要な時間を補いながら徐々に再生速度を上げていくという。

「人間の耳は、話始めがゆっくりであれば内容を聞き取りやすい。そこで、信号処理技術を使って、人の話し声をリアルタイムに速度変換する」(NHK)。

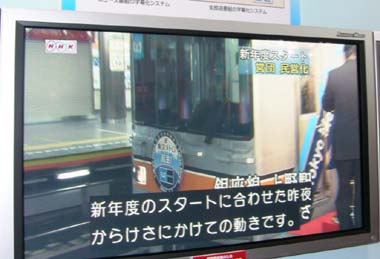

弱視の方でも読みやすいよう、文字や背景、選択枠などの色を調整できるEPG(電子番組表)も展示されていた。画面下部には、拡大表示するエリアも用意されていて、読みたい部分を任意の文字サイズに拡大することができる。

画面調整はセットトップボックスのような画面調整器で行うが、その際「背景」「選択枠」「文字」の色とコントラストをそれぞれ独立した形で調整できるのが特徴だ。これは、視覚障害の場合、人によって苦手が色が異なるため。文字と背景を反転させることも可能になっている。

“たまちゃん”はいずこ

昨年の展示では、複雑化したテレビの操作を支援してくれる“対話型テレビエージェント”というデモンストレーションがあった。謎のキャラクター「たまちゃん」が対話と音声認識によってユーザーの意図を汲み取り、チャンネルの切り替えや音量の調節といったテレビの操作を支援・代行してくれるというものだ。

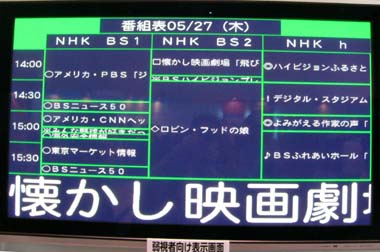

今年は「たまちゃん」の姿が見えなくなってしまったが、昨年のシステムを進化させた「視線などの非言語情報や、声の抑揚を操作支援に利用するシステム」が展示されている。

視線入力の仕組みは、ちょっと複雑だ。写真ではわからないが、実は視聴者の前方にある机の下に2台のカメラが設置されており、撮影画像を元にコンピュータ処理を行い視線の先を読みとる。何故カメラが2台必要かというと、それぞれが別の役割を持っているからだ。片方は、常に視聴者の“顔の場所”を追跡し、もう片方はその結果をもとに視聴者の目をクローズアップ。瞳孔の大きさと照射した赤外線の反射角から、見ている方向を細かく判別するという(なお、照射する赤外線は人体には影響のないレベルだ)。

視聴者は、チャンネル一覧の画面で目的の番組を見つけたら、「あれ」とか「それ」とか声に出すだけでいい。視線の先にある項目を読みとり、チャンネルが自動的に切り替わる。また、受信機のEPGと連携させることで、さらに高度な操作も可能になるという。「たとえば、“映画がみたい”と言えば、検索結果を一覧表示。目的の映画を見つけたら“これみせて”と言うだけで再生が始まる」。

最近はEPGのおかげで番組検索や録画予約が楽になったが、一方でキーワード入力や複雑なメニュー操作は万人が使いこなせるというものでもない。情報バリアフリーを目指すエージェントの開発は、使いやすいユーザーインタフェースという意味でも注目できそうだ。

NHK放送技術研究所の一般公開は、5月30日の日曜日まで。公開時間は10時から17時までとなっている(入場は終了30分前まで)。

関連記事

それよりもっと未来を見つめて〜NHK技研公開2004

それよりもっと未来を見つめて〜NHK技研公開2004

5月27日から30日まで、東京世田谷区砧のNHK放送技術研究所の一般公開が行われている。目立つところにいるのは地上波デジタルテレビ放送関係だが、こちらは例によって、もっと変なものを拾っていこう。- 地上デジタル放送の近未来を覗く

NHK放送技術研究所が、毎年恒例の一般公開(技研公開展示)を開始した。やはり力が入っていたのは、地上デジタル放送関連の展示。とくに先日発表された「移動体受信技術」や、携帯電話向けのサービスが注目を集めている。 - 21世紀のリモコン? “たまちゃん”

- 音声をゆっくりはっきりに変換するラジオ ビクター

- ラジオ音声をゆっくりと何度でも ビクターが「聴取補助システム」開発

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR

音声認識により、リアルタイムに字幕を表示するテレビ

音声認識により、リアルタイムに字幕を表示するテレビ 音声がゆっくり聞けるテレビ。日本ビクターが6月に発売する予定だ

音声がゆっくり聞けるテレビ。日本ビクターが6月に発売する予定だ 文字や背景、選択枠などの色を調整できるEPG(電子番組表)

文字や背景、選択枠などの色を調整できるEPG(電子番組表) 画面調整器。前面のツマミを回して調整する

画面調整器。前面のツマミを回して調整する こちらは全盲の方のための「触覚提示」システム。データ放送のBMLをXMLに変換し、それを元に点字を作り出す。左側にある大きめのパネルは、画面の様子をそのまま展示で表すというもの

こちらは全盲の方のための「触覚提示」システム。データ放送のBMLをXMLに変換し、それを元に点字を作り出す。左側にある大きめのパネルは、画面の様子をそのまま展示で表すというもの 視聴者の視線や音声を使ってテレビ受信機を操作する「視線情報を利用するテレビエージェント」デモ風景

視聴者の視線や音声を使ってテレビ受信機を操作する「視線情報を利用するテレビエージェント」デモ風景 2台のカメラが撮影した映像をコンピュータ処理中

2台のカメラが撮影した映像をコンピュータ処理中