SpotifyがミスによりKubernetesの本番クラスタを二度も削除。しかし顧客へのサービスにほとんど影響しなかったのはなぜか?(2/2 ページ)

» 2019年07月08日 11時03分 公開

[新野淳一,ITmedia]

計画的に障害に備えよ

なぜこういったことが可能だったのか? われわれは計画的に障害に備えており、またKubernetesのような複雑なインフラへの移行は徐々に行っており、しかも社内には積極的に学ぶカルチャーが存在していたためだ。

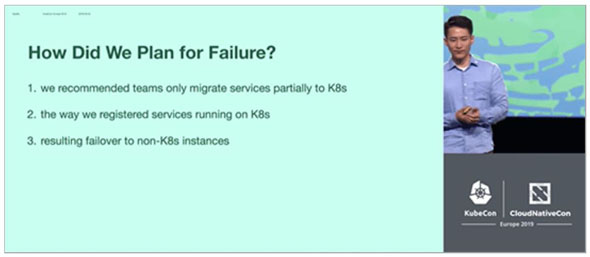

具体的には、Spotifyにおいて当時Kubernetesの利用はまだβ段階であったため、各チームには全面的なKubernetesへの移行ではなく、部分的な移行を推奨していた。

さらにサービスディスカバリ機構はKubernetesのものではなく社内のものを使ってPodのIPアドレスを指していたため、Kubernetesクラスタが失われたときにはそのIPアドレスを削除してサービスディスカバリを再起動することにより、すぐに非Kubernetesのインスタンスへのフェイルオーバーが可能となった。

まとめ

大事なことは、障害に備えてクラスタをちゃんとバックアップしておくこと。リストアのテストをしていないバックアップは、バックアップの意味を成していない。

そしてインフラのコード化を進めること。ただし新しいツールの導入は徐々に行うこと。

さまざまな状況を想定した複数のディザスターリカバリーテストを行うこと。

社内には、失敗したときに人を責めるのではなく、そこから学ぶという文化を創ること。私がクラスタを削除したときでさえ、Spotifyのチームは私をサポートしてくれた。

そしてようやく先週から、われわれもサービス全体をKubernetesへ移行する準備ができて、その作業を進め始めたところだ。

関連記事

「君、今日からクラウド担当ね」 未経験者が1人で始めた、ファミマのAWS移行の舞台裏

「君、今日からクラウド担当ね」 未経験者が1人で始めた、ファミマのAWS移行の舞台裏

「AWS Summit Tokyo 2019」のセッションに、ファミリーマートでクラウド移行の責任者を務める土井洋典さんが登壇。土井さんは、前任者が突然退職したため、ある日突然上司からクラウド担当を任された経験を持つ。たった1人でのスタートだったというが、どうやってAWS移行を成功させたのだろうか。 「この虫の名は?」すぐ解決 20万匹の害虫画像を学習した、駆除を支える「クラウド×AI」がスゴい

「この虫の名は?」すぐ解決 20万匹の害虫画像を学習した、駆除を支える「クラウド×AI」がスゴい

大阪に拠点を置く、害虫駆除機器の専門商社「環境機器」が、害虫の画像を自動で取得し、名前を判定するサービス「Pest Vision」を開発。画像は、Amazon Web Services上に構築したAIを使って分析している。環境機器の担当者に、その仕組みと精度について聞いた。 ラーメン屋・幸楽苑、店長の「シフト作成」をクラウド活用で自動化へ 「バイト入れる?」と聞く手間省く

ラーメン屋・幸楽苑、店長の「シフト作成」をクラウド活用で自動化へ 「バイト入れる?」と聞く手間省く

ラーメンチェーンの幸楽苑が、アルバイトの勤務シフトを自動作成するクラウドサービス「beepシフト」を導入する。アルバイトが働きたい日時を専用のアプリに入力すると、時間ごとに必要な人数を分析した上で、シフトを作成する仕組み。店長が手作業でシフトを決める負担を軽減する狙い。 PayPay“100億円祭”の裏側で何があったのか システム障害と苦闘したエンジニア

PayPay“100億円祭”の裏側で何があったのか システム障害と苦闘したエンジニア

PayPayで昨年12月に展開した「100億円あげちゃうキャンペーン」。その間、ユーザー数の増加に伴い、PayPayのシステムは不安定な状態に。押し寄せる膨大なアクセスに、PayPayのエンジニアはどのように対応したのか。

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PRアイティメディアからのお知らせ

SpecialPR

あなたにおすすめの記事PR