動画からその物体だけを消し去る技術 Microsoftなどが開発:Innovative Tech

Innovative Tech:

このコーナーでは、テクノロジーの最新研究を紹介するWebメディア「Seamless」を主宰する山下裕毅氏が執筆。新規性の高い科学論文を山下氏がピックアップし、解説する。

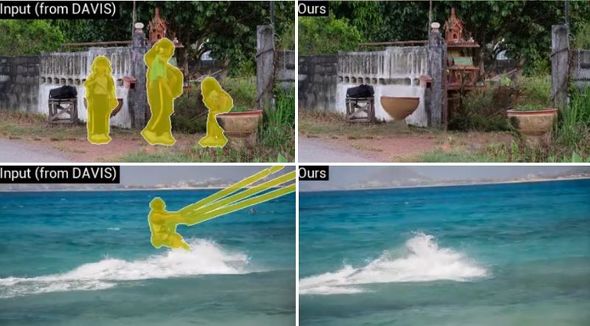

中国・中山大学とMicrosoft Research Asiaの研究チームが開発した「Learning Joint Spatial-Temporal Transformations for Video Inpainting」は、動画内の特定の物体だけを除去する深層学習ベースのフレームワークだ。

画像から特定の物体を除去する手法は、消した欠落領域を埋めるように修復するインペイント方式が効果的で、これまでも多くの研究で採用されてきた。しかし、映像でのインペイント方式となると、動く物体を連続的に除去する必要があるため、空間/時間的制約を受け、修復した領域がぼやけたり、一時的に不自然な部分が発生したりする。

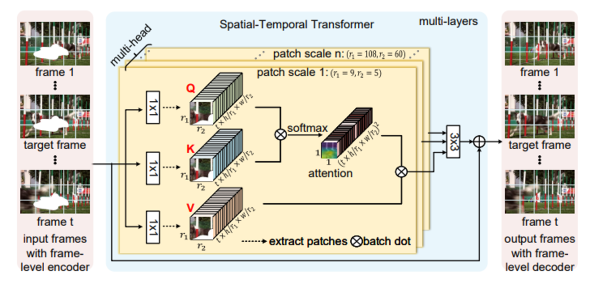

この課題に挑戦するため、高精度に映像内の物体除去を行えるビデオインペイント・ネットワーク「Spatial-Temporal Transformer Network」(STTN)を提案する。具体的には、隣接フレームと遠いフレームの両方を入力し、全ての入力フレームの欠落領域を同時に埋めるよう学習する。最後に、敵対的に学習し最適化を行う。

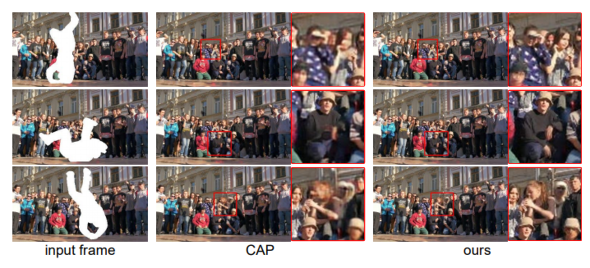

このように学習したモデルの優位性を示すため、静止マスクと移動マスクを使用し、定量的・定性的評価を行った。実験の結果、人が大勢いる複雑な背景で、前景でダンスのように激しく変化する動きがあった場合でも視覚的に良好な修復ができたという。

また、PSNR(ピーク信号対雑音比)とVFID(入力/生成画像の分布がどれだけ似ているかを測定する指標)の相対的な改善率はそれぞれ2.4%と19.7%で、既存モデルを大きく上回ったとしている。

関連記事

1台のカメラから人の動きを正確に抜き出す技術 Adobeなどが開発

1台のカメラから人の動きを正確に抜き出す技術 Adobeなどが開発

物理的制約に反する不自然さを減らすための技術を導入した。 手描きスケッチからリアルな顔を生成 深層学習に画家の手法導入し改善

手描きスケッチからリアルな顔を生成 深層学習に画家の手法導入し改善

画家が実際にやっているような作業を取り入れることで、深層学習による合成精度を上げたという。 コンピュータ不要でレーザー光線に触って遊べるディスプレイ 香港城市大学が開発

コンピュータ不要でレーザー光線に触って遊べるディスプレイ 香港城市大学が開発

LGPUという装置を使うことで、コンピュータやカメラなしでインタラクティブなレーザー操作ができる。 のぞきこんだ顔が水面でドット絵に 電気分解式泡ディスプレイ「Bubble Mirror」 お茶大が開発

のぞきこんだ顔が水面でドット絵に 電気分解式泡ディスプレイ「Bubble Mirror」 お茶大が開発

泡ディスプレイラテアートの進化版が登場。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR