DeepMind、ルールを教えなくても「パックマン」などでハイスコアを出せるAIシステム「MuZero」

米Alphabet傘下のDeepMindは12月23日(現地時間)、ルールを教えなくてもゲームでハイスコアを出せる新しいAIシステム「MuZero」を発表した。

同社はこれまで、「AlphaGo」、「AlphaGo Zero」、「AlphaZero」とAIシステムを進化させてきた。AlphaGoはゲームのルールを習得し、さらに過去の人間による囲碁の膨大な対戦データで学習することで能力を上げる必要があった。AlphaGo Zeroはルールを教えるだけで囲碁に強くなり、AlphaZeroは囲碁だけでなく、将棋とチェスもルールを教えるだけで強くなった。

MuZeroは、AlphaZeroの先読みツリー検索機能と、環境の中で最も重要な側面のみに焦点を当てて学習するモデルを組み合わせることで、人間の「計画する能力」を目指す強化学習アルゴリズムを大きく飛躍させたという。

MuZeroは、環境のダイナミクスのモデルを学習した結果を使って計画を立てることで複雑な問題に対処するのを目的とする、モデルベースのシステム。従来のモデルベースシステムは環境のあらゆる側面をモデル化しようとするもので、これでは例えばAtariの「パックマン」のような複雑な環境に対処するのは難しかったが、MuZeroは環境全体のモデル化ではなく、意思決定プロセスにとって重要な側面だけをモデル化する。

例えば、人間は外出時に傘を持っていくかどうかを空模様から簡単に判断する。MuZeroは傘を持っていくかどうか判断するためにすべての要素をモデル化するのではなく、空中の水滴のパターンはモデル化せず、傘とは何かをモデル化すると、DeepMindは説明している。

具体的には、計画に不可欠な環境の3つの要素、「値」「ポリシー」「報酬」をモデル化する。これらの要素をディープニューラルネットワークで学習し、特定のアクションを実行すると何か起きるかを理解し、対策を計画する。

このアプローチでは、環境から新しいデータを収集しなくても、学習したモデルを繰り返し使って計画を改善していくことができる。

例えばAtariゲームのテストでは、過去のエピソードで実行すべきだったアクションの再計画の時間の90%を、学習済みモデルに費やした。

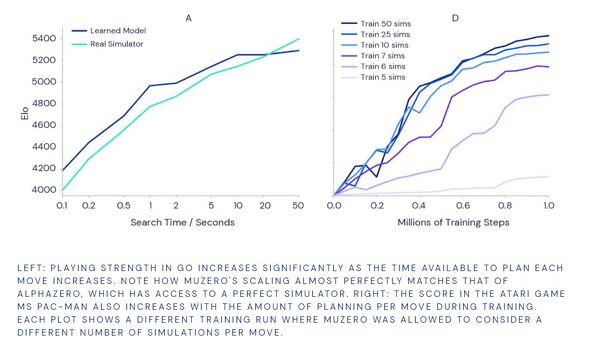

パックマンでは、わずか6〜7通りのアクションのシミュレーションしか検討できないように制限しても、良好なパフォーマンスを見せた(下右のグラフ)。これは、MuZeroがすべての可能性を検索しなくても、アクションと状況を一般化できることを示唆しているという。

MuZeroは、囲碁、将棋、チェスではAlphaZeroと同程度の成果を上げた。

DeepMindは、MuZeroの能力は、強化学習と汎用アルゴリズムの追求における大きな進歩だとし、この能力をロボット工学、産業システムその他の困難な課題解決のために活用できると語った。

同社は既に、AIシステム「AlphaFold」でタンパク質構造予測に取り組んでいる。

DeepMindの主任研究科学者、デビッド・シルバー博士は英BBCに対し、MuZeroを新たな動画圧縮技術の開発に応用していると語った。「ネット上のデータトラフィックの多くを占める動画を効果的に圧縮できれば、大幅なコスト削減が可能だ」と同氏は語り、来年(YouTubeを傘下に持つ)Googleが具体的な発表をすると予告した。

関連記事

Google系列のDeepMind、AIシステム「AlphaFold」で「タンパク質折りたたみ問題」で大飛躍 新薬開発への重要な一歩

Google系列のDeepMind、AIシステム「AlphaFold」で「タンパク質折りたたみ問題」で大飛躍 新薬開発への重要な一歩

Alphabet傘下のDeepMindのAIシステム「AlphaFold」が、世界的なタンパク質構造予測コンペ「CASP」で飛躍的なハイスコアを出した。「解明には宇宙の年齢よりも長い時間がかかる」とされる「タンパク質折りたたみ(フォールディング)問題」の解明への大きな一歩だ。 DeepMindの「AlphaStar」、「スタークラフト2」のプロトップゲーマーに圧勝

DeepMindの「AlphaStar」、「スタークラフト2」のプロトップゲーマーに圧勝

Google系列のDeepMindが開発したAI「AlphaStar」が、人気リアルタイムストラテジーゲーム「スタークラフト2」の2人のトップゲーマーとそれぞれ5ゲーム対戦し、5対0で圧勝した。 「AlphaZero」がチェス、将棋、囲碁の各世界最強AIを打ち負かす

「AlphaZero」がチェス、将棋、囲碁の各世界最強AIを打ち負かす

Google系列のAI企業DeepMindの強化学習採用AI「AlphaZero」が、チェスのAI世界チャンピオン「Stockfish」、世界コンピュータ将棋選手権の2017年の勝者「elmo」、そして自社の囲碁AIで世界最強の「AlphaGo Zero」に勝利した。 「AlphaGo Zero」──ビッグデータ不要のAI棋士が自己対局のみで世界最強に

「AlphaGo Zero」──ビッグデータ不要のAI棋士が自己対局のみで世界最強に

Googleの系列AI企業DeepMindが、世界最強囲碁AI「AlphaGo」の新バージョン「AlphaGo Zero」が、試合データ不要の自己対局のみで、40日後に柯潔九段に勝った先輩AlphaGoに完勝するまでに成長したと発表した。 世界最強となったDeepMindの「AlphaGo」が棋界引退宣言 AI同士の棋譜を公開

世界最強となったDeepMindの「AlphaGo」が棋界引退宣言 AI同士の棋譜を公開

世界最強の人間棋士柯潔(カ・ケツ)九段に完勝したDeepMindの囲碁AI「AlphaGo」がこの勝負を最後に引退する。DeepMindは今後、難病治療や新素材開発に活用できる汎用アルゴリズムの開発に注力する。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR