テキストだけで、AIが3Dモデルを自動生成 米Googleなどの研究チームが開発:Innovative Tech

Innovative Tech:

このコーナーでは、テクノロジーの最新研究を紹介するWebメディア「Seamless」を主宰する山下裕毅氏が執筆。新規性の高い科学論文を山下氏がピックアップし、解説する。

米Google Researchと米カリフォルニア大学バークレー校の研究チームが開発した「Zero-Shot Text-Guided Object Generation with Dream Fields」は、自然言語の記述のみからデジタル3Dオブジェクトを生成するZero-shot learningを使ったアプローチだ。従来の手法とは異なり、3Dの学習データを必要とせず、自然言語によるプロンプトのみを使用し、形状や色、スタイルを柔軟に制御する。

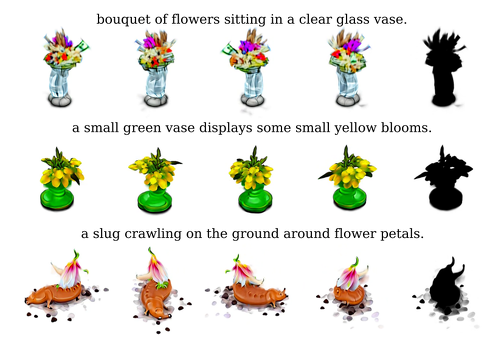

以下の画像では、いくつかの出力結果の例を示している。例えば、画像上段は「bouquet of flowers sitting in a clear glass vase.」(透明なガラスの花瓶に飾られた花束)、中央段は「a small green vace displays some small yellow blooms.」(緑色の小さな花瓶に黄色い花が飾ってある)、下段は「a slug crawling on the ground around flower petals.」(花びらの周りの地面を這うナメクジ)の記述に対して出力した3Dオブジェクト。

他にも、記述のテンプレートを作成し、一部の文言だけを入れ替えて出力したデモも紹介される。例えば、左上は「armchair in the shape of an avocado. armchair imitating avocado.」(アボカドの形をしたアームチェア)、左下は「a snail made of baguette. a snail with the texture of baguette.」(バゲットで作られたカタツムリ)の記述から生成された3Dオブジェクト。

この手法では、先行研究の「NeRF」(Neural Radiance Field)を応用したアプローチを提案。NeRFとは、複数の異なる視点の画像群から新たな視点ビューを作り出す技術のこと。

3次元の点の座標と視線方向を入力して、各座標の色と密度(不透明度)を示したRadiance Fields(輝度の場)を計算し3次元空間の物体の形状を出力する。出力した物体の異なる視点画像は、光の反射や透明な物体から透ける見え方なども再現しており、2020年の発表当時はその精度に驚く声が上がった。

しかし、自然言語の記述だけで新しいオブジェクトを作成する場合、入力に画像は利用できない。そこで、複数の視点の画像の再構成を学習するのではなく、テキストの意味と類似性を持つようにRadiance Fieldsを学習する。

このテキストとRadiance Fields間の意味的類似性は、2021年1月にOpenAIが発表した、4億ペアものキャプション付き画像(画像とその内容を説明するテキストのペア)で訓練した画像分類モデル「CLIP」 (Contrastive Language-Image Pre-Training)を使って学習する。NeRFとCLIPは微分可能であるため、各プロンプトに対してエンドツーエンドで最適化できる。

今回、研究チームは、学習方法にZero-shot learning技術を利用している。Zero-shot learningとは、機械が見たことないモノをこれまでの知っている知識から推論して予測する機械学習法を指す。

例えば、馬を学習した機械は、学習していない初めて見るシマウマを認識できないが、人間はシマウマを知らなくても馬に白色と黒色が付いた動物だと推論できる。このように、機械にも推論する力を与えるように学習するのがZero-shot learningとなる。これにより、見たことのない自然言語を入力しても推論し、それに近似した3Dオブジェクトを出力する。

Source and Image Credits: Jain, A., Mildenhall, B., Barron, J.T., Abbeel, P., & Poole, B. (2021). Zero-Shot Text-Guided Object Generation with Dream Fields. ArXiv, abs/2112.01455

関連記事

作業中に「ツンデレ」されるとやる気は高まるか? メイドアバターで、奈良先端大が検証

作業中に「ツンデレ」されるとやる気は高まるか? メイドアバターで、奈良先端大が検証

奈良先端科学技術大学院大学の研究チームは、冷たい対応と優しい対応を組み合わせた動作「ツンデレ」が作業意欲にどのような影響を与えるかを検証した。 「崖から落ちたけど、壁にナイフを刺して何とか助かったぜ…」を体験できるVR、東京電機大が開発

「崖から落ちたけど、壁にナイフを刺して何とか助かったぜ…」を体験できるVR、東京電機大が開発

東京電機大学松浦研究室の研究チームは、人が崖から滑落する際に、助かろうとナイフを斜面に突き立てて停止する動作を再現したVR触覚システムだ。落下から崖をナイフで刺し、しばらく引きずられて停止するまでの疑似体験を提供する。 「ポーズ」と「合言葉」がなければ開かない自動ドア、文教大が開発

「ポーズ」と「合言葉」がなければ開かない自動ドア、文教大が開発

文教大学川合研究室の研究チームは、音声と姿勢で認証する自動ドアの開閉システムを開発。自動ドアに設置したカメラで姿勢推定と音声認識を行い、あらかじめ決めておいたポーズと言葉が合致すれば開く。 電波を注入し、人間を充電器化 タイピングや車の運転中にスマートウォッチなどを充電

電波を注入し、人間を充電器化 タイピングや車の運転中にスマートウォッチなどを充電

米マサチューセッツ大学の研究チームは、キーボードに触ってタイピングした際に自動でスマートウォッチのバッテリーを充電するシステムを開発。人間の体を経由して電力を供給する。 犬から人へ電話をかけられる「DogPhone」 愛犬は飼い主にどのくらい着信を入れるか検証

犬から人へ電話をかけられる「DogPhone」 愛犬は飼い主にどのくらい着信を入れるか検証

スコットランドのグラスゴー大学と、フィンランドのアールト大学の研究チームは、犬から人のスマートフォンへビデオ通話をかけられるボール型IoTデバイス「DogPhone」を開発。くわえて動かすことで、飼い主に電話をかけられる。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR