“スマホのマイクでこっそり盗聴”を妨害する技術 静かな音で会話内容を改ざん:Innovative Tech

Innovative Tech:

このコーナーでは、テクノロジーの最新研究を紹介するWebメディア「Seamless」を主宰する山下裕毅氏が執筆。新規性の高い科学論文を山下氏がピックアップし、解説する。

米コロンビア大学の研究チームが発表した「Real-Time Neural Voice Camouflage」は、不正なマイクが取得したユーザーの会話の言葉を正しく聞き取れないようにする攻撃を提案した論文だ。無線で妨害音を発し、自動音声認識(ASR)システムをリアルタイムに混乱させ、本来盗聴側が取得したい会話を間違った形で認識させる。80%の確率でユーザーの言葉を誤認識させられたという。

この妨害音は、その場にいるユーザーの邪魔にならないような静かな音に最適化されている。

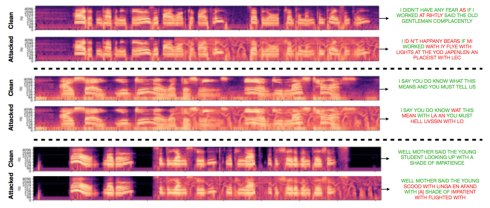

妨害を実際に行った3つの例。攻撃していない時の音声信号スペクトログラム(上)、攻撃した際の音声信号スペクトログラム(下)、右列に音声認識によるテキスト変換が表示されている。緑色がユーザーが会話した正解のテキストで、赤色が攻撃によって違う単語と誤認識させられたテキスト

妨害を実際に行った3つの例。攻撃していない時の音声信号スペクトログラム(上)、攻撃した際の音声信号スペクトログラム(下)、右列に音声認識によるテキスト変換が表示されている。緑色がユーザーが会話した正解のテキストで、赤色が攻撃によって違う単語と誤認識させられたテキストスマートフォンやIoT、音声アシスタントまで、今日では多様な機器にマイクが埋め込まれており、それらは常に音を聞いている可能性がある。さらに、自動音声認識システムを使って会話を常に処理している可能性がある。

この課題に対し今回は、自動音声認識(ASR)システムに対してリアルタイムに妨害を行い、マイクで不正に取得された音声を正しく処理できないようにするアルゴリズムを提案する。会話を妨害音(適切なささやき声)でカムフラージュする方法を採用し、自動音声認識システムが文字起こしする多様な単語を混乱させ、間違った解釈へ導く。

このような自動音声認識システムの改ざんは、理論的には以前から知られていたが、実用に耐える速度で実現することが大きなボトルネックになっていた。その会話に対して、効果的に妨害できる妨害音の瞬間的な生成が難しく、リアルタイムに攻撃するのが困難であった。

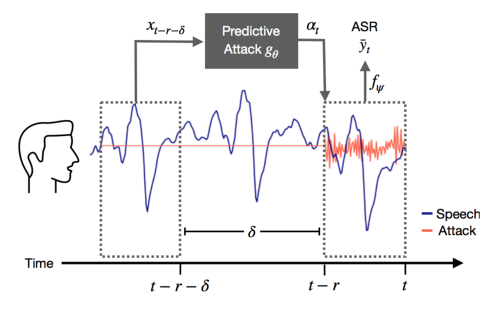

そこでこの研究では、数秒先の会話を予測しそれに対して最も有効な攻撃を予測する、予測攻撃を導入する。予測攻撃は、2秒間の入力音声を条件として、その先の会話に対する効果的な妨害音を予測し継続的に生成する。これによって、リアルタイム性能を達成する。

この妨害音は、通常の背景雑音に近い音量に最適化されており、部屋にいる人々に妨害音に気が付かれないようにしている。最終的には妨害音を完全に知覚できないようにしたいという。

実験では、予測攻撃がDeepSpeech認識システムを大きく破壊できることを示した。LibriSpeechでは、この手法がベースラインよりも単語のエラー率が少なくとも3.9倍増加し、文字のエラー率が少なくとも6.6倍増加した。

Source and Image Credits: Chiquier, Mia, Chengzhi Mao, and Carl Vondrick. "Real-Time Neural Voice Camouflage."

関連記事

ビデオ会議中、マイクが“ミュート”でも音が取得されている問題 米国チームが検証

ビデオ会議中、マイクが“ミュート”でも音が取得されている問題 米国チームが検証

米University of Wisconsin-Madisonと米Loyola University Chicagoの研究チームは、一般的なビデオ会議アプリにおいて、マイクをミュートにしている状態であっても音を取得できる可能性を指摘した論文を発表した。 自動運転車へのサイバー攻撃、米国の研究チームが実証 レーザー銃で「偽物の車が前から突っ込んでくる」錯覚攻撃

自動運転車へのサイバー攻撃、米国の研究チームが実証 レーザー銃で「偽物の車が前から突っ込んでくる」錯覚攻撃

米デューク大学と米ミシガン大学の研究チームは、自動運転車のセンサーをだまして、周囲の物体が検出距離よりも近い(または遠い)と信じ込ませる攻撃に成功し、搭載するカメラやセンサーの脆弱性を実証した。 心臓の音で個人認証、精度95%以上 音のリズムやピッチを分析

心臓の音で個人認証、精度95%以上 音のリズムやピッチを分析

スペインとイランの研究チームは、心電図から取得した心拍音を分析し、その人が誰かを特定するバイオメトリクス技術を開発した。心電図(ECG)信号をオーディオ波形ファイルに変換し、5つの音楽的特性を分析することで識別する。 メガネの鼻当てで個人を識別 スマートグラスやVRゴーグルのユーザー認証に活用

メガネの鼻当てで個人を識別 スマートグラスやVRゴーグルのユーザー認証に活用

メガネの鼻当てからソナーのように音を発信する。 超音波ブレスレットで盗聴を妨害 シカゴ大など開発

超音波ブレスレットで盗聴を妨害 シカゴ大など開発

ちょっと大きめのブレスレットだが、盗聴を邪魔する機能がある。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR