“視線で話す”アプリ「Look to Speak」 発話が不自由な人のコミュニケーションを支援 使い勝手は?:遊んで学べる「Experiments with Google」(第11回)

「Experiments with Google」は、Googleが人工知能(AI)や拡張現実(AR)といった最新技術の可能性を示すために、実験的な応用例を紹介するショーケースだ。膨大なコンテンツを公開しており、その多くはスマートフォンやPCで試せる。

この連載では、多種多様な応用例の中から興味深いものをピックアップ。実際に遊んだ体験レポートを通して、裏側にある技術を解説する。

読者の皆さんも、ぜひ自分の手で試しながらその仕組みを学んでもらえたらうれしい。きっと、最新技術の魅力に気付くはずだ。

発話が不自由な人の音声コミュニケーションを支援する「Look to Speak」

連載11回目の今回は、発話が不自由な人の音声コミュニケーションを支援するスマートフォン向けアプリ「Look to Speak」を紹介する。

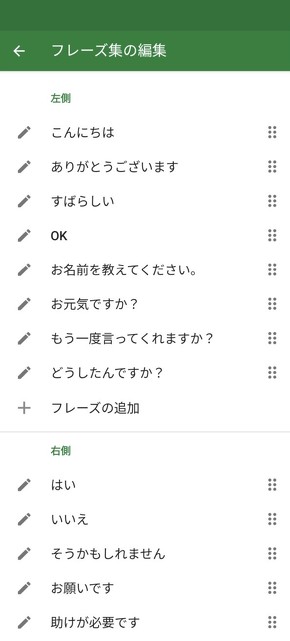

身体的な理由で喋ることが難しい人がLook to Speakを使えば、スマホを通して音声で自分の気持ちや考えを相手に伝えられる。アプリで発音できる内容は事前に登録したフレーズに限られるので、汎用性は高くない。ただし「こんにちは」「ありがとうございます」「もう一度言ってくれますか」「お水をください」など、自身がよく使うフレーズを設定しておけば、日常生活の助けになりそうだ。

Look to Speakは体を自由に動かせない人の利用を想定していて、基本的な操作は視線の移動だけで完結する。登録したフレーズの一覧が画面に表示されるので、視線を左または右に動かして発音させたいフレーズを選べる。家族や介助者に協力してもらってフレーズを設定しておけば、普段必要なコミュニケーションの相当部分をスムーズにこなせる。

スマホのカメラだけで視線を認識 喋りたいフレーズを視線で選ぶ

Look to Speakを使うには、スマホに無料のアプリをインストールする必要がある。現在はAndroid版アプリしか用意されていないようだ。

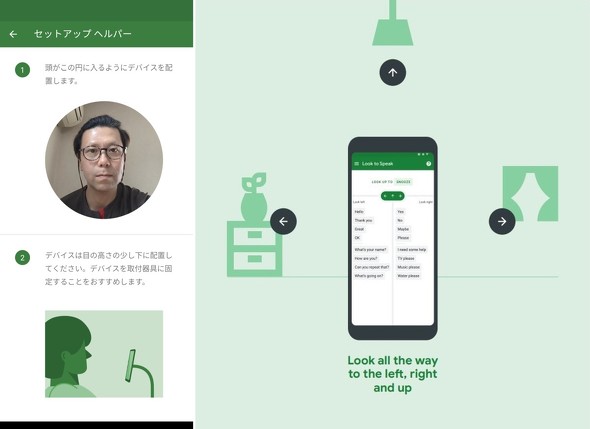

視線の動きは、スマホのインカメラで検知する。そのため、視線追跡用の特殊なカメラや専用のハードウェアは不要だ。多くの人が持っているスマホだけあればいい。

アプリを起動すると、最初に顔の位置を調整する画面が表示される。カメラが顔をきちんと捉えるよう、スマホの置き方を調整しよう。目の動きを正しく認識させるには、やや見下ろすような位置にスマホを置くといいらしい。スマホを動かないようしっかり固定することも大切だ。

視線を動かして、発音させたいフレーズを絞り込んでいく

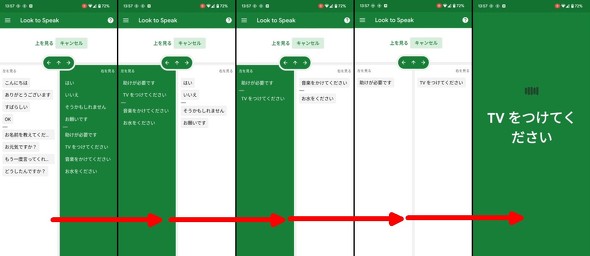

スマホ本体の調整が済んだら、実際に使ってみよう。画面の左右に候補のフレーズが表示されるので、発音させたいフレーズがある側に視線を向けて選択する。

例えば「TVをつけてください」と発音させたいときは、そのフレーズがある方に視線を向けて候補を絞り込んでいく。下記画像のケースでは視線を右、左、左、右と順番に動かして候補を減らしていき、最終的に目的のフレーズを選べばいい。

使う際は、視線をスマホの画面から離れた右や左まで極端に動かすことが大切だ。筆者が初めて使ったときは、選びたいフレーズがある方の画面を見つめるのだと誤解していて、うまく反応せず失敗してしまった。スマホの画面より外側に目標を設定して、そこに視線を向けるよう意識するとうまくいく。動かすのは視線だけで、顔を左右に向けないように注意しよう。

何も考えずいきなり使ったのだが、あっけないほど簡単に使えてしまった。眼鏡をかけていても、支障はない。顔認証やトレーニングといった準備も必要なく、本当に目の動きだけで操作可能だ。これなら体の動かせない人でも使いやすいだろう。

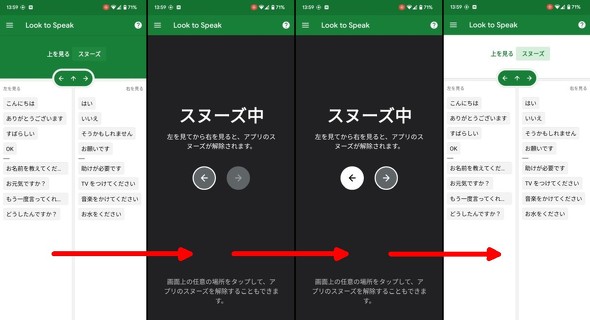

使わないときはスヌーズ機能で不必要な発音を防止

Look to Speakを使わないときは簡単にスヌーズ(機能を一度止めること)できる。フレーズ選択画面で視線を上方向に動かすと、スヌーズ状態になって視線の動きに反応しなくなる。使うつもりがないのに反応して音声が出るのは煩わしいので、この機能はありがたい。

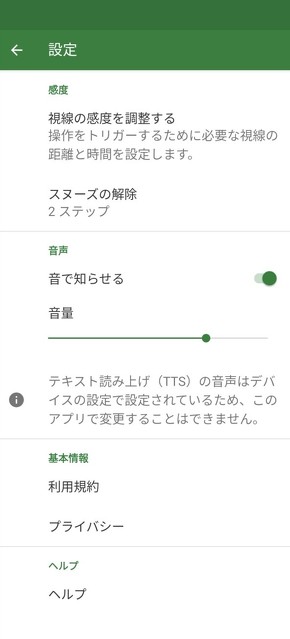

当然だが、スヌーズの解除も視線の動きだけでできる。「スヌーズ中」の画面に対して視線を左、右と順番に動かすと、フレーズ選択画面に戻る。

使いやすくするコツは、よく使うフレーズは上位にすること

視線だけで操作できるLook to Speakだが、使いたいフレーズの登録といった設定作業は視線操作ではできない。これは介助者に手伝ってもらう必要がある。

自分用のフレーズの追加や、不要なフレーズの削除は「フレーズ集の編集」画面でできる。使用頻度の高いフレーズを左側または右側の上位に入れておくと、すぐに選べるので使いやすくなる。

フレーズ設定の他、視線検知の感度調整やスヌーズ解除操作の変更も可能だ。

運動ニューロン疾患の患者が発案、Googleと共同で開発

Look to Speakは、体の不自由なSarah Ezekiel氏と、同氏をサポートする言語セラピスト(日本でいうと言語聴覚士のような立場)のRichard Cave氏が、米Googleの開発チーム「Creative Lab」とともに制作した。GoogleがExperiments with Googleを通じて、個人のアイデアを参考に役立つものを作り上げる取り組み「Start with One」の一環でもある。

Ezekiel氏は、2000年に運動ニューロン疾患と診断され、運動機能が徐々に衰えた。筋萎縮性側索硬化症(ALS)を含むこの病気の患者は、筋肉を次第に動かせなくなり、発声すらできなくなってしまう。

Ezekiel氏とCave氏は、日々のコミュニケーションを容易にする手段としてスマホやAIを活用できると考え、2020年にGoogleのチームと検討を始めた。こうしてLook to Speakが完成した。開発の経緯は、ブログ記事で紹介されている。

Look to Speakはシンプルで機能も少ない。しかしどこにでもあるスマホで動き、特別なセンサーを取り付けずすぐに使える特長がある。複雑な文章を発音させるには、専用のデバイスが必要だが用意するコストがかかる。手軽に誰でもすぐに使える点がLook to Speakの大きなメリットだ。

Googleは、Androidのアクセシビリティー機能として、顔の動きでスマホを操作する「Camera Switches」なども用意している。Look to SpeakやCamera Switchesのような成果物が広く公開されると、同じようなものを他のOSにも実装したり、さらに発展させた機能が開発されたりすることにつながり、多くの人に恩恵をもたらすかもしれない。小さな1歩が大きな社会的メリットへ発展することは、まさにStart with Oneが目指す将来像そのものだろう。

関連記事

Google、視線で操作できる会話アプリ 発話が不自由な人のコミュニケーションを支援

Google、視線で操作できる会話アプリ 発話が不自由な人のコミュニケーションを支援

Google、発話障害者をAIでサポートする「Project Euphonia」

Google、発話障害者をAIでサポートする「Project Euphonia」

リズムゲームを手で感じて操作できる視覚障害者向け“タブレット”「ThroughHand」

リズムゲームを手で感じて操作できる視覚障害者向け“タブレット”「ThroughHand」

視覚障害者のための“タブレット”は、マトリックス状に配置したピンの上下で手のひらに感じさせる。操作は手の甲に対して行う。 視覚障害者が街の行列に並べる支援技術 早大とIBMなどが開発

視覚障害者が街の行列に並べる支援技術 早大とIBMなどが開発

前に並んでいる人の動きや位置をスマートフォンだけで知ることができる。 AI搭載の“走るスーツケース”誕生へ 視覚障害者の移動をサポート IBMら5社が共同開発

AI搭載の“走るスーツケース”誕生へ 視覚障害者の移動をサポート IBMら5社が共同開発

視覚障害者が利用しやすい「AIスーツケース」の開発に向け、IBMら5社が社団法人を設立した。6月にプロトタイプを使った実証実験を行う。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR