文章から“3Dモデル”をAIが生成 米Googleなどが「DreamFusion」を開発:Innovative Tech

Innovative Tech:

このコーナーでは、テクノロジーの最新研究を紹介するWebメディア「Seamless」を主宰する山下裕毅氏が執筆。新規性の高い科学論文を山下氏がピックアップし、解説する。

米Google Researchと米UC Berkeleyの研究チームが発表した論文「DreamFusion: Text-to-3D using 2D Diffusion」は、テキストから3Dオブジェクトを生成するシステムを提案した研究報告だ。事前に学習したテキストから2D画像を生成する拡散モデルを用いて、テキストから3次元への合成を実行する。

テキストを条件に2D画像を生成するモデルは現在、高忠実度で多様かつ制御可能な画像合成をサポートしている。これらモデルの品質向上は、大規模な画像-テキストデータセットとスケーラブルな生成モデルアーキテクチャからもたらされる。

特に拡散モデルは、安定したスケーラブルなノイズ除去の目的を持つ高品質の画像生成器の学習に効果的である。拡散モデルを他のモダリティへの適用は成功しているものの、大量のモダリティ固有の学習データが必要である。

このアプローチを3D合成に適用するには、ラベル付けされた3Dアセットの大規模データセットと3Dデータのノイズ除去のための効率的なアーキテクチャが必要であるが、どちらも存在しないのが現状だ。

この課題に対して今回は、3Dやマルチビューの訓練データを必要とせず、事前に訓練された2D拡散モデル(2D画像のみで訓練)だけを用いて3D合成を行う手法を提案する。

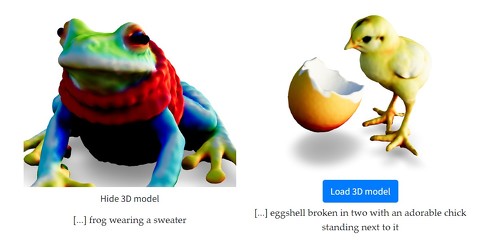

「DreamFusion」と呼ぶ今回の手法は、新しいScore Distillation Sampling(SDS)アプローチ(損失関数を最適化することによって拡散モデルからサンプルを生成)と3D生成タスクに特化したNeRFの改良型を組み合わせて、2D画像拡散モデルを3Dドメインに転送する。

これにより、ユーザーが提供する多様なテキストプロンプトに対し、高忠実度な3Dオブジェクトや3Dシーンが生成できる。また与えられた3Dオブジェクトを任意の角度から見たり、任意の照明で照らしたり、任意の3D環境に合成したりすることができる。

現在は64×64ピクセルの画像モデルを使用しているため、3D合成したオブジェクトは細かいディテールに欠ける傾向がある。より高解像度の拡散モデルと大きなNeRFを用いれば、この問題は解決すると思われるが、合成にかかる時間は現実的ではない。将来的には、これらの効率化により、高解像度で扱いやすい3D合成が可能になることを期待したい。

Source and Image Credits: Ben Poole, Ajay Jain, Jonathan T. Barron, and Ben Mildenhall. “DreamFusion: Text-to-3D using 2D Diffusion”

関連記事

Meta、動画生成AI「Make-A-Video」を発表 「肖像画を描くテディベア」などの作品公開

Meta、動画生成AI「Make-A-Video」を発表 「肖像画を描くテディベア」などの作品公開

Metaが動画生成AI「Make-A-Video」を発表した。「Stable Diffusion」や「Midjourney」、「DALL・E 2」などの画像生成AIの動画版。「浜辺を走るユニコーン」などの生成作品を公開した。 AI画家「DALL・E 2」、ウェイティングリスト削除で誰でもすぐ利用可能に

AI画家「DALL・E 2」、ウェイティングリスト削除で誰でもすぐ利用可能に

OpenAIは、文章から画像を生成するAI「DALL・E 2」(β)のウェイティングリストを削除した。誰でもサインアップすればすぐに使える。APIもテスト中だ。 文章から“動画”を自動作成するAI、中国の研究チームが開発

文章から“動画”を自動作成するAI、中国の研究チームが開発

中国の清華大学の研究チームは、簡単なテキストを入力に、その文章を基にした簡単な動画を自動作成する機械学習モデルを開発した。 画像生成AI「Stable Diffusion」がLINEのチャットbotに 九工大の学生が作成 日本語にも対応

画像生成AI「Stable Diffusion」がLINEのチャットbotに 九工大の学生が作成 日本語にも対応

画像生成AI「Stable Diffusion」を使ったLINEのAIチャットbotサービス「お絵描きばりぐっどくん」が公開された。文章を送ることで、AIが画像を生成する。 「神絵が1分で生成される」 画像生成AI「Midjourney」が話題

「神絵が1分で生成される」 画像生成AI「Midjourney」が話題

人間の指示をもとに画像を生成するAI「Midjourney」がTwitterで話題だ。Discordでイラストのお題を投稿すると画像を出力する仕組み。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR