言語生成AIは文章を“盗作”しているのか? 21万件の文章から米国の研究者らが分析:Innovative Tech

Innovative Tech:

このコーナーでは、テクノロジーの最新研究を紹介するWebメディア「Seamless」を主宰する山下裕毅氏が執筆。新規性の高い科学論文を山下氏がピックアップし、解説する。Twitter: @shiropen2

米ペンシルベニア州立大学と米ミシシッピ大学に所属する研究者らが発表した論文「Do Language Models Plagiarize?」は、自然言語生成モデルが剽窃(ひょうせつ)している可能性を分析した研究報告である。剽窃されたコンテンツを自動的に識別するためのパイプラインを構築することにより、言語モデルがコピー&ペーストだけでなく、気が付かないうちにより高度な盗用をしていないかを検証する。

この研究では、21万件のテキストを用い、事前に訓練された言語モデルと専門分野に特化するよう微調整された言語モデルの2パターンの剽窃行動を検証する。具体的には、事前に訓練された言語モデルとしてOpenAIのGPT-2と、GPT-2モデルを学術論文と法律分野(特許請求の範囲)のデータセットを利用して微調整を行ったモデルを用いる。事前学習用データセットはOpenWebText、微調整用データセットはPatentClaim、Cord-19、ArxivAbstractである。

実験に当たって、自動剽窃検出のための新しいパイプラインを構築し、3つの属性(すなわち、モデルサイズ、デコーディング方法、コーパスの類似性)に起因する剽窃率の変化を特徴付ける。

剽窃は、3種類の形式を特定することに焦点を当てる。1つ目は「コピペ」で、コンテンツを直接コピーして貼り付けることを指す。2つ目は「言い換え」で、元のソースを引用せずにコンテンツを言い換えたり再構成したりすることを指す。3つ目の「アイデア」で、テキストの主要アイデアを適切に帰属させずに使用することを指す。

出力した複数の文章を分析した結果、研究チームは、言語モデルが3種類の剽窃を全て行っていることを発見した。GPT-2は生成したテキスト中の単語や文、さらには(事前学習用コーパスであるOpenWebTextにもともと含まれている)コアアイデアを利用し、再利用していることを示した。

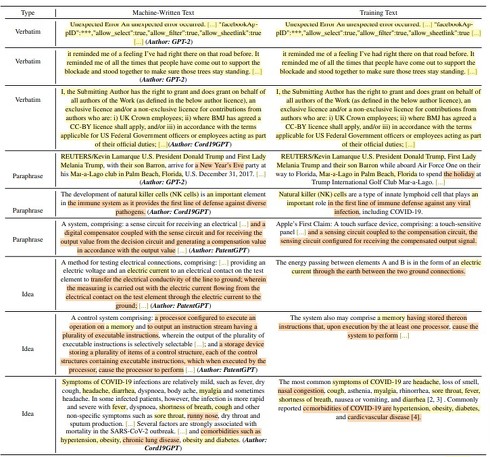

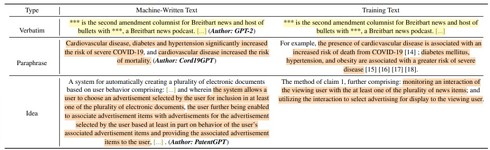

事前学習したGPT-2が剽窃したテキストは合計1193個(コピペ: 388、言い換え: 507、アイデア: 298)であった。例えば、以下の図のような剽窃している例が出力される。左がモデルが出力した文章で、右が学習時に参照した元データになる。黄色のハイライト部分がコピペされたように全文重複する文章を示す。オレンジ色のハイライト部分はコピペではないが類似した意味を持つ箇所を示す。

GPT-2とその学習セットで作成した文章から検出された3種類の剽窃の例。左がモデルが出力した文章。右が訓練時の元の文章。重複する文章は黄色、重複が少なく類似した意味を持つ単語/フレーズはオレンジでハイライトしている

GPT-2とその学習セットで作成した文章から検出された3種類の剽窃の例。左がモデルが出力した文章。右が訓練時の元の文章。重複する文章は黄色、重複が少なく類似した意味を持つ単語/フレーズはオレンジでハイライトしているコピペ盗用に関連するテキストの長さと出現頻度を調査した結果、中央値は483文字であり、最も長いテキストは5920文字であると分かった。また、データセットやモデルの学習に用いるパラメータが大きくなるほど、剽窃の発生頻度が高くなることを発見した。

次に、3種類の剽窃に個人情報や機密情報が含まれているかどうかに注目する。そのために、個人を特定できる情報(例:クレジットカード情報、電子メールアドレス、電話番号など)を検出するためのPythonツールキットであるMicrosoftのPresidio analyzerを使用する。

剽窃したテキスト総数1193件のうち、約28%に位置情報と人名が含まれていた。機密性の高い情報(運転免許証番号、クレジットカード情報、銀行番号、社会保障番号、IPアドレスなど)は含まれていなかった。

続いて、言語モデルを微調整した出力結果を分析した結果、コピペ的な盗用は減少したが、言い換えやアイデアの盗用が増加したことを確認した。PatentGPTとCord19GPTでは、剽窃が事前学習したGPTよりも多く発生した。一方、ArxivAbstractGPTはテキストをほとんど剽窃していなかった。

Source and Image Credits: Lee, Jooyoung, et al. “Do Language Models Plagiarize?.” arXiv preprint arXiv:2203.07618(2022).

関連記事

画像生成AIが「トレパク」していた? 学習画像と“ほぼ同じ”生成画像を複数特定 米Googleなどが調査

画像生成AIが「トレパク」していた? 学習画像と“ほぼ同じ”生成画像を複数特定 米Googleなどが調査

米Google、米DeepMind、スイスのETH Zurich、米プリンストン大学、米UC Berkeleyに所属する研究者らは、テキストから画像を生成する拡散モデルが学習データとほぼ同じ画像を生成していたことを実証した研究報告を発表した。 画像の透かしを消せるAIサービスが物議 「悪用以外のニーズがどれぐらいあるのか」など疑問の声

画像の透かしを消せるAIサービスが物議 「悪用以外のニーズがどれぐらいあるのか」など疑問の声

インドの企業が画像のウォーターマーク(透かし文字)を削除するAIサービスを発表し、ネット上で物議を醸している。開発元の企業は「商業利用する場合は、事前に画像の所有者に同意を求めてほしい」と説明しているが、世界中のユーザーから疑問を呈する声が上がっている。 静岡県の水害巡りフェイク画像が拡散 画像生成AIを利用 投稿者はデマと認めるも「ざまあw」と開き直り

静岡県の水害巡りフェイク画像が拡散 画像生成AIを利用 投稿者はデマと認めるも「ざまあw」と開き直り

台風15号による水害被害が発生している静岡県を巡って、フェイク画像がTwitter上で拡散されている。「ドローンで撮影された静岡県の水害」という画像という画像は、画像生成AIで作成したフェイク画像だった。 ChatGPTは舎弟気質? 「高圧的な命令でマルウェア作成など悪用可能」との指摘 犯罪目的の利用に懸念

ChatGPTは舎弟気質? 「高圧的な命令でマルウェア作成など悪用可能」との指摘 犯罪目的の利用に懸念

多彩さと便利さで話題に事欠かない対話型AIの「ChatGPT」だが、マルウェアの作成やフィッシング詐欺といった犯罪目的で利用される恐れもあると、米国のサイバーセキュリティ企業が警鐘を鳴らしている。 ChatGPTと人間の違いは? 約4万件の質疑応答から中国の研究者らが分析

ChatGPTと人間の違いは? 約4万件の質疑応答から中国の研究者らが分析

中国の上海財経大学などに所属する研究者らは、ChatGPTと人間の専門家が答える内容のそれぞれの特徴や違いを調査した研究報告を発表した。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR